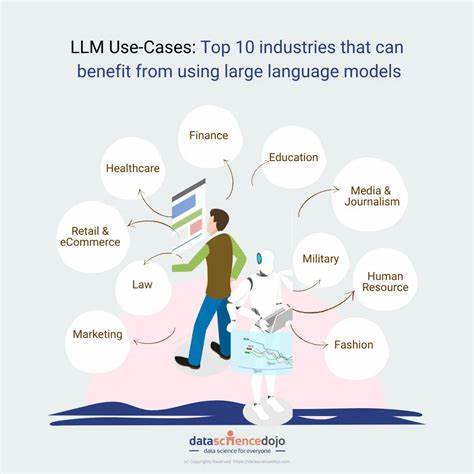

В современную эпоху искусственного интеллекта большие языковые модели (Large Language Models, LLM) приобретают колоссальное значение во всех сферах жизни — от помощи в написании текстов и программирования до сложного анализа данных и поддержки принятия решений. Несмотря на их бесспорную пользу, все чаще возникают вопросы о том, какую именно информацию LLM могут знать о своих пользователях и какие риски это несет для приватности и безопасности личности. Понимание особенностей работы таких моделей и их взаимодействия с пользователем становится ключевым элементом для формирования ответственного и безопасного цифрового пространства.LLM — это сложные алгоритмы, обученные на огромных массивах текстовых данных с интернета и других источников. Они способны создавать связные тексты, понимать контекст и даже выполнять узкоспециализированные задачи.

Однако при использовании этих моделей пользователи неминуемо делятся определенной информацией — будь то напрямую через вводимые запросы, либо косвенно — посредством анализа поведения, предпочтений и стиля общения. В результате именно этот слой взаимодействия зачастую обусловливает насколько LLM «знает» о конкретном человеке.С одной стороны, информация, хранящаяся и обрабатываемая LLM, помогает улучшать качество ответов, выполнять персонификацию и предлагать релевантные рекомендации. При наличии обратной связи и накоплении опыта взаимодействия модель может научиться лучше понимать индивидуальные потребности пользователя, сокращая время на получение нужной информации и повышая общую эффективность. Более того, в некоторых случаях LLM участвуют в многошаговых диалогах, где предыдущие сообщения становятся контекстом для последующих ответов, усиливая персонализацию и взаимодействие.

Однако с оборотом большой популярности и общемировым ростом использования подобных систем не уменьшается и масштаб угроз. Одна из ключевых проблем — это уязвимость, присущая самим процессам сбора, хранения и обработки пользовательских данных. В случае недостаточных мер безопасности или некорректных архитектурных решений информации могут стать доступны посторонним лицам или злоумышленникам. Такое раскрытие данных ведет к нежелательным последствиям, включая утечки личных сведений, слежку, манипуляции и мошенничество.Рассмотрим подробнее, какие категории данных в процессе работы LLM оказываются особенно чувствительными.

Прежде всего, это очевидно все вводимые пользователем тексты — от простых поисковых запросов до сложных личных сообщений, данных о состоянии здоровья, финансовой информации и прочего. Даже если сам алгоритм не хранит целиком историю общения, промежуточные сервера, на которых в момент взаимодействия производится обработка данных, могут регистрировать эту информацию. Также к потенциальным рискам относятся метаданные: время и частота запросов, IP-адреса и геолокация, используемые устройства, которые позволяют частично реконструировать профиль пользователя.Важным аспектом является также возможность моделей извлекать личную информацию из текстов, столкнувшихся с обучающим датасетом в ходе тренировки. Исследования показывают, что, несмотря на анонимизацию данных, в некоторых случаях LLM способны воспроизводить фрагменты информации, относящиеся к реальным лицам, например, адреса или телефонные номера, что создает дополнительные риски для конфиденциальности.

Безопасность LLM находится под наблюдением различных экспертов и организаций, изучающих возможные векторы атак и способы их нейтрализации. Одним из распространенных направлений исследований является выявление так называемых «временных уязвимостей» (time-of-check to time-of-use), когда между проверкой данных и их непосредственным использованием имеется промежуток, позволяющий злоумышленнику вмешаться и изменить входящую информацию с целью обмана модели или получения доступа к конфиденциальным функциям.Кроме того, в последнее время стали широко обсуждаться так называемые «атаки инъекций» (prompt injection), когда злоумышленники создают специально сформированные запросы, способные манипулировать поведением модели. Такие атаки могут быть направлены на выведение из строя фильтров безопасности, изменение логики выполнения или извлечение приватных данных из памяти модели.Не менее важен вопрос регулирования сферы разработки и внедрения языковых моделей.

Отдельные страны и международные организации активно работают над созданием норм, которые бы ограничивали неблагоприятные последствия сбора и обработки пользовательской информации. При этом соблюдение законов о защите данных (например, GDPR в Европе) накладывает на разработчиков обязательства обеспечить прозрачность, минимизацию объемов собираемой информации и предоставление пользователям контроля над своими данными.Помимо юридических аспектов, на повестке стоит и техническая составляющая защиты. Использование современных методов шифрования, анонимизации и «конфиденциального вычисления» позволяет сократить риски, связанные с неправильным обращением с данными. Внедрение многослойных механизмов мониторинга и реагирования на подозрительную активность снижает возможность эксплуатации уязвимостей.

Интересен также вопрос этики применения LLM и степени информированности пользователей о том, какую именно информацию они предоставляют при взаимодействии. Многие платформы в недостаточной мере информируют об этом, а порой принципиально не раскрывают детали, касающиеся хранения и анализа запросов. Образовательная работа и повышение цифровой грамотности пользователей становятся важной частью формирования ответственной культуры использования искусственного интеллекта.В перспективе развитие технологий может привести к появлению более защищенных и «приватных» моделей, ориентированных на децентрализацию обработки данных, уменьшение объема требуемых для обучения пользовательских сведений и усиление контроля пользователями за собственными данными. Технологии федеративного обучения и вычислений на устройстве (on-device computing) уже показывают положительные результаты, позволяя обрабатывать данные непосредственно на устройствах без передачи на внешние сервера.

Подводя итог, следует отметить, что большие языковые модели действительно обладают возможностями узнавать о своих пользователях достаточно много — от явной текстовой информации до косвенных признаков и закономерностей, выстроенных из анализа поведения. В то же время активное изучение угроз, совершенствование технической базы безопасности, соблюдение юридических норм и повышение осведомленности пользователей способны сделать взаимодействие с LLM более безопасным и прозрачным.Сбалансированный подход к вопросам приватности и развития технологий позволит обеспечить сохранность личных данных, не снижая при этом эффективности и инновационного потенциала искусственного интеллекта, двигающего человеческое общество вперед в цифровую эпоху.

![AI is the new outsourcing [video]](/images/DAFFC29D-7526-4CB6-9C09-3AF8F32B0366)