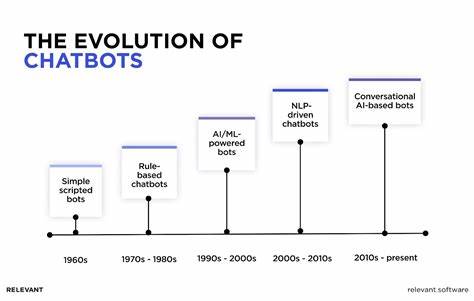

В мае 2025 года была выявлена серьёзная уязвимость в продуктах OpenAI, способная привести к неправильному раскрытию приватной информации пользователей. Исследователь в области безопасности обнаружил, что в некоторых случаях чат-боты способны выдавать ответы, предназначенные для других пользователей, включая личные данные, конфиденциальные бизнес-планы и даже проприетарный код. Несмотря на мгновенное автоматическое подтверждение получения сообщения, на протяжении 48 дней для решения проблемы не было предпринято никаких действий или человеческого общения с исследователем. Такая задержка вызвала значительные вопросы о культуре безопасности и реакции одной из самых влиятельных компаний в сфере искусственного интеллекта. Уязвимость, по сути, позволяла «подсматривать» за ошибочными или сконфигурированными сессиями других пользователей, что может нести серьёзные риски для конфиденциальности.

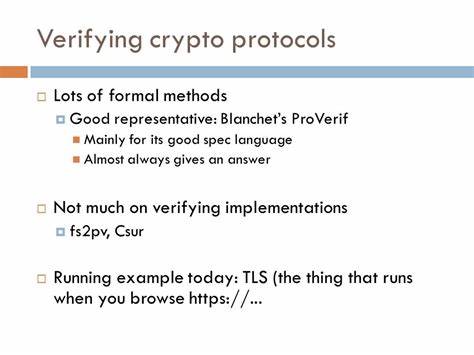

Исследователь отметил, что данные в ошибочных ответах не выглядели как галлюцинации модели, а имели вид реальных разговоров: ответы были контекстно связными, обращались к исходным вопросам и даже содержали сложный финансовый анализ компании с уникальным национальным именем. Этот факт особо убедительно демонстрировал, что речь идёт именно о настоящих данных, а не о случайно сгенерированных. Интересно, что исследователь решил напрямую направить свои результаты в официальную почту по вопросам безопасности OpenAI, а не использовать платформу Bugcrowd с её программой баг-баунти. Оно обосновано тем, что условия последней требуют строжайшей конфиденциальности, не позволяя публиковать какие-либо сведения о найденной уязвимости даже после её исправления. Такой подход противоречит общепринятым в сообществе безопасности принципам прозрачности и обмена знаниями, которые компании вроде Google принимают как часть стратегии эффективного реагирования.

Промедление с ответом и отсутствием оперативных мер привели к тому, что спустя 45 дней, принятых в индустрии как стандартный срок раскрытия по рекомендациям CERT/CC и ISO/IEC 29147, исследователь выложил ограниченное и технически нейтральное уведомление о проблеме. При этом он сдержанно не предоставил ни кода эксплуатации, ни детальных пошаговых инструкций во избежание возможного вредоносного использования. Случай с OpenAI свидетельствует о том, что большие и технологически продвинутые компании не всегда гарантируют зрелость своих систем безопасности. Использование передовых моделей и процессов с искусственным интеллектом не освобождает от необходимости живого участия специалистов, которые должны оперативно реагировать на проблемы и устранять критические уязвимости. Этот случай служит напоминанием о том, что никакая автоматизация не заменит человеческий контроль и эффективность процессов реагирования.

Кроме того, работа с облачными моделями языка сопровождается особенно высокой степенью ответственности из-за масштабов и объемов обрабатываемых данных. Небрежные ошибки конфигурации или баги могут привести к утечкам огромного числа приватных разговоров за считаные секунды. Это поднимает вопрос о том, что при разработке и эксплуатации сервисов искусственного интеллекта конфиденциальность должна быть фундаментальным приоритетом, а не последним пунктом в списке требований. Суть проблемы в техническом плане оказалась связана с ошибкой токенизации на уровне модели gpt-4o-transcribe, которая ответственна за транскрибирование аудиофайлов. В случае, если аудио превышало лимит в 1500 секунд, запрос обрезался до пустого, что приводило к генерации ответа на основе случайного начального токена.

Из-за особенностей построения больших языковых моделей с их вероятностным формированием текста эти ответы выглядели осмысленными и вполне реалистичными, включая тексты на разных языках и тематические блоки вроде финансовых отчётов с расчётами. При этом финансовые данные, хоть и выглядели конкретными, при перепроверке не соответствовали реальным показателям, что указывает на иллюзорный характер этих сгенерированных текстов. Первоначально подобное поведение было воспринято как утечка реальных пользовательских данных, однако позднее OpenAI предложили детальное объяснение и подтвердили, что уязвимость устранена, а некорректная работа связана именно с описанной аномалией обработки пустых запросов. Реакция OpenAI после 48 дней молчания свелась к техническому разъяснению и подтверждению, что патч для модели уже внедрен в промышленную эксплуатацию. Хотя исследователь принял извинения и признал, что изначально мог неверно интерпретировать ситуацию, данный инцидент подчёркивает важность оперативного и человеческого взаимодействия между разработчиками и сообществом безопасности.

Опыт раскрытия уязвимости демонстрирует важность политики открытого диалога и сотрудничества между исследователями и компаниями. Наличие официального и доступного механизма передачи проблем должно сопровождаться быстрой обработкой и коммуникацией, что позволяет не только устранить риски, но и сохранить доверие пользователей к сервисам и брендам. Пользователям рекомендуется внимательно относиться к тому, какую информацию они вводят в модели искусственного интеллекта, особенно если вопросы безопасности и конфиденциальности имеют критическое значение. Временное воздержание от передачи чувствительных данных до появления официального подтверждения исправления – разумный шаг для минимизации потенциальных рисков. Кроме того, сервисам и вендорам настоятельно рекомендуется внедрять прозрачные регламенты работы со службой безопасности и формализованные сроки реакции на сообщения о проблемах.

Регулярные внешние тесты безопасности, охватывающие не только классические уязвимости, но и специфические особенности взаимодействия разных моделей в облачной среде, становятся неотъемлемой частью комплексной стратегии защиты данных. Правильное стимулирование исследователей, включая поощрение участников баг-баунти, способствует формированию позитивного имиджа и расцвету внутренней культуры безопасности. Сознательное игнорирование или задержка рассмотрения серьёзных сообщений подрывает доверие и может привести к экологическим и имиджевым потерям. Итогом данного случая становится сигнал всем крупным игрокам индустрии: инвестиции в технологии должны сопровождаться такими же серьёзными вложениями в безопасность, процессы исправления и прозрачность. Пользователи связаны с сервисами искусственного интеллекта как никогда глубоко, и их приватность – не привилегия, а необходимость.

Профессионализм и открытый подход к устранению уязвимостей – ключ к долгосрочному успеху и доверию в эпоху ИИ.

![Open Problems in Geometry of Curves and Surfaces [pdf]](/images/9EAB1651-2BF3-4A5E-84FA-4D5DDACC7102)