Хеширование — одна из ключевых операций в программировании, без которой невозможны эффективные структуры данных, такие как хеш-таблицы и наборы. В языке Rust хеширование реализовано с учетом уроков, полученных из багов и уязвимостей других языков, таких как Python, Java и C++. Несмотря на это, существующие в экосистеме Rust подходы имеют свои ограничения, особенно когда дело касается производительности и адаптивности к различным задачам хеширования. Данное исследование посвящено анализу модели хеширования в Rust, выявлению проблем и обсуждению возможных путей дальнейшего развития. В традиционных языках программирования хеширование реализуется путем непосредственного вызова метода, предоставляющего готовое фиксированного размера значение хеша.

Такой подход, хоть и простой, имеет множество узких мест. Во-первых, вопрос того, как эффективно и безопасно хешировать примитивные типы, такие как целые числа — составляет весьма непростую задачу. Простейшим решением может стать использование «no-op» хешера, который буквально возвращает значение без модификаций, но это приводит к уязвимости к атаке типа DoS, когда хеш-таблица перестает эффективно функционировать из-за коллизий. Второй крайний вариант — тщательная перезапись и перемешивание числа — замедляет операции, которые могли бы ограничиться сравнением по хешу, например, проверки равенства или кеширования. Вопрос перемешивания хешей является отдельной головной болью.

Представители сообщества сразу сталкиваются с выбором между ленью и гарантией качества. Можно оставить эту задачу конечному пользователю, что, как показывает практика, приводит к изобретению собственных, зачастую уязвимых и низкопроизводительных схем перемешивания. Конкатенация с операцией XOR (x ^ y) кажется изначально простой, но создаёт критические слабости. Более продвинутые формулы вроде mix(x, mix(y, z)) в реальности оказываются уязвимыми из-за неправильного порядка перемешивания, что приводило к неоднократным CVE. Добавить высококачественный и при этом быстрый миксер сложно — в противном случае падает общая производительность.

Следующим камнем преткновения служит вопрос о том, как хеш-функции должны себя вести при работе с уже «рандомизированными» входными данными. Если данные изначально выглядят случайными, то трата ресурсов на дополнительное перемешивание можно расценивать как бесполезную потерю циклов и энергии. В то же время требования, предъявляемые к хеш-функциям, сильно влияют на их конструкцию — например, наличие или отсутствие явного эффекта лавины (avalanche effect) существенно меняет структуру функции. Полный эффект лавины обеспечивает хорошее рассеивание битовых изменений по всему хешу и отлично подходит для простых хеш-таблиц с размером, кратным степени двойки. Полуэффект лавины (half-avalanche) плохо совмещается с такими хеш-таблицами, но может работать с таблицами, размер которых — простые числа.

Ещё одна дилемма — необходимость или отсутствие конечной стадии финализации хеша: если хеш-функция полностью не финализирует результат (не обрабатывает его до финального состояния), то, например, использование строковых ключей становится неоптимальным, так как сам по себе неполный хеш уже достаточно рассеян. Rust выбрал крайне интересный и глубокий подход, чтобы избежать многих из этих проблем. Он разделил ответственность между типами объектов и хешерами. Объекты реализуют трейт Hash, что позволяет им преобразовывать свои внутренние значения в поток данных для хешера. Хешеры, в свою очередь, реализуют трейт Hasher, который принимает этот поток и преобразует его в уникальный числовой хеш.

Такая архитектура раздельной ответственности позволяет выбирать разные хешеры в зависимости от потребностей пользователя — будь то производительность, устойчивость, качество хеширования или безопасность. В теории эта организация обеспечивает потрясающую гибкость. Хеширование целого числа - дело простое: достаточно передать число в хешер, который сам решит, насколько детально его обрабатывать. Пользователю не нужно мучиться с собственным перемешиванием, так как хешер обеспечивает оптимальный алгоритм для конкретного случая. Если известно, что данные уже являются случайными (например, случайные ключи), то можно использовать более простой и быстрый хешер, вообще не меняя имплементацию Hash у типа.

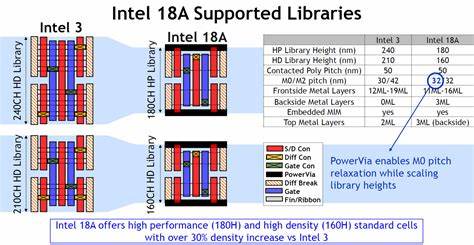

Хеш-таблицы могут использовать разные хешеры с разной степенью эффекта лавины и разным seed'ом, что защищает от DoS-атак и инновационно решает вопрос независимости хешей. Однако, на практике API Hasher в Rust (с набором методов write, write_u8, write_u16 и аналогов для других примитивов) ориентирован в основном на потоковое хеширование байт за байтом — своеобразный поток данных и соответствующая обработка. В эпоху современных криптографических и высокопроизводительных не крипто хешей такой подход часто оказывается менее эффективным, чем блочные хеши, которые поступательно поглощают фиксированные блоки данных за раз и после обработают их комплексно. Блочные хеши обладают меньшей латентностью за счет обработки данных не по одному байту (или слову), а целым блоком. Помимо снижения затрат на эффект лавины, блочные хеши могут эффективно использовать параллелизм и оптимизации архитектуры процессора.

Многие из ведущих хеш-функций, включая криптографические семейства SHA-2, а также топовые нерс cryptalg получили признание и популярность именно благодаря блочному подходу. Проблемы возникают, когда приходится смешивать это с API Rust Hasher, не дающим хешеру знать структуру данных и его длину, вместо чего предполагается возможность поглощения неограниченного набора байт по одному? Два основных варианта решения — заполнение или padding — всех входных блоков до фиксированного размера блока (ведь блочный хеш ожидает вход строго определенного размера) — состоит в прямом конфликте с производительностью. При малых размерах данных, например 8 байт, приходится искусственно расширить их до, скажем, 64 или даже 256 байт, что снижает производительность как минимум вдвое. Альтернатива — аккумулировать данные в промежуточном буфере и с большой задержкой отправлять блоки на хешер. Однако этот способ приводит к высокой сложности кода и зачастую к неэффективным ветвлениям.

Рассмотрим практический пример: Rapidhash, один из очень быстрых не криптографических хешеров с состоянием 24 байта, обрабатывает сразу 48 байт. Чистая постановка подачей блоков во внешний интерфейс Hasher приводит к избыточным конверсиям и падению скорости. Похожая ситуация с ahash (48 байт состояния, блок 64 байта) и meowhash (128 байт, блок 256 байт). Они являются одними из самых быстрых наличных хешеров в мире по результатам тестов SMHasher. Разгромить их производительность из-за несовместимости с текущей архитектурой API — цена, пожалуй, слишком велика.

Еще сложнее становится, когда для поддержки потокового интерфейса приходится реализовывать функцию write с буферизацией и копированием. Даже попытки ручной оптимизации с бескопированием проваливаются на уровне LLVM, который конвертирует вызовы по variable-length в мемкопии, что также негативно сказывается на производительности. Пример реализации с перемещениями слайда входных данных и накоплением в буфер внутри Hasher вызывает сложный, раздувающийся ассемблерный код. Даже для примитивной операции записи одного байта для хорошей скорости нужен оптимизированный битовый сдвиговый способ, как реализовано в siphash, где для слияния байтов используется битовое OR с усовершенствованной логикой сдвигов. Но и здесь проблемы не заканчиваются.

Поскольку write_* методы не знают текущего состояния буфера, их нельзя эффективно оптимизировать, что приводит к избыточному коду и ветвлениям, осложняющим распараллеливание и векторизацию. Комбинация маленьких инкрементальных вызовов сложнее оптимизируется, чем большой заранее известный блок. Важный момент — как решить, когда hash_code должен быть уже рассчитан в конце? Для обычных однородных срезов примитивных данных в Rust реализовано оптимальное преобразование всего массива в срез байт с помощью unsafe из-за отсутствия паддинга, что позволяет одному вызову state.write() громоздкого объема данных производить очень быстро. В то время как для новотипов, например, Tuple структур, применяется обычная рекурсивная хеш-вычислительная логика с последовательным вызовом hash для каждого поля, что на практике порождает значительные издержки и удестьняет время хеширования в несколько раз.

Множество тестов производительности убедительно показывают драматическую разницу между хешированием с оптимальным сжатием среза и поэлементным вызовом для новых типов. На объемах в сотни мегабайт задержка хеширования простого среза i32 сравнима почти в 5 раз короче, чем у структур с эквивалентом данных, реализующих Hash вручную. Это реальная проблема для высокопроизводительных приложений. Хотя некоторые хешеры, например siphasher, показывают меньшую деградацию благодаря продуманным оптимизациям в write, разрыв все же остается значительным. Между тем быстрорастущие хеши типа rapidhash и ahash не могут себе позволить большие накладные расходы именно из-за архитектуре API.

Разработка действительно универсального, быстрого хеша, который мог бы использовать все преимущества предварительного знания структуры данных, а также работать с произвольными входными данными и оставаться устойчивым и производительным — представляет собой сложность. Пример с UMAC-style схемой показывает, что для эффективного хеширования требуется заранее подготовленная константная таблица (seed), которую можно оптимально применить, только если известна длина и структура данных. Rust API Hasher же не параметризован типом, а должен позволять любые последовательности данных, что делает реализацию подобного подхода невозможной без знаний от Hash о самом объекте. Таким образом, корень проблемы кроется в несоответствии уровней абстракции — Hasher не имеет доступа к структуре данных, в то время как именно её знания могли бы существенно повысить производительность. Идея, которая высказывается в профессиональной среде, состоит в том, что вместо того, чтобы Hash был простым драйвером для Hasher, сама реализация Hash могла бы позволять интроспекцию структуры и помогать Hasher'у управлять потоком рекурсивно и более эффективно.

Это требовало бы значительной переработки или расширения текущего интерфейса в Rust, чтобы ввести понятия «начало» и «конец» структур, передавать индексы и размеры полей, и даже возможно — иметь прямую поддержку для векторизации или специальных хешей для продуктов и суммовых типов. Рассмотрение таких расширений и компромиссов — предмет живых дискуссий в сообществе Rust. Нельзя обойти стороной и попытки других языков, которые берут иной путь. В C++, Java и Python чаще всего поля продукта хешируются одинаково независимо от состояния других полей, что упрощает код, но сказывается на производительности в сложных случаях. Специализация Rust, хотя и обещает решить часть задач за счет более конкретных реализаций для определенных типов, сталкивается с глубокими ограничениями, связанными с компоновкой данных и деталями, требующими linearization структуры в памяти.

Финальное заключение может быть сформулировано так: современные черты и ограничения Rust хешинга обусловлены балансом между универсальностью API и потребностями высокоскоростных, специфичных под архитектуру решений. Пребывание без возможности передавать информацию о структуре и размерах данных в Hasher радикально тормозит пути оптимизации. Будущее за развитием API, более тесно интегрированных с introspection, позволяющих комбинировать безопасность и скорость. В целом, размышления и критику системы хеширования в Rust невозможно воспринимать как простое нытье — это попытка обязательно сделать Rust быстрым, безопасным и современным языком, который не отстает в базовых инфраструктурных задачах от языков с историей в десятки лет. При грамотном развитии и новых идеях архитектура хеширования Rust сможет стать не только более быстрой, но и более гибкой.

Новые подходы также могут облегчить создание криптографически стойких и одновременно очень быстрых хешей, что открывает перспективы для широкого круга приложений — от системного программирования до высоконагруженных веб-сервисов и криптовалютных проектов.