В последние годы технологии автономного вождения стремительно развиваются, и одним из пионеров в этой области является компания Tesla. Однако недавние события в ходе судебного разбирательства, связанного с аварией с участием автомобиля Tesla на автопилоте, пролили свет на важный аспект: признание инженера Tesla о том, что компания не вела учёт аварий, связанных с её системой автопилота, до 2018 года. Этот факт вызывает множество вопросов о безопасности, ответственности и прозрачности автопилотируемых систем компании, а также играет важную роль в текущих судебных процессах. В этой статье мы подробно разберём, что именно произошло, почему это важно и какие выводы можно сделать для всех пользователей и заинтересованных лиц в области автономных технологий. Tesla начала развивать и внедрять систему автопилота задолго до 2018 года – её запуск состоялся примерно в 2015 году.

За несколько лет до признания инженерного лица об отсутствии системного сбора данных о авариях с автопилотом, компания активно продвигала свои технологии, обещая безопасность и комфорт на новом уровне. Однако факт отсутствия ведения сбора аварийных данных до марта 2018 года существенно осложняет понимание безопасности и эффективности системы. То есть, первые три года у Tesla просто не было полной статистики, позволяющей объективно оценить, насколько автопилот снижает или увеличивает риск аварийности. В судебном процессе, связанной с трагической смертельной аварией в Майами, где водитель на автопилоте не остановился на знаке стоп и столкнулся с припаркованным автомобилем, пострадавшие обвиняют не только водителя, но и Tesla. Согласно обвинению, Tesla создала ложное чувство безопасности у водителей, способствовала чрезмерной уверенностью и даже пренебрежением к правилам дорожного движения.

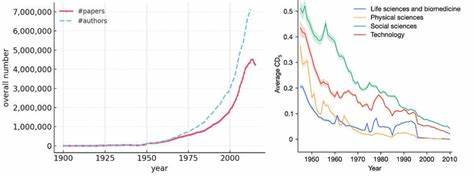

Кроме того, истцы утверждают, что компания не внедрила адекватные системы контроля за вниманием водителей, что могло предотвратить подобные инциденты. Адвокаты использовали показания инженера программного обеспечения Tesla, Акшая Фатака, который признал, что до марта 2018 года компания не собирала и не анализировала аварийные данные, связанные с включённой системой автопилота. Такая практика ставит под сомнение весь подход Tesla к безопасности и ответственности, ведь без данных невозможно адекватно оценивать реальные риски и разрабатывать меры по их снижению. Важность ведения контроля и анализа аварийных случаев невозможно переоценить. Подобная информация служит основой для улучшения алгоритмов автопилота, обучения системы и даже информирования пользователей о потенциальных опасностях.

Отсутствие таких данных в первые годы эксплуатации технологии означает, что Tesla не учитывала обратную связь от реальных инцидентов, что могло привести к небезопасным ситуациям на дорогах. При этом следует отметить, что Tesla неоднократно оспаривала необходимость полной прозрачности по вопросам аварийности своей системы и пыталась ограничить публикацию данных, ссылаясь на коммерческую тайну и опасения для конкурентоспособности. Такой подход вызывает критику экспертов и пользователей, которые считают, что безопасность на дорогах должна быть приоритетом над корпоративными интересами. Экспертные оценки также подтверждают существующие проблемы. Например, исследование Национального управления безопасности дорожного движения США (NHTSA) выявило, что функция Autosteer Tesla связана с увеличением вероятности срабатывания подушек безопасности более чем в два с половиной раза.

Такие данные вызывают тревогу в отношении реальной эффективности автопилота в предотвращении аварий. Интересно обратить внимание на то, что в январе 2023 года Tesla приняла решение исправить некоторые ошибки в предыдущих отчётах по безопасности автомобилей. В частности, после корректировок стало ясно, что показатели аварий без включённого автопилота выросли на 50%, тогда как показатели при включённом автопилоте остались примерно на том же уровне. Это свидетельствует о необходимости более точной и честной подачи информации со стороны производителя, ведь размытые или изменённые данные могут вводить общественность в заблуждение. Дополнительно к судебному процессу привлекаются эксперты разного профиля, включая учёных и специалистов в области автономных систем, которые подчеркивают необходимость определённых улучшений не только в технической части автопилота, но и в плане регулирования его использования и особенностей контроля со стороны водителя.

Учитывая всё вышеизложенное, важным становится вопрос доверия между автопроизводителем и покупателем. Наличие достоверных данных и прозрачность в вопросах аварийности создают основу для того, чтобы пользователь понимал риски и мог принимать обоснованные решения. Признание Tesla о том, что учёт аварий до 2018 года не велся, снижает уровень доверия и заставляет задаться вопросом, насколько компания действительно заботится о безопасности. Будущее автопилотируемых технологий во многом зависит от того, насколько производители будут открыты и внимательны к безопасности. Компании должны не просто предлагать инновации, но и нести ответственность за последствия их внедрения.

Публичные обсуждения и судебные процессы, подобные тому, что происходит сейчас с Tesla, стимулируют развитие нормативных требований и стандартов, которые сделают дороги безопаснее для всех участников движения. Для пользователей Tesla и автолюбителей в целом это сигнал к осторожности при использовании систем автономного вождения. Несмотря на все маркетинговые заявления и обещания, важно понимать, что автомобиль с автопилотом всё еще требует внимательного контроля со стороны водителя и соблюдения правил дорожного движения. В заключение можно сказать, что признание Tesla об отсутствии учёта аварий с автопилотом до 2018 года открывает новый этап понимания вызовов и проблем, связанных с автономным вождением. Это привлекает внимание общественности, регулирующих органов и самих производителей к вопросу надёжности данных, прозрачности и ответственности в быстроразвивающейся сфере.

Правильное реагирование на эти вызовы позволит сделать технологии автономного вождения действительно полезными и безопасными для миллионов людей по всему миру.