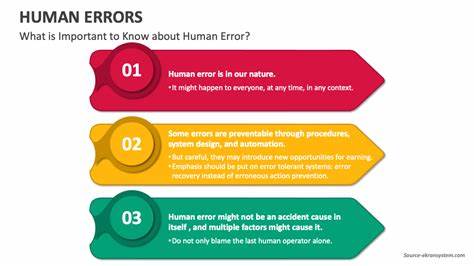

В современную эпоху технологий искусственный интеллект (ИИ) становится все более интегрированным в повседневную жизнь человека. Он помогает решать сложные задачи, оптимизировать работу, повышать продуктивность и облегчать обучение. Однако растущая зависимость от ИИ порождает интересный вопрос: стоит ли искусственному интеллекту делать ошибки намеренно, чтобы поддерживать умственные способности пользователей и не дать им деградировать в результате бездумного доверия к автоматизации? Идея о том, что ИИ мог бы допускать ошибки, чтобы пользователь не расслаблялся слишком сильно и оставался внимательным, обсуждается в различных научных и технологических кругах. Предполагается, что случайные или преднамеренные ошибки могут стимулировать когнитивную деятельность, способствовать развитию критического мышления и предотвращать пассивное потребление информации. Такой подход в теории мог бы помочь замедлить процесс когнитивного упадка, который зачастую связан с чрезмерной автоматизацией и снижением электронного внимания.

Конечно, первая реакция большинства людей при мысли о намеренных ошибках ИИ будет отрицательной. Ошибка, допустимая искусственным интеллектом, может вести к распространению неверной информации и подрывать доверие к технологиям. В случае, если пользователь не осознает, что ошибка намеренная, он рискует принять ложные данные за истину, что может привести к негативным последствиям в разных сферах – будь то образование, медицина, финансы или просто повседневное общение. Одним из разумных компромиссов является идея предупреждать пользователя о том, что в работе ИИ будет закладываться определённый процент намеренных ошибок. Это может помочь людям подходить к информации с должной критичностью и стимулировать их задумываться, анализировать и проверять полученные данные.

Таким образом, ошибки становятся своего рода образовательным инструментом – сигналом, который заставляет пользователя включать более активные когнитивные ресурсы. Подобный подход можно сравнить с образовательной тактикой «эффекта теста», когда ученик запоминает и лучше усваивает информацию, выполняя проверочные задания. Если ИИ периодически будет демонстрировать свои ограничения и ошибки, это будет способствовать развитию у пользователя навыков самоконтроля, анализа и скептицизма – качеств, которые имеют большое значение в эпоху информационного перенасыщения. С другой стороны, нельзя игнорировать моральные и этические вопросы, связанные с преднамеренным введением ошибок. Искусственный интеллект традиционно рассматривается как инструмент, призванный помочь, а не навредить.

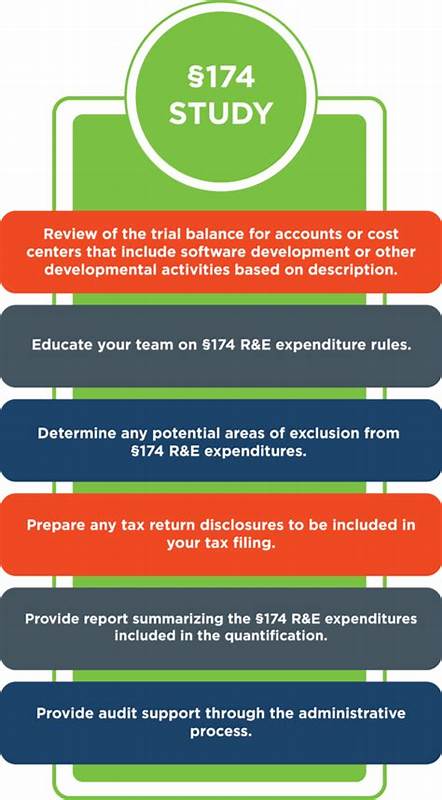

Вводя баги целенаправленно, разработчики должны учитывать возможный вред для пользователей, особенно если речь идет о сферах, где критична точность – медицинская диагностика, юридические консультации, финансовое планирование. Еще один аспект – это дизайн пользовательского опыта (UX). Чтобы избежать фрустрации и потери доверия, ИИ должен быть крайне прозрачен в своих действиях. Пользователь должен понимать цель и смысл ошибок, чтобы не воспринимать их как сбои системы или непрофессионализм. Прозрачность и честность станут ключевыми факторами, позволяющими подобной системе успешно сосуществовать с пользователями.

Нельзя забывать и о том, что разные категории пользователей по-разному воспримут идею ошибок. Для одних это может быть полезным тренировочным методом, а для других – поводом отказаться от использования ИИ. Особенно это касается людей с низким уровнем цифровой грамотности или тех, кто полагается на технологии из-за ограниченных возможностей самостоятельно анализировать информацию. Применение преднамеренных ошибок может быть оправдано в образовательных программах, где ИИ выступает как интерактивный преподаватель. В этом случае случайные загадки и неточности стимулируют процесс обучения, заставляют учащихся задумываться и делать выводы своими силами.

Аналогично, в тренажерах и научных симуляторах можно использовать искусственные ошибки для отработки навыков диагностики и принятия решений. В будущем, с развитием технологий, вероятно появятся интеллектуальные системы, адаптирующие количество и частоту таких ошибок под индивидуальные особенности каждого пользователя. Машинное обучение и персонализация позволят создать гибкие модели, балансирующие между точностью и стимуляцией мозга, сохраняя доверие и эффективность. Таким образом, вопрос о том, стоит ли искусственному интеллекту специально ошибаться для поддержания остроты человеческого разума, остается актуальным и требует комплексного подхода. Это баланс между пользой когнитивной нагрузки и риском распространения недостоверной информации.

При правильной реализации и прозрачности такие механизмы могут стать инновационным инструментом развития и поддержания интеллектуального здоровья в условиях цифрового общества. В конечном итоге будущее взаимодействия человека и искусственного интеллекта будет зависеть от того, насколько мы сумеем гармонично сочетать возможности машин с потребностями человеческого мышления, сохраняя критичность и осознанность при использовании цифровых технологий.