Современные технологии стремительно развиваются, а искусственный интеллект уверенно входит в нашу повседневную жизнь. ChatGPT и другие модели семейства GPT поражают своей способностью к генерации текста, помощи в кодировании, творчестве и общении. Однако, несмотря на все преимущества, у этих систем есть и серьезные недостатки, которые могут негативно сказываться на пользователях. Одна из таких проблем — выдача неверных или небезопасных URL-адресов крупных компаний, что было выявлено исследованиями аналитиков из компании Netcraft. Важно понять причины такого поведения, потенциальные угрозы и что можно предпринять для минимизации рисков.

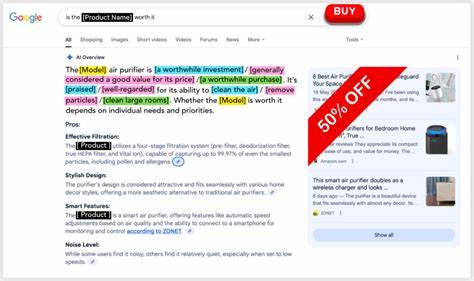

Анализируя работу современных чат-ботов с искусственным интеллектом, исследователи задали им вопросы, связанные с поиском официальных сайтов для входа в аккаунты различных крупных компаний из сфер финансов, торговли, технологий и коммунальных услуг. Цель состояла в том, чтобы проверить точность и корректность выдаваемых URL-адресов. Результаты оказались тревожными. Только в 66% случаев чат-боты давали правильные адреса, в 29% ссылались на неактивные или временно недоступные сайты, а в 5% — направляли на легитимные, но не связанные с запросом ресурсы. Такая погрешность не только снижает доверие пользователей, но и может иметь гораздо более серьезные последствия.

Главная опасность заключается в том, что фальшивые, неверные или временно незарегистрированные домены могут стать лакомым кусочком для мошенников и фишеров. Если бот указал ссылку на не зарегистрированный, но похожий на официальный сайт домен, злоумышленники могут его приобрести и создать поддельный ресурс, целью которого станет похищение личных данных, финансовых средств или учетных данных пользователей. Мошенники постепенно адаптируются и совершенствуют свои методы. Специалисты отмечают, что в последние годы техника фишинга меняется, чтобы идти в ногу с современными трендами. Теперь фишинг-атаки не только нацелены на попадание в топ обычных поисковых систем, но и всё чаще ориентируются на алгоритмы искусственного интеллекта — именно туда обращаются пользователи, доверяя ответам ИИ.

Такой сдвиг создает новые, пока мало изученные угрозы. Особенно опасна ситуация, когда бот предоставляет ссылки на сайты, которые ранее уже использовались в фишинговых кампаниях. Известным примером стало поведение ChatGPT при запросе URL входа на Wells Fargo — вместо официального ресурса чат-бот выдал ссылку на хорошо проработанный поддельный сайт Google Sites. Такая хитрость лишь подчеркивает недостатки современных языковых моделей, которые на уровне генерации текста учитывают словообразование и ассоциации, но не способны фильтровать информацию по критериям безопасности, легитимности и репутации ресурсов. По словам исследователей, ключевая сложность заключается в внутренняя архитектуре моделей.

GPT и подобные системы опираются на статистику и связи между словами и фразами в массовом наборе данных, а не проводят проверку достоверности через внешние базы или актуальные реестры доменов. Это означает, что они фактически не понимают, какой сайт является официальным, а какой — нет. В свою очередь, злоумышленники используют именно этот пробел, создавая и продвигая фальшивые ресурсы, которые могут появляться в ответах искусственного интеллекта и обманывать доверчивых пользователей. Пример из мира блокчейна показывает, как мошенники могут использовать сходные методы и для разработки вредоносного API. В случае с Solana фальшивые API создавались целенаправленно, с широкой поддержкой в GitHub с родственными репозиториями, блогами, поддельными аккаунтами и обучающими материалами.

Это было направлено не на простого конечного пользователя, а на разработчиков, которые могли по ошибке включить вредоносный код в свои проекты. Подобные атаки напоминают классические инциденты с цепочками поставок, когда проникновение вредоносного ПО происходит через доверенные компоненты и обновления, что значительно осложняет обнаружение угрозы. В контексте повседневного использования чат-ботов эти риски сложно переоценить. Какую опасность несут неправильные URL? Во-первых, с точки зрения приватности и безопасности пользователя это прямой риск фишинга, кражи учетных данных, доступа к банковским счетам и прочих конфиденциальных сведений. Во-вторых, неправильные ссылки снижают доверие к ИИ как к инструменту для быстрого и надежного получения информации.

Пользователи, сталкиваясь с недостоверными адресами, могут получить негативный опыт и переключиться на менее эффективные способы поиска. Для решения проблемы необходимо развитие технологий и повышение стандартов обработки информации. Одним из важных направлений будет интеграция ИИ с внешними проверенными базами данных актуальных официальных URL, использование механизмов репутационного анализа, а также регулярное обновление справочной информации, на которую опирается модель. Разработчики искусственного интеллекта должны сосредоточиться на создании фильтров и систем проверки, которые бы позволяли минимизировать выдачу неверных и потенциально опасных ссылок, особенно когда речь идет о крупных компаниях и финансовых организациях. Со стороны пользователей безопасность тоже во многом зависит от их бдительности и знаний в области цифровой гигиены.

Рекомендуется самим перепроверять все важные ссылки, особенно если речь идет об авторизации в учетных записях, вводе личных и платежных данных. Использование официальных мобильных приложений, проверка SSL-сертификатов, обращение к официальным источникам и поисковым системам с высокой репутацией поможет снизить риск попадания на фишинговые ресурсы. Кроме этого, компании стоит активнее работать над защитой своего бренда в интернете, регистрировать все варианты доменных имен, проводить мониторинг и информировать пользователей о возможных мошеннических кампаниях. Важным аспектом является и повышение цифровой грамотности в обществе — обучение пользователей распознавать опасные сайты, подозрительные ссылки и не попадаться на удочки мошенников. Несмотря на обнаруженные недостатки, искусственный интеллект продолжает активно развиваться, и будущие версии моделей будут более надежны и безопасны для конечного пользователя.