Программирование параллельных компьютеров становится все более актуальной темой с учетом стремительного роста вычислительных мощностей и многоядерных архитектур. В современном мире невыполнение потенциала параллелизма означает потерю значительной части вычислительной производительности, что недопустимо для производительных и масштабируемых приложений. Современные процессоры оснащены множеством ядер с расширенными вычислительными возможностями, а графические процессоры, изначально предназначенные для обработки графики, теперь выступают в роли универсальных вычислительных устройств. Чтобы максимально эффективно использовать такие ресурсы, разработчикам необходимо овладеть принципами параллельного программирования и научиться преобразовывать последовательные алгоритмы в параллельные. Причины востребованности параллелизма кроются в архитектуре современных вычислительных систем.

Однопоточная производительность процессоров практически достигла предела, и для дальнейшего роста скорости вычислений производители пошли путем увеличения числа ядер и создания специализированных вычислительных блоков. Например, многокорные процессоры могут одновременно исполнять сотни арифметических операций, используя многоуровневые структуры, такие как векторные инструкции и конвейеризацию. Каждый ядро зачастую содержит несколько исполнительных блоков, способных оперировать параллельно, что дает огромный потенциал для ускорения вычислений. Однако простая возможность не гарантирует автоматического роста производительности. Для того чтобы программа действительно раскрыла потенциал параллелизма, разработчик должен задуматься о том, как распараллелить задачи и эффективно использовать ресурсы процессора.

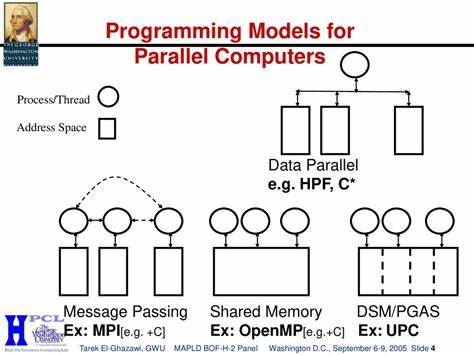

Без этого большинство программ используют лишь малую долю доступных вычислительных мощностей — иногда менее одного процента. Такая неэффективность характерна для наивных решений и программ, изначально рассчитанных на последовательное исполнение. Современные технологии программирования параллельных систем основаны на нескольких ключевых концепциях: разделение задачи на независимые подзадачи, управление потоками выполнения и синхронизация доступа к общим ресурсам. Многочисленные инструменты и библиотеки, такие как OpenMP, Threading Building Blocks (TBB) и различные модели параллельного программирования, существенно упрощают процесс оптимизации кода для многоядерных CPU. Тем не менее, даже такой подход требует глубокого понимания особенностей аппаратуры для избежания узких мест и достижения максимальной эффективности.

Нельзя не упомянуть графические процессоры (GPU), которые за последние годы превратились в одни из самых мощных вычислительных платформ. Их архитектура ориентирована на высоко параллельные вычисления с огромным количеством потоков, что идеально подходит для задач, требующих массовой обработки данных, таких как машинное обучение, симуляции, рендеринг и криптография. В отличие от CPU, GPU способны выполнять одинаковые операции над большими массивами данных с колоссальной скоростью. Для использования GPU разработчикам приходится писать специальный код, используя такие платформы, как CUDA или OpenCL. Хотя это требует дополнительных усилий, освоение этих технологий открывает доступ к невероятным вычислительным ресурсам.

Однако программирование GPU и высокопараллельных CPU — это не только написание множества потоков. Важным аспектом является управление памятью и эффективное взаимодействие между вычислительными блоками. Кабеля пропускной способности памяти и латентность доступа могут сильно повлиять на производительность, поэтому грамотное распределение данных по кэшам и потокам — критически важный навык. Архитектурные особенности современных процессоров, такие как конвейеризация команд, ветвления и использование SIMD-инструкций (одинаковая операция над несколькими данными), требуют тщательного анализа при написании параллельного кода. Задачи оптимизации параллельных программ разнообразны и зависят от многих факторов, включая характер вычислений, структуру данных и тип нагрузки.

Важно не просто увеличить количество потоков, а добиться высокой загрузки всех исполнительных единиц и эффективного использования кэша процессора. Часто встречающиеся проблемы — блокировки ресурсов, гонки данных, неоптимальное распределение нагрузки и межпотоковое взаимодействие — приводят к снижению скорости или даже негативному эффекту от параллелизации. В университете Аалто проводится курс cs-e4580 Programming Parallel Computers, где разбирают все эти аспекты подробно и на практике. Материал курса охватывает не только написание параллельного кода на C и C++, но и углубленное изучение производительности на уровне машинных команд и архитектуры процессора. Это помогает лучше понимать, как работает «железо» и как разрабатывать приложения с высоким коэффициентом использования вычислительных ресурсов.

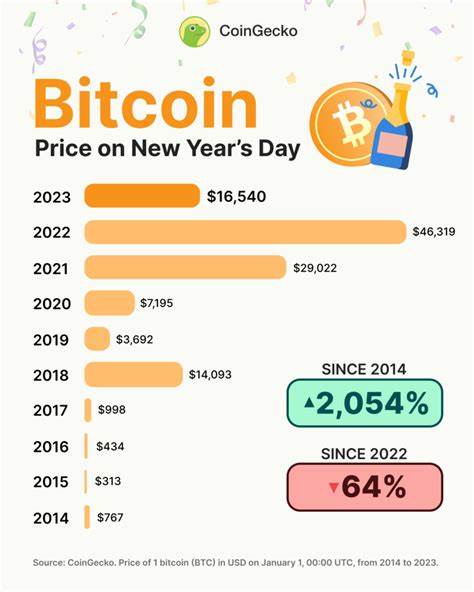

Курс предлагает практические задания и эксперименты, что способствует более быстрому освоению навыков. Одним из интересных примеров улучшения кода можно назвать последовательное улучшение версии программы от базового варианта до оптимального. В демонстрации с четырехъядерным Intel CPU базовое последовательное решение использовало всего 2% мощности одного ядра, и лишь 0,6% всех ядер. Через ряд улучшений достигается рост скорости в десятки и сотни раз. Это иллюстрирует, что просто добавить несколько потоков — недостаточно.

Нужно оптимизировать алгоритмы с учетом специфики архитектуры — векторных инструкций, конвейеров и многопоточности. Программирование параллельных компьютеров — это не только вызов, но и огромная возможность для разработчиков повысить производительность своих программ. С каждым годом процессы параллелизации становятся все более простыми и доступными благодаря новым инструментам и библиотекам. Но ключом к успеху остается глубокое понимание архитектуры современных вычислительных систем и правильный выбор стратегии распараллеливания для конкретной задачи. Подводя итог, можно выделить несколько важных аспектов, которые необходимо учитывать при разработке параллельного программного обеспечения.

Прежде всего, это необходимость изучения принципов работы процессоров и GPU, а также освоения соответствующих языков и библиотек. Дополнительно важно уделять внимание профилированию и оптимизации кода на низком уровне, чтобы выявлять и устранять узкие места. При грамотном подходе программирование параллельных компьютеров перестает быть сложной и непостижимой задачей, превращаясь в эффективный инструмент для повышения производительности и масштабируемости современных приложений.