Искусственный интеллект перестал быть простой технологией из области научной фантастики. Сегодня ИИ принимает миллионы решений в секунду, меняет привычные процессы бизнеса, медицины, финансов и государственной власти. В таких масштабах и с такой скоростью традиционные модели контроля и управления уже не справляются. Проблема заключается в том, что правительства, регуляторы и компании по-прежнему пытаются управлять ИИ на уровне, характерном для эпохи мейнфреймов 1980-х годов. В итоге возникает заметное рассогласование между скоростью деятельности ИИ и человеческим контролем, что сулит серьёзные риски, задержки и угрозы устойчивости систем.

В современном мире настало время для кардинального переосмысления принципов управления искусственным интеллектом — именно для этого и нужны системы, которые смогут самостоятельно регулировать собственную работу в рамках заранее заданных нормативов и этических рамок. Одним из главных вызовов становится то, что в различных юрисдикциях действуют свои правила, ограничения и стандарты, а ИИ должен быстро и чётко подстраиваться под эти требования. Классический пример — масштабные системы мониторинга и обработки сообщений по всему миру. В таких системах обработка миллионов уведомлений в секунду сопровождается необходимостью учитывать уникальные правила каждой страны, что превращает обычные юридические проверки в затяжные процедуры, тормозящие всю инфраструктуру. В результате технологии, которые в теории способны работать с феноменальной скоростью и точностью, фактически оказываются зажаты между колоссальными бюрократическими барьерами.

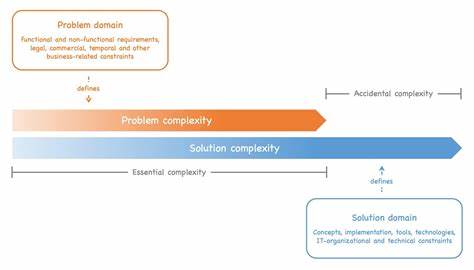

Этот разрыв между техническими возможностями искусственного интеллекта и традиционной парадигмой контроля и регулирования ведет к возникновению «узких мест», осложняющих динамику развития и создающих риск возникновения ошибок с широкомасштабными последствиями. Например, системы выявления мошенничества могут реагировать практически мгновенно на подозрительные действия, в то время как люди-эксперты, отвечающие за предотвращение и снижение рисков, рассматривают ситуации сутками. Аналогично, алгоритмы динамического ценообразования способны адаптироваться к изменениям рынка за миллисекунды, но регулирующие органы тянут с одобрением соответствующих изменений неделями. Такие задержки не просто замедляют бизнес-процессы — они ставят под угрозу безопасность и законность действий. Чтобы решить эту проблему, необходимо перейти к новому парадигматическому уровню управления, известному в профессиональной среде как «автономное управление» (autonomic governance).

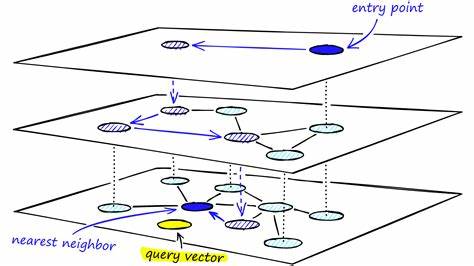

Концепция автономного управления предполагает, что функции наблюдения, контроля и адаптации интегрированы непосредственно в структуру ИИ, что позволяет системе самостоятельно следить за выполнением правил и регламентов без постоянного вмешательства человека. Эти системы способны самостоятельно интерпретировать и применять меняющиеся политики, оптимизировать защитные меры в зависимости от текущего уровня риска и даже проводить самовосстановление при выявлении нарушений, тем самым предотвращая распространение ошибок и потенциальный ущерб. В реальных проектах уже реализуются различные подходы к автономному управлению. Например, смарт-контракты с криптографической защитой обеспечивают автоматическую проверку соответствия алгоритмов требованиям конкретных юрисдикций еще до их развертывания. Алгоритмы реагируют на подозрительные транзакции немедленно: подозрительные операции изолируются, оцениваются с помощью адаптивных критериев и блокируются без необходимости ждать традиционных аудитов.

Автономные механизмы управления ликвидностью на криптовалютных биржах регулируют торговые спреды и приостанавливают торговлю отдельными парами в условиях рыночной волатильности и попыток манипуляции, опираясь на жесткий код, не допускающий отклонений. Эти примеры демонстрируют, что автономность в управлении не только реалистична, но и приносит ощутимые преимущества: повышается надежность работы, улучшается прослеживаемость решений, сокращаются временные и финансовые издержки. Однако такой подход не лишен сложностей и рисков. Одним из ключевых опасений является непрозрачность принятия решений автономными системами — «черный ящик», в котором оператор потерял возможность понять логику или причины конкретного выбора. Если алгоритмы будут учиться на ошибочных или предвзятых данных, тогда ошибки и несправедливость могут усугубиться, распространяясь гораздо быстрее, чем при традиционном контроле.

Кроме того, сбои в одной автономной системе способны вызвать цепные реакции, затрагивающие связанные сервисы и приводящие к катастрофическим последствиям. Решение этих проблем лежит через развитие инженерных практик и совершенствование дизайна систем. Ключевыми элементами становятся детальный лог каждой операции, прозрачные и понятные объяснения решений на доступном языке, а также встроенные механизмы аварийного отключения и возможности для немедленного вмешательства человека. Важно осознавать, что автономное управление не значит полный отказ от человеческого контроля. Говоря проще, правила и этические нормы должны четко прописываться людьми — юристами, этиками, специалистами по рискам — и встраиваться в код системы так, чтобы ИИ не мог их нарушить.

Для ситуаций со сложной юридической или этической природой, которые выходят за пределы рамок алгоритмической оценки, всегда должны сохраняться эффективно организованные процессы эскалации и человеческого решения. Для инженерных лидеров, занимающихся проектированием и сопровождением AI-инфраструктур, автономное управление становится критическим фактором с точки зрения латентности, надежности и скорости внедрения новых функций. Для успешной реализации концепции необходимо тщательно изучать текущие узкие места ручного контроля, рассматривать управление как программируемый элемент систем, создавать прозрачные и доступные интерфейсы для слежения за решениями, начинать с пилотных проектов для оценки эффективности автономных функций и обеспечивать мультидисциплинарное взаимодействие экспертов из разных сфер знаний. В масштабах современного общества, где искусственный интеллект играет всё более значимую роль, автоматизация процесса управления и контроля не просто улучшит скорость и качество принятия решений, но и усилит безопасность цифровой инфраструктуры. Успешные организации, которые сумеют интегрировать автономные механизмы регуляции, не только опередят конкурентов, но и заложат фундамент доверия и устойчивости, крайне необходимые в эпоху бурного технологического прогресса.

Итак, современные реалии требуют перехода от традиционного внешнего контроля за ИИ к встроенным системам, способным самостоятельно действовать в рамках предписанных норм. Это не означает отказ от человеческого фактора, а наоборот, предполагает его усиление за счет эффективных инженерных решений и прозрачности. Только так возможно обеспечить согласованность, безопасность и соответствие новых технологий общественным ожиданиям и правовым требованиям. В результате такой подход станет фундаментом для создания ответственного искусственного интеллекта, способного работать на благо общества, одновременно минимизируя риски и повышая эффективность управления в быстро меняющемся мире.