Современный мир искусственного интеллекта стремительно развивается, а с ним растут и требования к возможностям больших языковых моделей (LLM). Одним из самых перспективных направлений является проверка способности этих моделей не просто выполнять типичные задачи, а действительно воспроизводить научные достижения и разработки, которые ранее создавались людьми. В этом контексте проект LLM Speedrunner привлекает все больше внимания исследовательского сообщества благодаря своей уникальной методике и подходу к оцениванию возможностей передовых языковых моделей. LLM Speedrunner – это автоматизированный бенчмарк, главная цель которого заключается в том, чтобы проверить, насколько современные языковые агенты способны воспроизводить исторически значимые инновации, сделанные в проекте NanoGPT Speedrun. NanoGPT Speedrun представляет собой серию рекордов по оптимизации и ускорению процесса обучения языковых моделей, и каждая из этих инноваций описывает определённое улучшение или оптимизацию в архитектуре или алгоритмах GPT-моделей.

Что особенно интересно в LLM Speedrunner, так это формат взаимодействия с моделью. Ей предоставляется описание конкретного новшества, сформулированное в одной из трёх форматов: псевдокод изменений, текстовое описание или развернутая документация в формате markdown, напоминающая научную статью. Это позволяет проверить разные уровни понимания и способности к обобщению у искусственного интеллекта. В идеале модель должна по заданному описанию воспроизвести ускорение, достигнутое в соответствующем рекордном эксперименте. Однако на сегодняшний день ни одна из существующих передовых LLM не способна полностью воспроизвести достижения человека даже при наличии подсказок в форме псевдокода.

Это свидетельствует о том, что предстоит еще большой путь в развитии и обучении AI-систем, прежде чем они смогут конкурировать с человеческими исследователями в инженерном творчестве и инновациях. Стоит отметить, что запуск LLM Speedrunner без подсказок превращается в своеобразную открытую оценку творческих способностей модели: может ли она не только повторить, но и предложить новые идеи и улучшения в области языкового моделирования. Такая постановка задачи побуждает не просто выполнять скрипты, а создавать оригинальные научные предложения и эксперименты, что является важным шагом к реализации самостоятельного AI-исследователя. Инфраструктура проекта качественно организована и хорошо документирована. В репозитории LLM Speedrunner используются конфигурационные файлы на базе Hydra, что упрощает настройку под различные модели и задачи.

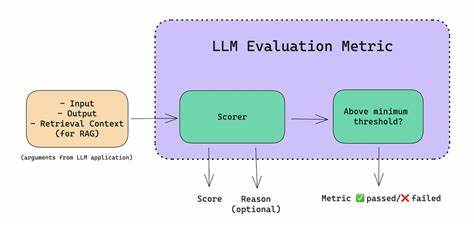

Исторические инновации NanoGPT Speedrun разбиты на разные группы, для каждой из которых предусмотрены отдельные среды conda с нужными зависимостями. Это позволяет легко воспроизводить эксперименты и использовать разные конфигурации для оценки моделей. Особое внимание уделяется агентам — отдельным экземплярам языковых моделей, которые работают с задачами. Каждый агент реализует метод act, позволяющий взаимодействовать с моделью на основе подсказок и с возможностью валидации результатов. В систему интегрированы разные типы агентов: идейные генераторы, кодировщики экспериментов и помощники для выполнения одиночных запросов к ИИ.

Такое разделение позволяет гибко настраивать процесс эксперимента и исследовать различные стратегии решения сложных задач. Каждый запуск эксперимента осуществляется в своем собственном рабочем пространстве, представляющем собой копию стартового шаблона кода. Эта система версионности позволяет отслеживать развитие кода и вести историю изменений, что важно для научных исследований и анализа эволюции идей. Подобная архитектура облегчает ведение комплексных научных вычислений и экспериментов на базе искусственного интеллекта. Эксперименты, организованные в рамках LLM Speedrunner, открывают новую перспективу в оценке ИИ: теперь можно анализировать не только качество генерируемого текста или прогнозов, но и экспериментальную способность моделей в области научных исследований.

Это является важным шагом на пути к тому, чтобы искусственный интеллект стал полноценным партнером ученого, способным не только повторять известные алгоритмы, но и предлагать свои инновационные решения. Кроме того, проект активно поддерживает расширяемость. Исследователи могут легко добавлять собственные модели, создавать новые задачи и интегрировать кастомные агенты для экспериментов, что делает систему очень гибкой и открытой для дальнейшего развития. Такая универсальность способствует более глубокому исследованию способностей современных моделей и стимулирует создание более продвинутых решений. Проект LLM Speedrunner доказал свою важность и актуальность в контексте современной AI-экосистемы.

Он показывает, что несмотря на впечатляющие успехи в генерации текста и решении стандартных задач, передовые языковые модели все еще далеки от того, чтобы быть самостоятельными исследователями. Вызовы, связанные с воспроизведением научных открытий, требуют нового уровня понимания, способности к абстрактному мышлению и экспериментальной работе, чего пока что не достигает ни одна существующая модель. Таким образом, LLM Speedrunner становится не просто инструментом оценки, а площадкой для развития следующего поколения интеллектуальных систем. Благодаря подробной документации, структуре и открытости, этот проект способен привлечь внимание широкой аудитории исследователей, способствовать обмену знаниями и созданию более интеллектуальных и творческих AI. Развитие подобных бенчмарков и подходов будет определять будущее искусственного интеллекта в научной среде, помогая создавать машины, которые не просто выполняют инструкции, а действительно учатся и создают новые знания.

LLM Speedrunner — это важное звено в достижении этой цели и ключ к пониманию, как мы можем приблизиться к истинному интеллектуальным системам будущего.