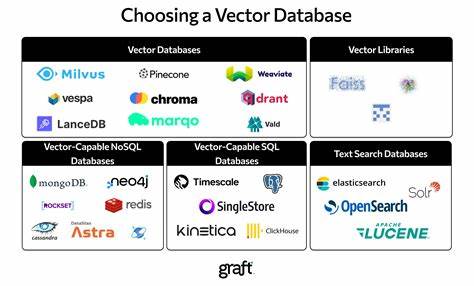

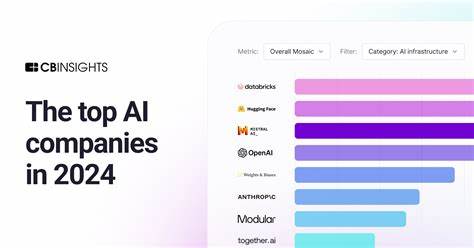

В современном мире искусственного интеллекта и машинного обучения векторные базы данных играют ключевую роль в создании эффективных и масштабируемых AI-продуктов. Векторные базы данных обеспечивают высокопроизводительный поиск по огромным объемам данных, что особенно важно при реализации таких технологий, как Retrieval-Augmented Generation (RAG). Технология RAG позволяет AI-наборам находить точные и релевантные ответы в приватных данных, будь то клиентские записи, внутренние документы или метрики компании. В 2025 году рынок векторных баз данных насыщен разнообразными решениями. Среди самых популярных и перспективных: Turbopuffer, Pinecone, Qdrant, pgvector, Cloudflare Vectorize, Weaviate, Milvus/Zilliz, Turso Vector, MongoDB Atlas Vector Search, Chroma и Redis.

Каждый из этих вариантов имеет свои уникальные характеристики, функциональные возможности, ограничения, а также разные ценовые политики, что требует взвешенного подхода к выбору. Авторы, создавая AI Copilots - продукт для общения с AI с поддержкой многопользовательской изоляции и реального времени, столкнулись с выбором векторной базы данных. Им требовался инструмент, который позволял бы эффективно управлять большими массивами данных, обеспечивая при этом высокую скорость отклика и финансовую доступность. После длительных тестов был выбран гибридный подход - сочетание BM25 (поиска по ключевым словам и семантического поиска) и векторного поиска с возможностью последующего ранжирования. Производительность и масштабируемость считаются ключевыми факторами.

Векторные базы данных существенно различаются по этим параметрам. Важно помнить, что просто опираться на данные бенчмарков недостаточно - необходимо рассматривать также поддерживаемые индексационные стратегии, возможности организации пространств имен (namespaces), поддержку мультиарендности и гибридные методы поиска. Кроме того, необходимо учитывать вопросы безопасности, соответствия нормативным требованиям (таким как HIPAA, SOC2), а также затраты - все это влияет на выбор оптимального решения. Среди всех рассмотренных платформ Turbopuffer выделяется благодаря своей высокой производительности, низкой стоимости, поддержке масштабируемой мультиарендности без жестких лимитов и наличию предприятия-ориентированных функций без значительного увеличения цены. Turbopuffer поддерживает как векторные, так и BM25 индексы, что особенно полезно в гибридных случаях использования.

Инструмент полностью серверлес, и пользователи платят исключительно за ресурсы, которые действительно потребляют - данные, записи и запросы. Благодаря функции предварительного прогрева пространств имен обеспечивается мгновенный отклик AI Copilots. Мультиарендность построена на простом и эффективном механизме применения отдельного namespace для каждого клиента или проекта, что положительно влияет на производительность при масштабировании. SDK доступны на TypeScript, Python и Go, а за счет быстрого реагирования поддержки решения проблем можно получить оперативно. Среди минусов - отсутствие открытого исходного кода, начальная задержка при запуске сервера (обходится с помощью прогрева), минимальный месячный платеж и необходимость использовать собственные embedding-модели.

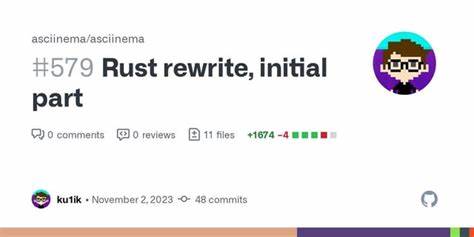

Pinecone пользуется заслуженной популярностью благодаря своей зрелой инфраструктуре и надежности, поддержкой крупных облачных платформ (AWS, GCP, Azure) и масштабируемости до миллиардов векторов. Особенностью Pinecone является встроенная генерация embedding с оплатой дополнительно. Однако у него существуют ограничения по количеству индексов и пространств имен, а сложная структура ценообразования может отпугнуть новичков. Также гибридный поиск вне Python-экосистемы реализован не слишком удобно. Qdrant - это высокопроизводительная, открытая база данных, написанная на Rust, с гибкими возможностями фильтрации, кластеризации и гибридного ранжирования.

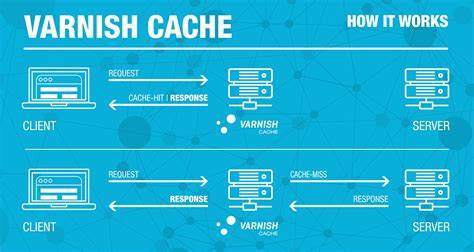

Пользователи могут выбрать между самостоятельным размещением через Docker и Kubernetes или использованием облачного сервиса. Ценообразование в облаке зависит от использования ресурсов, включая опции снижения затрат с помощью квантования и кэширования. Высокая гибкость в настройки мультиарендности и поддержка множества SDK делают Qdrant предпочтительным вариантом для тех, кто ценит кастомизацию. Однако проработка и администрирование требуют некоторого времени и опыта. Расширение pgvector для Postgres позволяет интегрировать возможности векторного поиска непосредственно в реляционные базы данных.

Такой подход особенно удобен для команд, уже работающих с Postgres и желающих объединить структурированные данные с векторным поиском. Преимущество pgvector в открытости, бесплатности и расширенной экосистеме, но одновременно это решение требует настройки и оптимизации инфраструктуры Postgres, а также управления компромиссами между производительностью и оперативной памятью. Cloudflare Vectorize ориентирован на edge-решения и тесно интегрирован с платформой Cloudflare Workers AI. Он отличен для простых сценариев и небольших проектов, при условии подключения к их экосистеме. Тем не менее, ограничения по количеству векторов на индекс и недостаточная поддержка метаданных затрудняют создание гибридных поисковых систем.

Weaviate - один из пионеров в области векторных баз данных с богатым функционалом, включая мультимодальные данные и интеграции с внешними встроенными моделями. Предлагает разнообразные способы взаимодействия с API и гибкие технологии поиска, что делает его удобным для комплексных и разнообразных сценариев. Минус - относительно высокая стоимость и кривизна освоения некоторых интерфейсов. Milvus и его коммерческий аналог Zilliz рассчитаны на масштабируемые распределенные решения и обладают преимущественно набором индексационных стратегий для корпоративных проектов. Цена зависит от инфраструктурных затрат, а развертывание и сопровождение требуют серьезной технической подготовки.

Для проектов небольшого и среднего размера такой вариант будет избыточным. SQLite-vec и Turso Vector обеспечивают уникальный подход, ориентированный на встраиваемые и горизонтально масштабируемые решения, делая упор на низкую стоимость и близость к пользователю. Turso выступает как облачный провайдер, упрощающий использование SQLite с векторным расширением, что отлично подходит для сценариев с индивидуальными базами данных для каждого клиента или пользователя. Тем не менее масштабировать единый большой векторный индекс здесь сложно. MongoDB Atlas Vector Search выгодно использовать, если у вас уже развёрнута MongoDB.

Решение интегрирует векторный поиск в привычную среду и поддерживает гибридный поиск, но цены зависят от общего размера инстанса и сложно поддаются прогнозированию. Chroma - новая серверлес база данных с открытым исходным кодом, позиционируемая как решение для AI retrieval. Она сочетает в себя функции полнотекстового, метаданных и векторного поисков, работает с коллекциями и многопотенциальной организацией данных. Несмотря на некоторые недостатки документации и стоимости в облаке, Chroma принимает различные SDK и HTTP API. Redis с версией 8.

0 представила нативный векторный тип, значительно улучшив скорость поиска за счёт работы в памяти. Если вы уже знакомы с Redis и располагаете подходящим оборудованием, это может быть очень достойным вариантом. Однако высокая потребность в ОЗУ и специализация Redis на работе с in-memory данными может ограничить масштабируемость. В итоге выбор векторной базы для AI-продукта зависит от множества факторов. Turbopuffer является оптимальным вариантом для тех, кто стремится получить высокую производительность и масштабируемость при низких затратах и удобной поддержке.

Pinecone и Qdrant - серьезные игроки в сегменте управляемых и открытых решений с глубокой интеграцией и гибкими возможностями. pgvector и MongoDB Atlas отлично подходят для команд, уже работающих с классическими базами данных и ценящих конвергенцию с векторным поиском. Weaviate и Milvus/Zilliz нацелены на корпоративные и масштабируемые задачи с требованием к обширному функционалу и сложной архитектуре. SQLite-vec/Turso и Cloudflare Vectorize - для нишевых сценариев с высокой горизонтальной масштабируемостью и edge computing. Redis - для ultra-low latency приложений с мощным аппаратным обеспечением.

Понимание этих особенностей позволит разработчикам и инженерам принять взвешенное решение при создании эффективных AI-продуктов в 2025 году, реализуя максимально быстрый, точный и экономичный поиск по данным с использованием современных технологий и методов. .