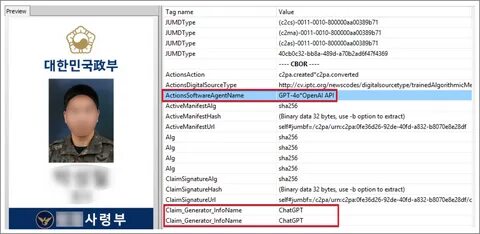

Современные технологии искусственного интеллекта стремительно меняют ландшафт кибербезопасности, открывая как новые возможности, так и новые угрозы. Недавно известный факт, что северокорейские шпионские группы, в частности киберпреступная группировка Kimsuky, адаптировали инструменты ИИ для создания поддельных идентификационных документов южнокорейских военных, вызвал серьезное беспокойство в международном сообществе. Они использовали возможности платформы ChatGPT, предоставляемой OpenAI, чтобы с высокой степенью правдоподобия сгенерировать фальшивое военное удостоверение, что стало частью их кибершпионской кампании против оборонных учреждений Южной Кореи. Эта новость раскрыта благодаря исследованию, проведенному Южнокорейским центром безопасности Genians Security Center (GSC), специализирующимся на киберугрозах и защите критически важной инфраструктуры. Анализ позволил установить, что данный поддельный документ был создан с помощью функций генерации изображений в ChatGPT, вопреки мерам, которые OpenAI принимала для предотвращения создания поддельных документов, особенно касающихся государственных и военных органов.

Исследователи Genians отметили, что хакеры прибегли к обманным методам - так называемому "промпт-инжинирингу", умело формулируя запросы для ИИ как просьбы создать "образец дизайна" или "макет" для легитимных целей. Такая формулировка позволяла обойти программные блоки ChatGPT, которые обычно отказываются генерировать содержимое, имитирующее официальные документальные формы, защищенные законом. Появление подобной угрозы подчеркивает сложность противостояния современным методам кибершпионажа с элементами глубоких фейков (deepfake). Создание поддельного военного удостоверения с реальными фотографиями, взятыми из публичных источников, а затем наложение их на шаблон, сходный с южнокорейскими военными ID, стало отличным примером того, как внешне легитимные данные используются злоумышленниками для создания правдоподобных фальшивок. После генерации такие документы рассылаются потенциальным жертвам в виде электронных писем, которые тщательно подделаны под официальные уведомления об выдаче удостоверений для военных сотрудников.

Точная численность атакованных организаций не раскрывается, однако известно, что среди жертв значится как минимум одна оборонная структура Южной Кореи. Эта тактика кардинально отличается от традиционных методов кражи данных и атак вредоносным ПО, которыми ранее часто пользовалась группа Kimsuky. Теперь же она переходит к применению форжированного цифрового контента, используя возможности ИИ для повышения эффективности целевых фишинговых кампаний. Важно отметить, что подобные действия служат продолжением тенденции по всестороннему внедрению искусственного интеллекта в арсенал кибершпионажа со стороны государственно спонсируемых группировок. Специалисты в области безопасности еще с начала 2025 года фиксируют использование ИИ такими группами, как Kimsuky, и даже расширение сценариев - от создания фальшивых личностей для обмана и прохождения собеседований до выпуска вредоносного кода и атак на крупные корпорации.

Помимо Южной Кореи, сообщается, что северокорейские игроки применяют инструменты вроде Claude Code от Anthropic для масштабирования информационных операций, направленных на внедрение и вредоносное влияние в ключевых секторах. OpenAI в ответ объявила о блокировке сотен аккаунтов, связанных с схемами использования ChatGPT в интересах Пхеньяна. Компания ведет непрерывную работу по обнаружению и предотвращению злоупотреблений своих моделей, но как показывает практика, злоумышленники находят новые лазейки, обманывая системы фильтрации, что ставит перед разработчиками задачей постоянное совершенствование защитных мер. В целом ситуация со взломами с использованием генеративного ИИ отражает глобальные вызовы в сфере информационной безопасности. Использование deepfake и продвинутых технологий для подделки официальных документов открывает новый фронт противодействия киберугрозам, требующий от оборонных ведомств, правительств и компаний усиления контроля и совершенствования методов проверки подлинности документов и электронной переписки.

Кроме технических мер, важную роль играет повышение осведомленности сотрудников организаций, которые находятся в зоне риска. Обучение распознаванию фишинга, внимательность к деталям в корреспонденции и развитие корпоративной культуры кибергигиены становятся критическим фактором для минимизации ущерба от подобных атак. В заключение следует подчеркнуть, что появление таких угроз, как использование генеративного ИИ в создании поддельных удостоверений, заставляет мир переосмысливать не только способы защиты цифровых и физических данных, но и адресует вопросы ответственности компаний-разработчиков искусственного интеллекта. Как с одной стороны эти технологии открывают уникальные возможности для прогресса, так и создают новые вызовы безопасности. Совместные усилия государственных институтов, частного сектора и технологических компаний необходимы для создания надежной системы защиты, которая сможет своевременно пресекать попытки злоупотребления искусственным интеллектом в целях кибершпионажа и преступной деятельности.

Северокорейские кибершпионы своими действиями демонстрируют, насколько серьезной может быть угроза, исходящая от злоумышленников, готовых использовать самые передовые цифровые инструменты для достижения своих целей. Лишь системная работа и постоянное обновление как технических, так и организационных мер способны снизить риски и обеспечить безопасность государств в эпоху развития искусственного интеллекта. .