В последние годы технологии искусственного интеллекта стремительно развиваются, проникая во все сферы жизни и деятельности человека. Активное внедрение ИИ в бизнес, медицину, промышленность и даже повседневные устройства требует особого внимания к вопросам проверок и оценки систем на базе искусственного интеллекта. Тестирование и оценка ИИ становятся неотъемлемой частью процесса разработки, позволяющей не только диагностировать ошибки и недочёты, но и обеспечивать безопасность, прозрачность и эффективность решений, основанных на машинном обучении и других алгоритмах. Одной из ключевых проблем тестирования ИИ является его сложность и многообразие форматов. Традиционные методы тестирования ПО зачастую не подходят для систем, которые обучаются на данных, сами изменяются в ходе эксплуатации и принимают решения на основе вероятностных моделей.

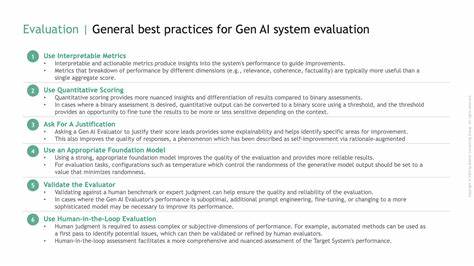

Это требует создания новых подходов, которые учитывают адаптивность и непредсказуемость поведения ИИ. В частности, большое внимание уделяется разработке метрик, позволяющих объективно оценить качество моделей и способность ИИ корректно функционировать в реальных условиях. Особое значение имеет проверка данных, на которых обучаются алгоритмы. Качество и репрезентативность обучающих выборок напрямую влияют на итоговые результаты. Ошибки в данных или их смещённость способны привести к неправильным выводам, дискриминации или другим нежелательным последствиям.

Поэтому тестирование ИИ нередко начинается ещё до его запуска в промышленную эксплуатацию с тщательного анализа и валидации исходной информации. Один из трендов развития отрасли – стремление к созданию прозрачных и объяснимых моделей ИИ. Проблема так называемого «чёрного ящика» в искусственном интеллекте вызывает серьёзные опасения, поскольку без понимания механизма принятия решений сложно оценить надёжность и безопасность системы. В этом направлении тестирование и оценка выполняют важную роль, позволяя не только выявить ошибки, но и улучшить интерпретируемость моделей. Безопасность систем ИИ является ещё одним критическим аспектом тестирования.

С развитием технологий увеличивается вероятность возникновения уязвимостей, которые могут быть использованы вредоносными программами или злоумышленниками. Это требует комплексного подхода, включающего стресс-тесты, проверку на устойчивость к атакам и моделирование различных сценариев использования. Таким образом, оценка ИИ становится гарантией защиты данных пользователей и предотвращения потенциальных сбоев. Важным моментом является также этическая составляющая процесса тестирования. Исследователи и разработчики всё чаще сталкиваются с необходимостью учитывать влияние ИИ на общество, предотвращать возможные злоупотребления и гарантировать соблюдение прав человека.

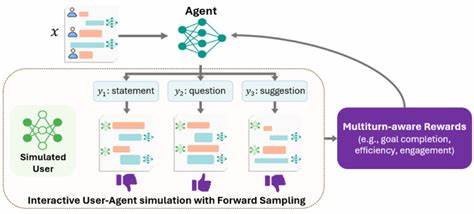

Поэтому оценка систем сегодня включает анализ не только технических параметров, но и социального воздействия технологии. Ключевыми вызовами в сфере тестирования и оценки искусственного интеллекта являются динамичность алгоритмов и постоянное обновление моделей. В отличие от статичных программ, ИИ-системы могут меняться во времени, учась на новых данных и адаптируясь под условия эксплуатации. Это требует непрерывной проверки и мониторинга, что существенно усложняет организацию процесса контроля качества. Одним из перспективных направлений является автоматизация тестирования ИИ.

Использование специальных инструментов и платформ позволяет систематизировать процессы оценки и ускорить получение результатов. В частности, появились методы, основанные на генеративных моделях, которые способны создавать тестовые сценарии и выявлять уязвимости без участия человека, что особенно актуально при масштабных проектах. Кроме того, важным элементом становится нормативно-правовое регулирование. Международные организации, правительства и индустриальные ассоциации активно работают над созданием стандартов, гарантирующих безопасность и этичность систем ИИ. Соответствие этим требованиям становится обязательным этапом для выхода на глобальный рынок и доступа к новым возможностям.

В итоге, тестирование и оценка искусственного интеллекта представляют собой сложный, комплексный и постоянно развивающийся процесс, отражающий не только технические, но и социальные, этические и юридические аспекты. Понимание значимости и особенностей этой сферы помогает создавать более надёжные, безопасные и эффективные технологии, способные приносить пользу обществу и бизнесу. Перспективы развития заключаются в интеграции современных методов контроля качества с искусственным интеллектом, что позволит создавать саморегулирующиеся системы, минимизирующие ошибки и улучшая пользовательский опыт. Также важна коллаборация специалистов из разных областей – от разработчиков и инженеров до юристов и этиков, что обеспечивает комплексный подход к формированию доверия и устойчивого развития технологии.