Развитие искусственного интеллекта (ИИ) стремительно меняет нашу жизнь, помогая решать сложнейшие задачи в различных сферах — от медицины и финансов до промышленности и транспорта. Однако с увеличением внедрения ИИ-технологий возникает необходимость обеспечения их безопасности и надёжности. Именно поэтому тестирование и оценка ИИ становятся критически важными этапами в процессе разработки и внедрения подобных систем. В этой связи опыт кибербезопасности приобретает особое значение, так как позволяет выявлять уязвимости и риски, что минимизирует потенциальные угрозы и защищает пользователей от негативных последствий.Кибербезопасность на протяжении десятилетий развивалась как комплексная дисциплина, направленная на предотвращение, обнаружение и реагирование на разнообразные угрозы.

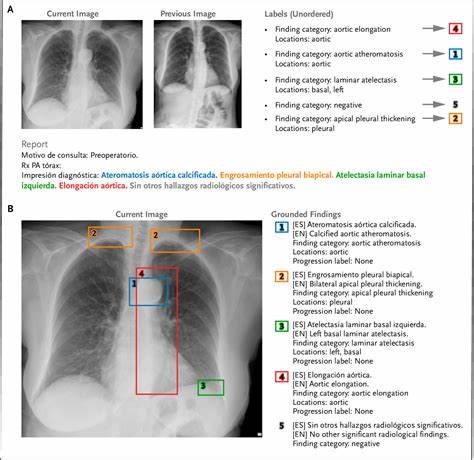

Одним из ключевых принципов в этой области является постоянное тестирование систем на уязвимости с помощью различных методов и инструментов, которые позволяют выявлять слабые места до того, как ими воспользуются злоумышленники. Внедрение аналогичных подходов в тестирование ИИ-систем может значительно повысить их устойчивость.Тестирование ИИ имеет свою специфику, связанную с особенностями этих систем. Искусственный интеллект часто базируется на сложных моделях машинного обучения, которые сами по себе могут вести себя непредсказуемо и изменчиво. В отличие от традиционного программного обеспечения, ИИ нуждается в оценке не только технических характеристик, но и качества данных, на которых он обучается, а также способности корректно обрабатывать непредвиденные ситуации.

Поэтому методы тестирования ИИ должны учитывать множество факторов, включая корректность алгоритмов, адекватность обучающих выборок, справедливость принятия решений и защиту от манипуляций.Одним из важнейших уроков, который можно извлечь из кибербезопасности, является понимание того, что безопасность — это постоянный процесс, а не единичное событие. Аналогично в тестировании ИИ овощатием моделью должно быть регулярное проведение проверок на уязвимости, анализ поведения и обновление механизмов защиты в ответ на появление новых угроз и ошибок. Такой подход существенно снижает риски возникновения инцидентов и повышает доверие пользователей к ИИ-системам.Другим важным аспектом, позаимствованным из практик кибербезопасности, является необходимость проведения стресс-тестирования и внедрение методов красного и синего командных игр.

Красная команда имитирует атаки на систему, пытаясь обнаружить ее слабые места, в то время как синяя команда пытается отражать эти атаки. Аналогичные методы в ИИ позволяют моделировать различные сценарии, включая преднамеренные попытки введения ошибок или манипуляций с данными, что повышает надежность модели и её устойчивость к враждебному воздействию.Немаловажно уделять внимание прозрачности и объяснимости результатов работы ИИ. В кибербезопасности аналитики постоянно исследуют логи и записи событий, чтобы понять природу атак и предсказать новые методы злоумышленников. В случае ИИ прозрачность моделей и возможность объяснять причины тех или иных решений дают возможность своевременно выявлять аномалии и предотвращать ошибочные или предвзятые выводы.

Тестировщики должны использовать методы, позволяющие мониторить и интерпретировать работу алгоритмов, что повышает контроль над процессом и снижает риски.Важным уроком становится и интеграция мультидисциплинарных подходов. Кибербезопасность объединяет знания из информационных технологий, психологии, права и менеджмента, что позволяет более полно оценивать риски и строить эффективные стратегии защиты. Подобный подход целесообразен и в тестировании ИИ, где привлечение экспертов из разных областей помогает выявлять скрытые угрозы, связанные с этическими и социальными аспектами использования технологий, особенно в чувствительных областях, таких как медицина или финансы.Особое место занимает соответствие нормативным требованиям и стандартам безопасности.

В сфере кибербезопасности существует множество регуляций и лучших практик, которые компании обязаны соблюдать, чтобы защитить данные и обеспечить стабильную работу сервисов. Для ИИ также формируются стандарты и рекомендации, направленные на обеспечение качества и безопасности алгоритмов. Тестирование систем на соответствие этим стандартам становится важной гарантией надёжности и помогает компаниям строить долгосрочные отношения с клиентами и партнёрами.Тенденции развития ИИ указывают на возрастающую роль автоматизации тестирования и внедрение технологий непрерывного мониторинга. В кибербезопасности широко применяются системы обнаружения и предотвращения вторжений, основанные на автоматизированных алгоритмах, способных в режиме реального времени выявлять и реагировать на угрозы.

Аналогичные системы для ИИ позволяют оперативно оценивать качество моделей, отслеживать их поведение в реальном времени и своевременно предупреждать о потенциальных ошибках или уязвимостях. Такая автоматизация тестирования снижает человеческий фактор и повышает эффективность процессов контроля.Однако важно помнить, что совершенствование методов тестирования ИИ — это непрерывный процесс. Новые технологии порождают новые вызовы, включая угрозы от атак на данные для обучения, фишинговые методы манипуляции моделями и даже этические дилеммы. Внедрение практик кибербезопасности формирует у разработчиков устойчивое мышление в части проактивного реагирования на такие вызовы и постоянного улучшения систем защиты.

Обобщая, интеграция уроков из кибербезопасности в тестирование и оценку искусственного интеллекта ведёт к созданию наиболее защищённых, надёжных и прозрачных ИИ-систем. Такой подход способствует более эффективной реализации потенциала технологий, минимизации рисков и формированию высокого доверия пользователей и общества к искусственному интеллекту. Это, в свою очередь, позволяет ускорить цифровую трансформацию и расширить применение инновационных решений в различных сферах человеческой деятельности, делая их безопасными и устойчивыми в долгосрочной перспективе.