В последние годы развитие технологий глубокого обучения совершило качественный скачок благодаря появлению новых архитектур, способных эффективнее обрабатывать сложные данные. Одним из таких прорывных направлений стали H-Nets, или иерархические нейросети, которые стремятся преодолеть существующие ограничения традиционных моделей и вывести работу с последовательностями на новый уровень. История создания H-Nets уходит корнями в поиск решения фундаментальных проблем в обработке языковых, аудио- и визуальных данных, а их потенциал уже сейчас вызывает большой интерес исследовательского сообщества и индустрии. Изначально идея иерархии в моделях искусственного интеллекта не была нова, но ее систематическое использование в ходе разработки H-Nets стало уникальным подходом. Иерархические модели позволяют структурировать входные данные в виде многоуровневых представлений, что максимально приближает работу алгоритмов к способу, которым человек воспринимает информацию.

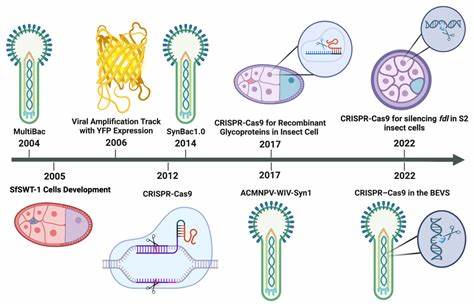

В основе философии H-Nets лежит концепция «чункования» — группировки данных в осмысленные блоки с помощью дифференцируемых механизмов, что облегчает управление долгосрочными зависимостями и снижает вычислительную сложность. Важной вехой на пути к созданию H-Nets стал опыт работы с рекуррентными сетями (RNN), в частности с их иерархическими модификациями. Применяя идеи из таких моделей как Clockwork RNN и Hierarchical Multiscale RNN, разработчики стремились улучшить способность сети работать с длительными временными зависимостями, что всегда являлось серьезной проблемой. В середине 2010-х годов появление моделей типа Ordered Neuron LSTM внесло вклад в понимание того, как встроить иерархические структуры непосредственно в управляющие механизмы RNN, что помогло заложить теоретическую базу для дальнейших исследований. Следующий этап развития связан с прогрессом в области моделей основанных на состоянии, или State Space Models (SSMs), которые показали отличные результаты в обработке долгих последовательностей и появились как альтернатива популярным трансформерам, особенно в задачах с необработанными, высокочастотными данными, такими как аудио.

Примером тому служит модель S4, которая достигла широкого признания благодаря своей эффективности и универсальности. Построение на ее основе иерархических структур, включая так называемые U-Net архитектуры, позволило получить первые успешные эксперименты по моделированию данных с неоднородной структурой. Одной из главных проблем оставалась невозможность эффективно применять классические U-Net архитектуры для языковых данных из-за переменной длины и непредсказуемого распределения информации. Многие исследователи отмечали, что фиксированное и равномерное разбиение входной последовательности на блоки, характерное для сверточных подходов, не отражает реальной лингвистической структуры и зачастую снижает качество моделей. Неудачи в этом направлении лишь подтвердили необходимость разработки более гибких дифференцируемых механизмов динамического формирования чанков — тех самых смысловых единиц.

Таким образом, внимание переключилось на идею создания дифференцируемого чанкера — модуля, способного автоматически и в режиме обучения определять границы осмысленных фрагментов данных. Это близко к задаче токенизации, но выходит далеко за ее рамки, предлагая универсальный инструмент для формирования многоуровневых абстракций, которые могут применяться не только к тексту, но и к другим типам последовательностей. Важным открытием стала возможность использовать техники из области mixture-of-experts (MoE), где каждый элемент данных выбирает «эксперта» для обработки, реализуя своего рода дискретный выбор внутри модели, который можно адаптировать под цель динамической сегментации. Правда, задача избежать проблем с обучением таких сложных систем до сих пор остается вызовом. Ранние попытки, включая использование Gumbel-softmax и других стохастических методов, дали лишь частичные результаты — либо отсутствовала стабильность, либо требовался значительный ручной тюнинг.

Лишь применяя современные методы нормализации, балансировку и сложные архитектурные решения, удалось добиться приемлемых показателей качества, что воплотилось в финальной архитектуре H-Nets с ее многоуровневыми суб-сетями и специфическими механизмами сглаживания и маршрутизации. Современные исследования также показали, что H-Nets имеют преимущество перед традиционными трансформерами и чистыми SSM в задачах работы с необработанными байтовыми данными и текстами без предварительной токенизации. Использование Mamba слоев, комбинирующих свойства SSM и трансформеров, обеспечивает эффективное сжатие информации на начальных этапах обработки, что положительно сказывается на итоговом представлении и производительности. В экспериментах на BPE-токенизированных текстах архитектура H-Nets показала превосходство, что свидетельствует о ее универсальности и потенциальном широком применении. Что касается практических применений, H-Nets уже демонстрируют впечатляющие результаты в моделировании аудиосигналов, генерации текстов и визуальных данных.

Применение иерархической архитектуры при обработке аудио позволяет учитывать принципы восприятия человеком, где звук воспринимается в виде последовательностей иерархических событий. Для текстовых же данных открывается путь к преодолению ограничений существующих токенайзеров, что может привести к радикальному улучшению понимания и генерации языковых конструкций. Взгляд в будущее H-Nets полон оптимизма, хотя и содержит множество открытых вопросов. Среди них — изучение масштабируемости модели при огромных объемах данных, оптимизация процесса обучения при сложных и шумных источниках, а также дальнейшее усовершенствование механизма динамической сегментации с целью более осмысленного захвата семантических связей. Разрабатываются и более сложные варианты многократной рекурсивной_chunk_инг, способные строить глубокие уровни абстракций, а значит и более мощные модели интеллекта.

![When "What Will It Take?" Seems Beyond Possible by Alan Kay [pdf]](/images/F4202C79-08F7-4B13-AF06-044C074D60B0)