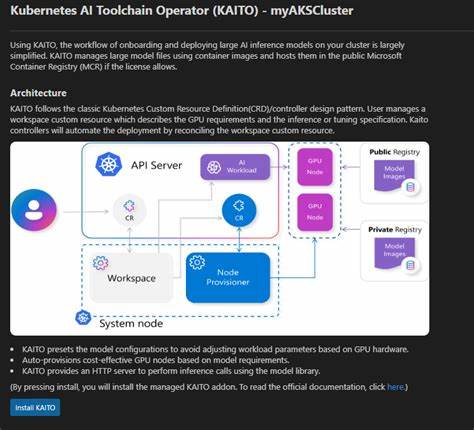

В мире современных технологий искусственный интеллект продолжает занимать лидирующие позиции среди инновационных направлений, влияющих на бизнес и повседневную жизнь. Одной из ключевых задач становится эффективное развертывание и управление масштабированными моделями ИИ, особенно когда речь идёт об интеграции их с облачными и контейнеризированными средами. Проект Kaito, представляющий собой Kubernetes AI toolchain operator, становится эффективным решением, позволяющим упростить и автоматизировать сложные процедуры работы с крупными AI-моделями в Kubernetes. Kaito разработан как специализированный оператор, который встроен в экосистему Kubernetes посредством Custom Resource Definitions и контроллеров. Его основная задача — автоматизировать создание, масштабирование и выверку рабочих нагрузок, связанных с глубоким обучением, исследовательскими моделями и инференсом в облачных кластерах.

В отличие от традиционных методов развертывания, которые опираются на виртуальные машины и требуют значительных усилий по конфигурации и поддержке, Kaito предлагает уникальное сочетание контейнеризации моделей и интеллектуального управления ресурсами. Одним из ключевых преимуществ Kaito является гармоничное взаимодействие с популярными открытыми крупномасштабными моделями, такими как phi-4 и llama. Проект способствует более широкому внедрению этих моделей, обеспечивая поддержку различных инференс-рутинных сред, включая vLLM и transformers, что делает Kaito универсальным инструментом для специалистов по машинному обучению. Техническая архитектура Kaito базируется на продвинутой модели, где основной компонент — workspace controller — управляет жизненным циклом рабочих пространств для AI. Он следит за состоянием и параметрами модели, автоматически создаёт NodeClaim, инициирующий выделение GPU-ресурсов в кластере, и организует деплоймент или запуск инференс-задач в соответствии с предустановленными конфигурациями.

Более того, векторная интеграция с gpu-provisioner позволяет динамично масштабировать вычислительные ресурсы, используя API облачных провайдеров, таких как Azure. Стоит также отметить нововведение, появившееся с релизом версии 0.5.0 — RAGEngine, который расширяет функциональность Kaito за счет организации Retrieval Augmented Generation сервисов. Данный компонент интегрирует возможности таких инструментов, как LlamaIndex и FAISS, предоставляя внутри системы высокопроизводительные векторные базы данных и возможности для оркестрации запросов с поддержкой локальных и удалённых эмбеддингов.

В контексте автоматизации и оптимизации управления ресурсами Kaito внедряет изящные предустановленные конфигурации, которые позволяют соотносить параметры рабочих нагрузок с характеристиками GPU без необходимости ручной настройки. Это значительно снижает порог вхождения в использование мощных моделей AI для команд DevOps и Data Science, ускоряя процесс внедрения и обеспечивая высокую производительность на GPU-инфраструктуре. Интересным аспектом архитектуры является размещение образов моделей в публичном Microsoft Container Registry при разрешенных лицензиях, что облегчает загрузку и обновление контейнеров, а также позволяет сохранять единое управляемое хранилище для всех необходимых компонентов. Проект предлагает простую и быстро реализуемую установку через Helm charts или Terraform, что делает его доступным для команд, работающих с инфраструктурой Kubernetes. Начать использование Kaito можно уже с минимальными YAML-манифестами, в которых описывается желаемая конфигурация рабочей среды с указанием требуемого типа инстанса и предустановленных моделей.

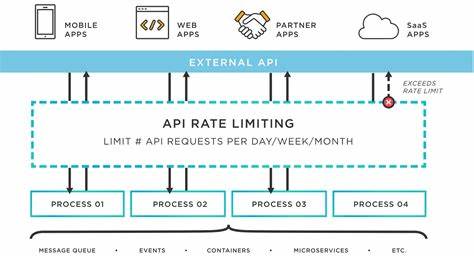

Помимо технических решений для развертывания, Kaito предоставляет разработчикам удобные API-сервисы с поддержкой OpenAI-совместимых эндпоинтов для вызова инференса, что упрощает интеграцию с существующими приложениями и сервисами. Наличие curl-примеров и полного набора документации способствует быстрому старту и снижает сложность поэтапного внедрения. Сообщество Kaito активно развивается и принимает вклад от пользователей, благодаря открытому исходному коду и публикации релизов с регулярным пополнением функционала. Приверженность проекту со стороны компании Microsoft и поддержка CNCF свидетельствуют о серьезности и перспективности инициативы. Использование Kaito в современных проектах AI позволяет компаниям избежать типичных проблем, связанных с ручным управлением вычислительными ресурсами и операционной интеграцией моделей.

Автоматизированное выделение GPU-нод, согласование ресурсов и процесс автоматического скрытого мониторинга рабочих нагрузок освобождают инженерные команды для решения более сложных задач исследования и разработки. Важным достоинством также является возможность кастомизации и расширения платформы под собственные модели и сценарии, обеспечивающая гибкость при внедрении нестандартных алгоритмов и специализированных рабочек AI. Kaito представляет собой один из самых передовых проектов, сочетающих сильные стороны Kubernetes и AI-индустрии. Его инновационный подход к автоматизации масштабируемого управления моделями прочно занимает место в экосистеме современных DevOps и MLOps инструментов. С темпами развития и новым функционалом, Kaito открывает широкие возможности для эффективного и удобного развертывания искусственного интеллекта в условиях современных облачных и гибридных кластеров.

Таким образом, Kaito — это мощный инструмент, который позволяет организациям проще и быстрее интегрировать AI-модели в инфраструктуру Kubernetes, минимизировать операционные сложности и максимально раскрыть потенциал моделей на GPU. Внедрение подобных решения способствует ускорению цифровой трансформации и формирует устойчивый фундамент для будущих достижений в области искусственного интеллекта и машинного обучения.