В современном мире вычислительных технологий развитие параллельных алгоритмов и аппаратного обеспечения становится ключевым фактором в повышении производительности и эффективности решения сложных математических задач. Одним из значительных шагов в этой области стала разработка компании NVIDIA — GPU-ускоренного решателя CuOpt, основанного на методе PDLP (Primal-Dual Hybrid Gradient). Эта технология открывает новые горизонты в области решения задач линейного и смешанно целочисленного программирования, обеспечивая впечатляющее ускорение по сравнению с традиционными CPU-алгоритмами. CuOpt был впервые представлен NVIDIA с громким заявлением о том, что данное GPU-ускоренное решение превосходит существующие CPU-решатели в 60% задач из библиотеки MIPLIB, широко используемой для бенчмаркинга оптимизационных моделей. Однако сама по себе высокая скорость вызвала вопросы о надежности: были зафиксированы сложности с сходимостью и снижением точности для некоторых типов задач, что подтверждали и внешние источники, такие как новостные публикации HiGHS и тематические блоги FICO.

Тем не менее, открытость проекта внушает оптимизм. CuOpt открыт для сообщества, что стимулирует развитие и улучшение решений, а также интеграцию с популярными открытыми платформами — проект уже добавлен в репозиторий COIN-OR, обладающий репутацией надежного хранилища оптимизационного ПО. Такая открытость позволяет исследователям и инженерам тестировать, модифицировать и как расширять функционал решения, что благоприятно сказывается на экосистеме математической оптимизации. Для тех, кто собирается познакомиться с CuOpt поближе, первым и самым важным условием является наличие NVIDIA GPU с поддержкой CUDA. Современные графические процессоры NVIDIA позволяют эффективно раскрыть потенциал PDLP благодаря параллелизации вычислений на тысячах ядер, что недостижимо для обычных CPU.

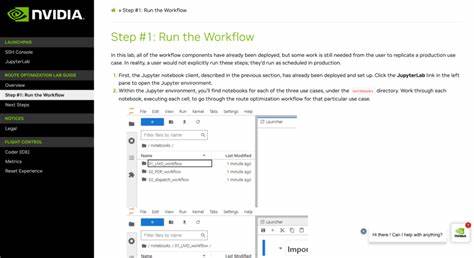

Автор обзора делится личным опытом использования GPU-инстанса от Linode с видеокартой RTX4000 Ada, которая доступна по цене 0,52 доллара в час. Такой подход позволяет экономно тестировать CuOpt без необходимости покупки дорогостоящего оборудования. Если говорить об установке, то она сравнительно проста, особенно при использовании подготовленных скриптов, которые настраивают драйвера CUDA, библиотеки и сам CuOpt. Автор подготовил репозиторий с тремя скриптами, позволяющими быстро и без проблем развернуть рабочее окружение на Ubuntu 24.04, что очень удобно для начинающих пользователей, не знакомых с тонкостями настройки CUDA и GPU-систем.

Чтобы оценить эффективность решения, был взят один из объемных примеров из MIPLIB — задачи trimtip1 с приблизительно 30 тысячами переменных и 15 тысячами ограничений. Решение с помощью CuOpt CLI при указанных параметрах показало высокую загрузку GPU на 100% на протяжении всего времени работы, при этом CPU задействовал лишь часть ресурсов — около двух ядер из шестнадцати. Такая эффективность использования GPU доказывает потенциал новой архитектуры для ускоренного решения больших задач без избыточной нагрузки на центральный процессор. Особый интерес вызывает вопрос масштабируемости — насколько улучшатся показатели при использовании нескольких GPU? Ограничение роста частоты центральных процессоров (обычно не превышающей около 5 ГГц) обусловлено тепловыми и энергетическими ограничениями, что фактически остановило повышение производительности CPU. При этом стремительный рост интереса к искусственному интеллекту и машинному обучению активизировал разработку мощных GPU и их кластеров, которые эффективно справляются с параллельными вычислениями.

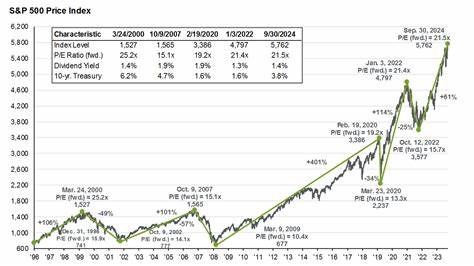

В этой связи GPU-ускоренные решатели, например CuOpt, обладают потенциалом стать стандартом в области математической оптимизации, получая прирост производительности с каждым новым поколением аппаратного обеспечения. Сравнительные тесты от Mittelmann, проведённые в июне 2025 года, исследовали работу CuOpt и реализации cuPDLP (исходя из объявления NVIDIA) на двух различных картах — RTX A6000 и топовой H100. Результаты показали, что в большинстве случаев H100 превосходит RTX A6000 от двух до шести раз по скорости решения крупных линейных задач, хотя и стоит в разы дороже. Это демонстрирует, что выбор оборудования влияет напрямую на результат и что инвестиции в более производительные GPU могут быть оправданы для особенно требовательных к ресурсам вычислительных сценариев. Однако стоит отметить, что представленные тесты охватывают очень большие и специфические задачи, типичные для научных и промышленных исследований с огромными объемами данных.

Для более узкоспециализированных областей и менее масштабных моделей результаты могут отличаться, что требует индивидуального подхода к выбору арсенала вычислительных средств. При этом сообщество пользователе и исследователей призывают самостоятельно тестировать CuOpt на своих данных, чтобы выявить оптимальные конфигурации и оценить, как меняется производительность с увеличением или заменой GPU. В целом, появление CuOpt можно рассматривать как важный этап в эволюции оптимизационного ПО — интеграция мощных GPU с алгоритмами линейного и смешанного программирования открывает перспективы для решения больших, сложных задач в промышленности, логистике, финансах и других сферах. NVIDIA делает значительный вклад, предоставляя инструмент с открытым исходным кодом, что стимулирует конкуренцию и развитие отрасли. Можно ожидать, что в ближайшем будущем коммерческие решения будут совершенствоваться, стремясь превзойти CuOpt по скорости, точности и удобству использования.