Интернет, каким мы его знаем сегодня, претерпел глубокие преобразования за последние десятилетия. Раньше он выглядел как децентрализованное пространство, где каждый мог создавать и обмениваться информацией свободно и независимо. Однако со временем крупные платформы-агрегаторы, такие как Google, Amazon, Facebook и другие, заняли доминирующее положение, контролируя практически все аспекты онлайн-взаимодействия. Почему так произошло и что стоит за этим феноменом? Понимание этого позволит заглянуть в будущее цифрового мира, в котором искусственный интеллект может кардинально изменить установленные правила. Ключ к разгадке кроется в глубинной архитектуре интернета и в сложном балансе безопасности, доступа и конфиденциальности.

В 1990-х годах команда инженеров Netscape внесла критичное решение, получившее название same-origin paradigm, или парадигма одного происхождения. Это техническое ограничение послужило мерой безопасности, направленной на то, чтобы сайты и приложения работали в строго изолированных средах. Таким образом, данные и скрипты одного источника не могли беспрепятственно взаимодействовать с ресурсами другого. Эта мера позволила предотвратить массу угроз и хакерских атак, но она также создала невидимые барьеры, превратив данные пользователей в своего рода узники внутри каждого отдельного приложения или сайта. Сегодня большинство пользователей даже не задумываются, что фото в iPhone, письма на Gmail и сообщения в Instagram технически находятся в отдельных и непроницаемых друг для друга экосистемах.

Это ограничение породило так называемый железный треугольник современного программного обеспечения. Разработчикам операционных систем и браузеров приходится делать сложный выбор между тремя важными параметрами системы: безопасностью личных данных пользователей, возможностью сетевого взаимодействия и достаточным уровнем доверия к стороннему коду. Можно обеспечить только два из трех элементов: например, разрешить приложению доступ к личным данным и к сети, однако в этом случае пострадает безопасность от непроверенного кода. Или же можно полностью изолировать приложения и заставить пользователей мириться с тем, что функциональность оказывается ограниченной. В результате все цифровые сервисы оказались в замкнутом пространстве, где обмен информацией и совместная работа приложений осложнены очень серьезно.

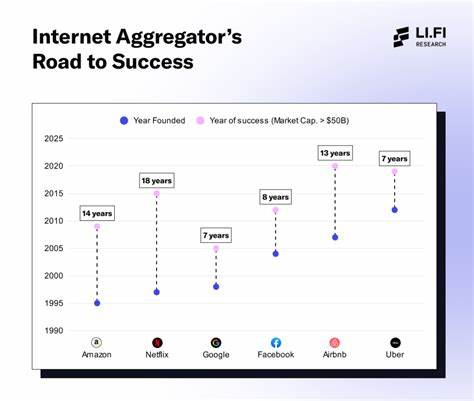

Из-за этого нагрузки и данные концентрируются на крупных агрегаторах — ведь именно они способны давать пользователям «всё в одном месте» без лишних сложностей. Пользователь, желая организовать путешествие, вынужден либо вручную копировать данные из разных сервисов, либо отдавать предпочтение единой платформе, которая уже агрегирует всю нужную информацию. Это привело к усилению эффектов масштаба, и технологические гиганты стали еще могущественнее, укрепляя свои позиции каждый раз, когда пользователь выбирал удобство единой экосистемы над разрозненными приложениями. В этом контексте на горизонте возникла новая надежда — искусственный интеллект. Современные языковые модели и алгоритмы позволяют создавать программное обеспечение практически без затрат времени и ресурсов.

Предприниматели и индивидуальные пользователи могут теперь создавать инструменты, адаптированные под свои специфические задачи и потребности. Появляется возможность создавать персонализированные помощники, которые подстраиваются под пользовательский стиль работы, анализируют сложные и разрозненные данные и помогают принимать решения. Это обещает уйти от «универсальных» продуктов в сторону глубокой персонализации. Однако если взглянуть на сегодняшние методы распространения софта — через централизованные магазины приложений, — мы увидим, что техническая проблема усложнения обмена данными лишь усугубляется. Больше приложений означает еще больше данных, запертых в отдельных «банках», что не позволяет создать действительно интегрированные и удобные решения.

Каждое приложение индивидуально ограничено в доступе к контексту пользователя, что снижает эффективность AI-помощников, делающих работу действительно полезной только при наличии широкого обзора. Самое радикальное и перспективное решение лежит в новых технологиях аппаратной безопасности — так называемых secure enclaves, или защищенных вычислительных зонах. Современные процессоры, например от Intel, AMD и ARM, способны выделять области оперативной памяти, полностью зашифрованные и недоступные даже для самих администраторов инфраструктуры или провайдеров облачных сервисов. Это революция в области доверия к исполняемому коду и работе с конфиденциальными данными. При помощи удаленной аттестации, обеспечивающей криптографические доказательства того, какой конкретно код запускается в таких защищенных зонах, можно навесить на каждый фрагмент данных собственные, жестко контролируемые политики доступа и использования.

Ваши фотографии, электронные письма, календарь — все они смогут «говорить» сами за себя, ограничивая доступ программ согласно вашим личным установкам и не позволяя передавать данные или использовать их вне ваших параметров. Это сломает сформировавшуюся архитектуру, заставив приложения работать с данными по новым, более гибким правилам. Если такая система станет массовой, мы сможем получить программное обеспечение нового поколения. Оно будет приватным по умолчанию, гибко подстраивающимся под ваши меняющиеся нужды и полностью прозрачным в плане того, как обрабатываются и защищаются ваши данные. Каждый пользователь сможет стать своим собственным архитектором цифрового пространства, не ограниченным рамками текущих крупных платформ и не отдающим все личные данные на растерзание беспрекословным монополиям.

Конечно, несмотря на удивительные технологические возможности, будущее будет зависеть от нашего общественного выбора. Вопросы доверия, правил регулирования и внедрения новых стандартов совместного использования и безопасности — все эти аспекты требуют не только технических решений, но и осознанного участия пользователей и разработчиков. Возможно, архитектура будущего интернета станет более децентрализованной и открытой, позволяющей объединять данные и сервисы по новым принципам, где личные данные и права на них будут непреложной основой взаимодействия. Подытоживая, можно сказать, что причина того, почему агрегаторы «съели» интернет, коренится в фундаментальном ошибочном техническом решении, заложенном более двадцати лет назад при создании моделей безопасности браузеров и операционных систем. Эта ошибка создала изолированные от друг друга цифровые миры, в которых перемещение и обмен данными сопряжены с огромными сложностями и рисками.