В современном мире высокопроизводительных вычислений технология CUDA занимает важное место благодаря своей способности использовать мощности графических процессоров NVIDIA для параллельной обработки данных. Написание CUDA ядер является ключевым этапом в разработке эффективных приложений, использующих возможности GPU. Глубокое понимание этой технологии необходимо не только для специалистов по вычислительной физике или машинному обучению, но и для инженеров программного обеспечения, стремящихся к оптимизации вычислительных алгоритмов. В данной статье мы рассмотрим основные аспекты разработки CUDA ядер, важные принципы, методы оптимизации и практические советы для достижения высокой производительности.КUDA (Compute Unified Device Architecture) — это платформа и программная модель, разработанная компанией NVIDIA, которая позволяет программистам использовать графические процессоры (GPU) для выполнения вычислительных задач общего назначения.

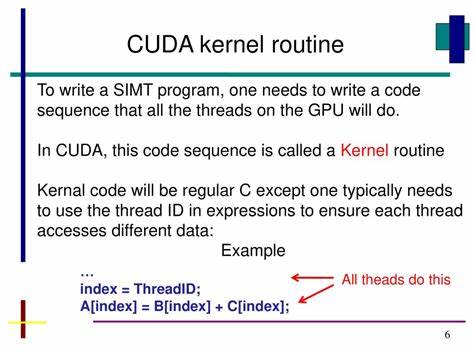

В центре внимания CUDA находится возможность запуска тысячи параллельных потоков, которые обрабатывают данные в распределённой и синхронизированной форме. Основным элементом программирования является CUDA ядро — функция, которая запускается на GPU и выполняется множеством параллельных экземпляров. Программирование CUDA ядер требует знания архитектуры GPU, модели памяти и особенностей работы планировщика потоков.Одним из важных факторов эффективного написания CUDA ядер является понимание архитектуры потоков и блоков. В CUDA программа разбивается на блоки, каждый из которых содержит множество потоков.

Эти блоки выполняются параллельно на различных вычислительных мультипроцессорах GPU, что позволяет добиться высокой степени параллелизма. Понимание распределения потоков и организации памяти является фундаментальным для оптимизации кода и сокращения времени выполнения.Для написания CUDA ядра разработчик должен учитывать особенности памяти — глобальную, разделяемую, локальную и константную. Глобальная память имеет высокую задержку, но большой объем. Разделяемая память располагается в пределах блока и обеспечивает быстрый доступ для потоков одного блока, что помогает уменьшить задержки при совместном использовании данных.

Оптимальное использование памяти позволяет избежать узких мест, связанных с зависанием при доступе к данным, и существенно повысить производительность.Особое внимание при разработке CUDA ядер уделяется параллелизму и синхронизации. Все потоки внутри блока могут синхронизироваться посредством специальной функции __syncthreads(), которая гарантирует, что все операции памяти будут завершены до перехода к следующему этапу. Некорректное использование синхронизации может привести к ошибкам гонки или взаимоблокировкам, что негативно отразится на результатах вычислений и стабильности приложения.Оптимизация CUDA ядра включает в себя несколько ключевых подходов.

Прежде всего стоит минимизировать количество обращений к глобальной памяти, максимально используя разделяемую память. Загрузка данных в разделяемую память может снизить задержки до минимума. Также важен выбор корректных размеров сетки и блоков, поскольку неправильный подбор влияет на эффективность использования вычислительных ресурсов. Кроме того необходимо избегать разветвления потока (thread divergence), когда потоки внутри одного блока выполняют разные инструкции, что снижает эффективность параллельной обработки.Немаловажным аспектом разработки CUDA ядер является отладка и профилирование.

Инструменты NVIDIA, такие как Nsight Compute и Visual Profiler, предоставляют подробные метрики использования ресурсов GPU, выявляют узкие места и позволяют проводить оптимизацию по шагам. Мониторинг потребления памяти, количества операций, эффективности кэширования помогает разработчику понять, какие части ядра нуждаются в доработке.Начинающим CUDA разработчикам рекомендуется изучить готовые примеры из официальной документации NVIDIA, которые демонстрируют распространённые алгоритмы и техники. По мере накопления опыта становится возможным создавать более сложные ядра, интегрировать CUDA код в большие проекты и использовать специализированные библиотеки, такие как cuBLAS и cuDNN, которые предоставляют высокоэффективные реализации базовых алгоритмов.С особым интересом следует отнестись к новым возможностям последних версий CUDA и архитектур GPU.