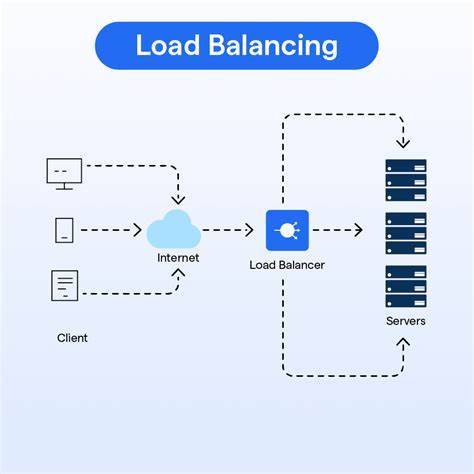

Балансировка нагрузки в компьютерных системах всегда была одной из ключевых задач, обеспечивающих эффективное использование ресурсов и высокую производительность. С течением времени задачи планирования процессов и распределения вычислительных нагрузок приобрели сложность, обусловленную развитием многопроцессорных архитектур, появлением гетерогенных и NUMA-систем, а также ростом требований к латентности, энергоэффективности и качеству обслуживания. Традиционные подходы к планированию и балансировке нагрузки, построенные на статических алгоритмах, уже не соответствуют реалиям сегодняшних вычислительных сред. Именно здесь на помощь приходит машинное обучение, позволяющее создавать более адаптивные и интеллектуальные планировщики, способные эффективно управлять ресурсами в сложных условиях. Развитие планировщиков Linux насчитывает длительную историю.

Система планирования задач прошла через множество преобразований, начиная с появившегося в 2007 году полностью справедливого планировщика (CFS), который долгое время считался универсальным решением для всех сценариев использования. В течение этих лет предпринимались попытки создания специализированных альтернатив, таких как BFS и MuQSS, ориентированные на оптимизацию конкретных рабочих нагрузок. Однако универсальность одного алгоритма планирования постепенно перестала отвечать новым реалиям, когда появились многоядерные системы с большим числом процессоров — иногда более 48, включающих устройства с разным типом ядер и архитектурой. Ключевым моментом в развитии Linux стал выпуск ядра версии 6.12 с внедрением расширяемого класса планировщика sched_ext, который открыл двери для загрузки кастомных планировщиков, реализованных через BPF-функции.

Это позволило экспериментировать с новыми алгоритмами, за счет чего появилась возможность создавать интеллектуальные и адаптивные механизмы распределения задач по ядрам в режиме реального времени. Одной из таких инициатив стала работа Чинг-Чунь (Джим) Хуаня, представленная на Open Source Summit North America 2025. Его проект показал насколько машинное обучение способно изменить представление о балансировке нагрузки. Сложности современных систем выражаются в нескольких аспектах. Во-первых, архитектуры с несколькими процессорными узлами, когда память физически разбросана по узлам, а доступ к ней сопровождается различными задержками (NUMA), требуют умного распределения задач, чтобы избежать ухудшения производительности из-за плохой локализации памяти.

Во-вторых, гетерогенные системы с разными типами ядер (например, высокопроизводительные и энергосберегающие) нуждаются в точном определении, где именно выполнить ту или иную задачу для достижения баланса между скоростью и энергопотреблением. Это особенно критично для современных рабочих нагрузок, включающих как интерактивные задачи с чувствительностью к задержкам — игра, потоковое видео, реальное время, — так и ресурсоемкие задачи, такие как компиляция кода или обработка больших данных. Традиционные планировщики, например CFS или EEVDF, полагаются на фиксированные эвристики и алгоритмы, которые не учитывают все многообразие условий и параметров современных систем и приложений. Это порождает задачи, которые либо выполняются неэффективно, либо выдают непредсказуемые задержки. В таких условиях администраторы часто прибегают к жесткой фиксации процессов на конкретных CPU или разделяют систему на части, что является скорее временным обходным решением, чем системным исправлением.

С точки зрения задач балансировки, машинное обучение представляет собой идеальный инструмент. Алгоритмы могут обрабатывать большое количество параметров: приоритет и требования задач, статистику использования процессоров, время виртуального выполнения, особенности памяти и кэширования, энергопотребление и ещё множество факторов, включая специфичные требования конкретного приложения. Более того, благодаря способности к обучению и переобучению, такие алгоритмы способны адаптироваться к меняющимся условиям, что невозможно обеспечить традиционными методами. Примером успешного применения этой концепции стал проект Free5GC, работающий над средствами обработки сетевого трафика 5G. Обычно такие системы требуют строжайших ограничений по задержкам и одновременно высокой вычислительной мощности.

Классический планировщик не обеспечивает нужного качества сервиса, а разделение CPU на группы для различных типов задач приводит к недостаткам: блокировка важных задач за счет менее приоритетных, неравномерная загрузка, возрастание количества миграций процессов и, как следствие, потеря производительности. Интеграция машинного обучения в sched_ext позволила создавать модели, которые учитывают множество параметров и принимают решения на основе анализа исторических данных о миграциях и их результатах. Такой планировщик начинает работу в режиме сбора данных, после чего в пользовательском пространстве обучается нейронная сеть, модель которой загружается обратно в ядро и используется для принятия решений. Постоянное обновление модели обеспечивает корректировку с учетом изменений нагрузки и архитектуры. Особенность машинного обучения в ядре Linux связана с ограничениями, например отсутствием поддержки операций с плавающей точкой в режиме ядра, что обычно требуется для нейронных сетей.

Для решения этой проблемы применена арифметика с фиксированной точкой, что позволило адаптировать алгоритмы под системные ограничения без потери производительности. Практические результаты применения новой технологии впечатляют. В тестах на компиляцию ядра Linux улучшение производительности составило около десяти процентов, а количество переходов задач между CPU было сокращено почти на восемьдесят процентов. Это значительно снижает накладные расходы, связанные с миграцией и переключением контекста, что особенно важно для систем с высокой нагрузкой. Машинное обучение в планировщиках представляет собой распознавание сложных паттернов и зависимостей, недоступных для традиционных статических алгоритмов.

Оно позволяет учитывать десятки параметров одновременно, соотнося их между собой и принимая балансирующие решения, которые автоматизированно обновляются по мере изменения системы и типов рабочих нагрузок. Итогом можно считать переход от универсального фиксированного алгоритма к гибридному подходу, способному подстраиваться под реальные условия эксплуатации. Такой сдвиг меняет понимание планирования и устанавливает новые стандарты эффективности многопроцессорных и гетерогенных систем. В перспективе можно ожидать дальнейшее развитие интеллектуальных планировщиков и интеграцию расширенных моделей машинного обучения, что будет способствовать росту производительности и улучшению пользовательского опыта во множестве областей — от серверных решений до мобильных устройств и специализированных промышленных систем. Таким образом, использование машинного обучения в балансировке нагрузки в ядре Linux представляет собой важный и востребованный шаг эволюции системного программного обеспечения.

Оно позволяет преодолевать фундаментальные ограничения традиционных моделей, адаптироваться к стремительно меняющимся технологическим условиям и эффективно использовать все возможности современных вычислительных платформ.