Современные языковые модели переживают настоящий бум. Благодаря успехам в нейросетевых технологиях и увеличению вычислительных ресурсов они способны обрабатывать огромные объемы текстовой информации, выполнять сложные задания и даже создавать осмысленные тексты, которые порой трудно отличить от написанных человеком. Развитие таких моделей, как GPT-4, Claude или PaLM, открывает новые горизонты применения искусственного интеллекта. Однако, несмотря на впечатляющие способности, существует один фундаментальный недостаток, который препятствует дальнейшему совершенствованию ИИ — неспособность языковых моделей определить, что именно отсутствует в тексте. Этот аспект стал центральной темой недавнего исследования под названием AbsenceBench, которое выявляет ограничения современных трансформерных языковых моделей в выявлении пропущенной информации и объясняет причины этой проблемы.

В данной статье мы подробно рассмотрим суть проблемы, методы исследования, полученные результаты и возможные пути решения, а также объясним, почему понимание того, что отсутствует, столь важно для интеллектуальных систем. Чтобы осознать проблему, прежде всего необходимо понять, как работают современные языковые модели. Базовая архитектура многих современных моделей — это трансформеры, которые на основе механизмов внимания анализируют текстовые последовательности. Модель обучается предсказывать следующий токен или слова, используя контекст, который развернут до нескольких тысяч токенов. В этом процессе она эффективно обращает внимание на конкретные элементы входного текста и использует их для создания осмысленного ответа.

Однако именно такая направленность на фактические наличные элементы текста порождает сложность в понимании отсутствия. Исследование AbsenceBench ставит перед собой цель проверить, насколько эффективно модели могут не просто найти информацию, но и распознать ее явное отсутствие. Для этого был создан специальный набор задач и данных, которые включают три области: числовые последовательности, поэзию и запросы к GitHub-проектам с изменениями кода. Модели предоставляются оригинальные тексты и их отредактированные версии, в которых намеренно удалены определенные сегменты. Основная задача — корректно выявить, какие именно части были вырезаны.

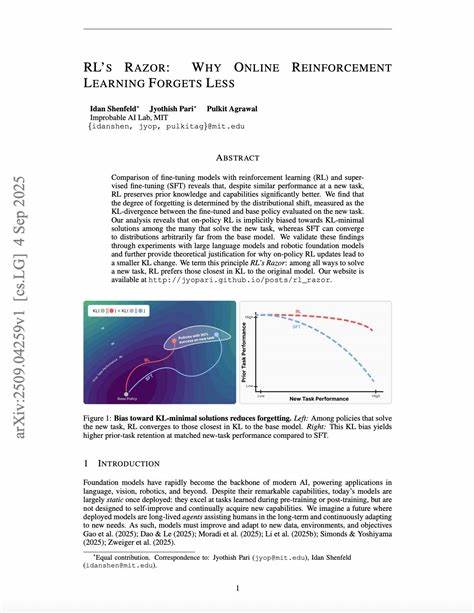

Результаты экспериментов удивляют. Несмотря на то, что современные модели демонстрируют потрясающую точность в задачах поиска информации, например, в тесте Needle in a Haystack (NIAH), где требуется найти «иголку в стоге сена», их эффективность в выявлении отсутствия ограничивается примерно 70% по F1-метрике при среднем контексте длиной 5 тысяч токенов. Это говорит о том, что даже самые продвинутые системы не способны надежно распознавать нехарактерные для них виды информации — отсутствие или пропуск. Почему же модели испытывают такие трудности? Основная причина кроется в архитектуре трансформеров. Механизм внимания фокусируется на присутствующих ключах — фактических элементах текста.

Отсутствующая же информация не создает «ключей» для внимания, следовательно, модель не может обратить на неё взгляд. Иными словами, трансформермеханизмы не умеют напрямую «смотреть» в пустоту или распознавать разрывы на уровне текста, что принципиально ограничивает их возможности в задачах, связанных с отсутствием. Это разоблачение несет серьезные практические последствия. В реальном мире часто встречаются ситуации, когда важно не только понять, что есть в тексте, но и выяснить, чего именно там не хватает. Например, при анализе юридических документов пропущенные пункты могут изменить всю суть соглашения.

В продуктах программирования, таких как GitHub, недостающие изменения кода могут привести к ошибкам или уязвимостям. В поэзии или литературе пропуски могут менять смысл произведения или нарушать структуру. Неумение языковых моделей замечать такие пустоты ограничивает их применяемость в задачах глубокого анализа, проверки и аудита. Кроме архитектурных причин, существует и методологический вызов. Большинство языковых моделей обучаются на огромных объемах текстов, где преобладает задача заполнения или генерации переходов между словами и предложениями.

Обучение не содержит систематического акцента на выявление отсутствий или пропусков в контексте. Это создает пробел в навыках модели, отражающийся на её поведении в специфических тестах, подобных AbsenceBench. Исследование AbsenceBench, помимо демонстрации проблемы, предлагает важный урок о гранях развития искусственного интеллекта. С одной стороны, модели уже способны на выполнение сложных задач, превосходя человека в поиске редкой информации. С другой — они слабы в распознавании пропущенного, что является критическим аспектом человеческого восприятия и критического мышления.

Значит, дальнейшее развитие ИИ должно включать не только улучшение механизма внимания, но и инновационные подходы к представлению информации, учитывающие отсутствие как сигнал. Открытый исходный код и набор данных AbsenceBench доступны исследователям и разработчикам, что позволяет погрузиться в проблему глубже и разрабатывать новые методы обучения и архитектуры моделей. Некоторые пути потенциального улучшения включают внедрение специальных токенов, которые могут обозначать пустые места, расширение контекстного окна для отслеживания структурных разрывов, интеграцию логических и семантических проверок, а также комбинирование языковых моделей с внешними системами отслеживания изменений документа. В целом, AbsenceBench — это важный поворот в понимании возможностей и ограничений современных языковых моделей. Он подчеркивает, что прогресс в области искусственного интеллекта не должен ограничиваться освоением очевидных или традиционно понятных задач.