В последние годы большие языковые модели (LLM) стремительно завоевали позиции в сфере искусственного интеллекта, становясь ключевым элементом современных решений. Масштабирование и эффективное использование таких моделей требуют передовых инструментов и платформ, способных упростить эти процессы. Именно поэтому платформа Ray представила новые нативные API для работы с LLM в Ray Data и Ray Serve, которые открывают перед разработчиками новые горизонты для развертывания и масштабирования ИИ-приложений с использованием больших языковых моделей. В данной статье будет рассмотрено, что представляет собой эта новая функциональность, как она облегчает жизнь разработчикам и какие задачи существенно упрощает с точки зрения интеграции и эксплуатации LLM. Ray Data и Ray Serve – это две ключевые составляющие экосистемы Ray, направленные на упрощение процессов обработки данных и развертывания сервисов в распределённых системах.

Ray Data обеспечивает эффективное распределённое хранение, загрузку и предобработку данных, что чрезвычайно важно для построения высокопроизводительных пайплайнов. Ray Serve, в свою очередь, выступает мощной системой развёртывания и управления микросервисами и моделями машинного обучения, поддерживая динамическое масштабирование и балансировку нагрузки в реальном времени. Нативные API для LLM открывают возможность использовать в рамках Ray Data и Ray Serve полноценные интерфейсы для работы с большими языковыми моделями как для оффлайн пакетного вывода (batch inference), так и для онлайн-инференса с минимальной задержкой. До появления этих API разработчикам приходилось создавать обширный код с многочисленными вспомогательными утилитами и настройками, чтобы адаптировать Ray Data и Ray Serve под модельные рабочие нагрузки с LLM. Новые API минимизируют рутинную работу, предлагая удобные и интуитивно понятные инструменты для интеграции.

С Ray Data LLM интеграция моделей становится частью общих пайплайнов обработки данных. Это позволяет выполнять пакетный вывод моделей на больших объёмах данных с предельно эффективным использованием ресурсов за счёт распределённой обработки. Интерфейс Ray Data LLM построен вокруг создания Processor-объектов, которые учитывают шаблоны запросов, параметры сэмплирования, а также настройку конкретных движков вывода, например, vLLM. Такие процессоры можно применять к наборам данных, автоматически обрабатывая и преобразуя тексты с помощью большого языкового ядра. Этот подход существенно ускоряет построение цепочек обработки с участием LLM, позволяя, к примеру, включать этап генерации текста или семантической обработки непосредственно в конвейер данных без необходимости выносить их за пределы системы.

По сути, Ray Data LLM снимает необходимость в развертывании множества отдельных инстансов онлайн-серверов для пакетного вывода, а также избавляет от сложных прокси или балансировщиков нагрузки, которые обычно требуются для получения необходимого уровня производительности. Это позволяет сэкономить время и ресурсы, сосредоточив усилия на бизнес-логике и эффективной обработке данных. Особое внимание уделено поддержке OpenAI-совместимых API, что даёт разработчикам возможность без проблем интегрироваться с широким спектром существующих решений и моделей, работающих по схеме API OpenAI. Более того, пользователи могут задавать шаблоны запроса (prompt templates), а также управлять параметрами сэмплирования непосредственно на уровне отдельной строки данных, что позволяет реализовать гибкую и тонконастроенную генерацию ответов. Ray Serve LLM — это инструмент для развертывания в режиме онлайн, позволяющий создавать масштабируемые приложения с несколькими моделями однотипно и упрощенно.

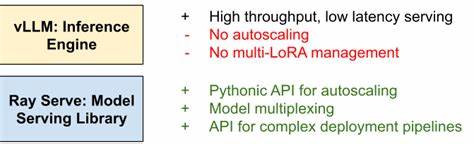

Он предлагает авто-масштабирование, балансировку нагрузки, поддержку мульти-модельных развертываний и полную совместимость с API OpenAI, что делает его удобным решением для промышленного использования. Кроме того, Ray Serve LLM поддерживает multi-LoRA — возможность использования множества адаптеров для дообучения и кастомизации базовых моделей, что особенно актуально для бизнеса, стремящегося к тонкой настройке ИИ. Интеграция с движком vLLM — серьезным достижением на рынке, специализирующимся на низколатентном и высокопроизводительном выводе LLM — раскрывает дополнительные возможности оркестрации и комплексного управления. Вместе Ray Serve и vLLM обеспечивают полноценную инфраструктуру, где vLLM фокусируется на одиночных репликах моделей, а Ray Serve добавляет уровень управления масштабированием, распределением нагрузки и построением сложных конвейеров с множеством моделей. Практическое применение может быть проиллюстрировано развертыванием диалоговой модели Qwen с поддержкой двух GPU на локальном кластере, интегрированной с OpenAI-совместимым маршрутизатором.

Такой подход позволяет не только обеспечивать высокую производительность, но и автоматически масштабироваться в зависимости от поступающих запросов, что гарантирует стабильность и эффективность работы. Поддержка Kubernetes через KubeRay открывает возможности для масштабирования в облачных инфраструктурах, помогая предприятиям быстро и надежно внедрять приложения на базе LLM в продакшен. Все это сопровождается развитой документацией и примерами, которые помогают быстро начать работу даже с минимальным опытом взаимодействия с Ray. В сумме, нативные API для LLM в Ray Data и Ray Serve создают мощный и гибкий фундамент, устраняющий традиционные сложности в работе с большими языковыми моделями. Они выводят автоматизацию на новый уровень, позволяя сосредоточиться на решении прикладных задач, а не на тонкостях инфраструктуры и интеграции.

Это особенно важно в условиях быстрорастущих потребностей в масштабировании AI-систем и необходимости идеальной производительности, минимальных задержек и высокой доступности. Сообщество разработчиков Ray активно развивается, и новые функции находятся в постоянном развитии. Пользователям предлагается делиться отзывами, участвовать в обсуждениях на Ray Slack и Discourse, а также следить за дорожной картой проектов, чтобы всегда быть в курсе последних обновлений и нововведений. Гибкость этой платформы позволяет легко адаптироваться под различные ветви развития искусственного интеллекта, что делает Ray с нативной поддержкой LLM идеальным выбором для бизнеса и исследователей, стремящихся работать с большими языковыми моделями эффективно и современно. Таким образом, введение нативных API для LLM в Ray Data и Ray Serve знаменует собой важный этап в эволюции платформы Ray, сочетая высокую производительность, простоту использования и расширенную функциональность.

Это открывает перспективы для создания более интеллектуальных, масштабируемых и надежных ИИ-систем, что несомненно будет способствовать новому витку инноваций и практических внедрений в самых разных сферах деятельности.