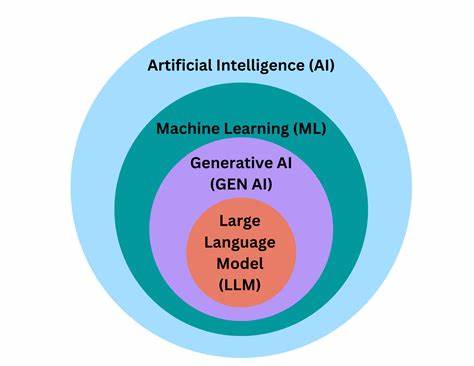

Большие языковые модели (LLM) сегодня стали одними из самых обсуждаемых и перспективных технологий искусственного интеллекта. Они способны генерировать связные тексты, отвечать на вопросы, писать код и даже участвовать в сложном планировании, вызывая восхищение и одновременно порождая множество вопросов о том, как именно они работают и что стоит за их «интеллектом». Разъяснение работы LLM сложно назвать однозначным — зачастую говорят, что «никто не знает», как именно они функционируют в деталях. Однако понимание устройства этих моделей важно не для того, чтобы постичь каждую мельчайшую техническую деталь, а чтобы разумно использовать LLM в самых разных сферах жизни и бизнеса. В основе LLM лежит имитация крайне сложного статистического предсказания следующего слова в тексте на основе огромного количества данных, которые они получили в процессе обучения.

Модель воспринимает входящий текст как последовательность токенов и старается спрогнозировать, что лучше всего вписать дальше. Эти предсказания накладываются одно на другое, создавая смысловые связки и, по сути, отслеживая и воспроизводя паттерны языка, накопленные в корпусе обучения. Такое умение кажется почти магическим, но в действительности это глубоко прагматичная и технически обоснованная задача. Но почему же тогда часто говорят, что LLM склонны к «галлюцинациям», выдумывают факты или даже «лгут»? Понимание здесь кроется в том, что модели не обладают сознанием или истинным пониманием мира. Их задача просто «заполнить» текст, руководствуясь вероятностями из набора данных, и они делают это блестяще, но без истинного знания или намерения.

Когда им не хватает информации или вопрос выходит за рамки обучающей базы, модель может сгенерировать неправдоподобные или вымышленные ответы. Это не ошибка сознания, а ограничение архитектуры. Контекст, который получает LLM вместе с запросом, играет решающую роль в точности и релевантности ответов. Модель не имеет внутреннего знания о мире, как человек, а лишь ту информацию, которую передают ей в запросе вместе с накопленными весами и паттернами. Если контекст беден или недостаточно ясен, модель вынуждена «додумывать» ситуацию, порождая потенциально неверные выводы.

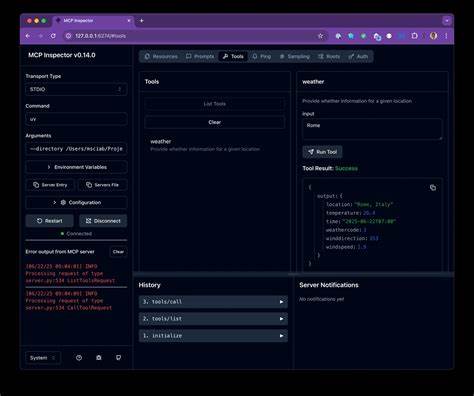

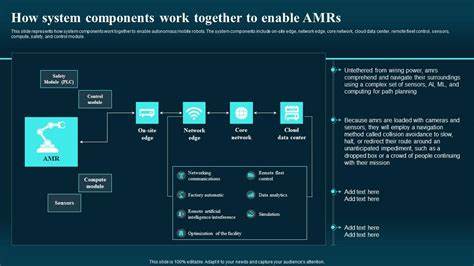

Именно поэтому искусство составления правильных запросов, известное как «контекстное проектирование» или prompt engineering, становится ключевым инструментом в работе с LLM. Обеспечить правильные, релевантные и полные сведения для модели — значит значительно повысить качество и достоверность ответов. Интересно, что в современной практике появились так называемые LLM-агенты — полуавтономные системы, которые планируют и выполняют сложные серии действий, например пишут код или решают бизнес-задачи. В этой роли они демонстрируют новые проблемы и парадоксы. Несмотря на высокую «умность» и когнитивные навыки вроде последовательного мышления, они порой совершают курьезные ошибки, «застревают» в неэффективных циклах рассуждений или не могут выполнить даже простейшую задачу без ошибок.

Это свидетельствует о фундаментальных ограничениях их архитектуры и особенностях обработки информации. Еще один важный аспект — восприятие LLM через призму человеческой психологии и философии. Веских оснований считать, что модели намеренно «лгут» или обладают скрытыми мотивациями, нет. Их поведение можно лучше понять как результат воспроизведения паттернов и контекстов, которые им были заданы, а не как акт сознательного выбора или притворства. В некоторых экспериментах модели даже проявляют склонность к самокритике или «рассуждениям о собственном состоянии», что лишь подчеркивает сложность их внутреннего процесса, которая не укладывается в привычные рамки понимания интеллекта.

Чем сложнее и более неоднозначной становится задача, тем более значим становится внешний контекст — дополнительная информация, история взаимодействия, доступ к вспомогательным инструментам и знаниям. Это можно сравнить с расширением когнитивных способностей модели за счет внешних средств, напоминая теории о расширенном уме, где человеческое мышление обогащается инструментами и окружающей средой. Таким образом, эффективное использование LLM — это не только вопрос технологий, но и вопрос разработки архитектур взаимодействия, грамотного контекстного проектирования и создания надежных систем валидации полученных данных. Понимание этих аспектов важно для снижения рисков от некорректных ответов, повышения общей надежности и продвинутого применения искусственного интеллекта. Зачем нам такое глубокое понимание, если модель сама по себе уже решает многие задачи? Потому что результат зависит не только от модели, но и от того, насколько мы умеем интегрировать ее в реальную среду и направлять.

Понимание границ, сильных и слабых сторон LLM помогает создавать более интеллектуальные системы, которые не только генерируют текст, но и обладают практической полезностью. И наконец, постоянное изучение и развитие методов работы с LLM станет ключом к созданию систем следующего поколения — более адаптивных, контекстно осознанных и надежных в самых различных прикладных задачах, от путешествий до научных открытий. Будущее больших языковых моделей – это больше, чем просто текст, это взаимодействие, обучение и совместное творчество человека и машины в постоянно меняющемся мире информации и знаний.