Современные разработки в сфере искусственного интеллекта неизбежно приводят к появлению все более сложных моделей, которые требуют от разработчиков не только уметь использовать их возможности, но и понимать внутренний механизм принятия решений. В этом контексте модель Gemini на платформе Vertex AI открывает новые горизонты благодаря внедрению функции logprobs – уникального инструмента, раскрывающего вероятностные оценки выбранных моделью токенов и их альтернатив. Это дает возможность глубже проникнуть в суть работы модели, устранить эффект «черного ящика» и создавать приложения с более высоким уровнем доверия и адаптивности. Logprobs – что это и почему важно понимать? В основе работы языковых моделей лежит вероятность выбора следующего слова или символа, выражаемая числом от 0 до 1. Однако для удобства и точности вычислений применяют перестроенное значение – натуральный логарифм этой вероятности, называемый logprob.

Logprob всегда меньше или равен нулю, где значение, ближе к нулю, указывает на более уверенный выбор модели. Такой способ представления информации помогает не просто видеть итог, но и понимать, насколько вероятен конкретный выбор относительно других возможных. В практическом плане logprobs позволяют разработчикам взглянуть на альтернативные варианты, которые модель рассматривала на каждом шаге генерации текста, и оценить уровень уверенности в своем ответе. Это трансформирует взаимодействие с ИИ и открывает возможности для создания более прозрачных, объяснимых и управляемых систем. Настройка и активация функции logprobs в Vertex AI Перед началом работы с logprobs необходимо подготовить среду и установить необходимые инструменты.

Google GenAI SDK для Python обеспечивает удобный интерфейс для взаимодействия с Vertex AI и моделью Gemini. При подготовке важно правильно указать идентификатор проекта и регион, чтобы гарантировать аутентификацию и получение актуальных данных. После инициализации клиента и выбора модели, например, «gemini-2.5-flash», можно приступить к настройке параметров генерации. Чтобы активировать logprobs, в объекте конфигурации генерации указывается параметр response_logprobs со значением True.

Дополнительно параметр logprobs отвечает за количество альтернативных топ-выборов модели на каждом шаге, с которым можно экспериментировать в диапазоне от 1 до 20. Погружение в результаты: как читать logprobs Когда модель генерирует ответ, она возвращает не только итоговый текст, но и подробные данные о вероятностях каждого выбранного токена и альтернатив рядом с ним. Анализируя эти сведения — например, просматривая токен «Neutral» с logprob -0.0214 и сравнивая с альтернативами «Positive» и «Negative», чьи значения значительно ниже, разработчик может понять, что модель была решительно уверена в своем ответе. Это позволяет использовать logprobs не просто для отладки, но и для повышения качества решений.

Если разница между вероятностями минимальна, можно рассматривать такие исходы как неоднозначные, требующие дополнительной проверки или вмешательства человека. Практические применения logprobs В первую очередь logprobs меняют подход к классификации текста. Вместо однозначного ответа появляется возможность выявлять сомнительные случаи, где модель выражает низкую уверенность. Это особенно ценно в задачах автоматизации бизнес-процессов, где критична точность и прозрачность решений. Благодаря логарифмическим вероятностям можно установить пороги доверия и направлять неуверенные варианты на ручную модерацию.

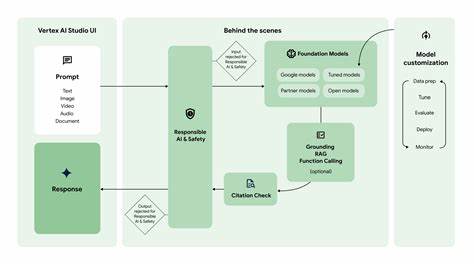

Динамические автодополнения – еще одна сфера, где использование logprobs становится настоящим прорывом. Постоянный мониторинг вероятностного распределения следующих слов в зависимости от контекста позволяет предлагать пользователям наиболее релевантные варианты, улучшая пользовательский опыт и снижая количество ошибок или непонятных предложений. Помимо этого, logprobs активно применяются в системах Retrieval-Augmented Generation (RAG). Здесь важно понимать, насколько ответ основан на достоверном извлечении из базы знаний. Повышенная уверенность модели, выражаемая высокими logprob, сигнализирует о том, что ответ подкреплен релевантной информацией, что позволяет автоматизировать оценку качества и повышать точность интеллектуальных систем.

Разработка смарт-систем с помощью подробного анализа logprobs Анализ logprobs стимулирует инновации в построении решений, основанных на ИИ. Понимание не только итогового результата, но и вероятностного профиля выбора формирует основу для создания адаптивных, контекстно-зависимых систем. Например, в задачах машинного перевода или генерации текстов благодаря logprobs можно улучшить качество вывода за счет тщательной диагностики каждого шага генерации и коррекции сомнительных фрагментов. Также logprobs поддерживают обучение и тестирование моделей. Анализ распределения вероятностей помогает выявить слабые места модели и направить усилия на улучшение тренировочных данных или архитектуры.

Это ценный инструмент обратной связи для разработчиков и исследователей. Технические детали интеграции и лучшие практики Использование logprobs требует аккуратности в проектировании запросов и обработки ответов. При крупных объемах данных целесообразно автоматизировать разбор и визуализацию логарифмических вероятностей с помощью удобных функций и интерфейсов. Встроенные средства SDK Google GenAI упрощают эту задачу благодаря готовым структурам и примерам кода. Важно понимать ограничения: значение logprob особенно полезно при сравнении вариантов в пределах одного шага генерации, но для комплексного анализа рекомендуется сочетать эту метрику с другими параметрами и качественными оценками.

Кроме того, настройка количества альтернатив (logprobs=3, 5 или больше) влияет на степень детализации и время отклика модели. Влияние на будущее разработки и ИИ-экосистемы Функция logprobs в Gemini на платформе Vertex AI знаменует качественный шаг вперед в области объяснимого искусственного интеллекта. Это позволяет разработчикам не только получить мощные возможности генерации текста, но и осознанно управлять рисками ошибок и неточностей. Трансформация черного ящика в открытое поле для анализа поднимает планку качества в индустрии. Этот тренд резонирует с требованиями регуляторов, этических норм и запросами пользователей, для которых прозрачность становится приоритетом.

Возможность видеть, почему модель выбирает именно то или иное слово, открывает путь для создания более безопасных, справедливых и эффективных приложений во множестве сфер – от медицины и права до образования и развлечений. В заключение Интеграция logprobs в Gemini на Vertex AI — это инструмент, который меняет само понимание взаимодействия с языковыми моделями. Он дает разработчикам возможность понимать модель на глубоком уровне, выявлять моменты неуверенности, создавать более интеллектуальные функции и повышать доверие к результатам. Применение этих знаний позволяет создавать приложения, которые не просто генерируют текст, а делают это осознанно, надежно и с высоким уровнем прозрачности. Исследование logprobs – это начало пути к более продвинутым способам работы с ИИ.

Практические кейсы, рассмотренные вместе с разработчиками Google, открывают широкие возможности для использования этой функции в разнообразных сценариях, стимулируя развитие технологий искусственного интеллекта и расширяя их пользу для бизнеса и общества в целом.