Большой адронный коллайдер (БАК) в ЦЕРН — одно из самых грандиозных и сложных научных предприятий современности. Каждый день в нём сталкиваются сотни миллиардов протонов с невероятными энергиями, создавая условия, способные раскрыть тайны самой структуры Вселенной. Несмотря на мощь этого оборудования, интерпретировать получаемые данные оказывается необычайно трудно из-за фундаментальных законов, действующих в квантовом мире. Одной из таких ключевых проблем является квантовая интерференция, которая долгое время мешала учёным спокойно анализировать результаты столкновений. Однако теперь аспирант из лаборатории IJCLab в Орсэ, Аишик Гош, предложил инновационный метод на базе глубоких нейронных сетей, который обещает преодолеть эти сложности и значительно повысить точность исследований.

В основе экспериментов БАК лежит не просто регистрация «картинок» с частицами, а тонкий статистический анализ множества событий, который позволяет делать выводы о природе элементарных частиц, таких как частица Хиггса. Хиггс, впервые обнаруженный в 2012 году, играет ключевую роль в объяснении механизма появления массы у фундаментальных частиц. Для более глубокого понимания его свойств учёные исследуют, как именно он образуется и распадается в ходе протонных столкновений. Однако здесь возникает сложность в виде квантовой интерференции — явления, когда разные вероятные пути взаимодействия частиц могут усиливать или ослаблять друг друга, что усложняет выявление «чистого» сигнала Хиггса. Интерференция — это классический феномен квантовой механики, хорошо иллюстрируемый знаменитым опытом с двумя щелями, в котором электроны проявляют свойства волн, создавая на экране чередующиеся светлые и тёмные полосы.

Аналогично, в БАК разные «истории» возникновения одних и тех же конечных состояний частиц могут накладываться друг на друга, вызывая взаимное влияние искажающее частотность их появления. Так, например, путь, когда два переносчика слабого взаимодействия W-бозона объединяются в Хиггса, который затем распадается на пару Z-бозонов, конкурирует с другим процессом — непосредственным образованием пары Z-бозонов без участия Хиггса. Эти два варианта «перекрываются» и внутри данных наблюдаются с эффектом интерференции, из-за чего традиционные методы анализа зачастую теряют точность и не могут достаточно эффективно разделить сигнал и фон. Аишик Гош столкнулся с этим вызовом в 2017 году, когда ему поручили улучшить методы выделения именно этого пути — с преобразованием двух W-бозонов в Хиггса и его последующим распадом. Однако со временем он понял, что простое обучение моделей для разделения сигналов и фона не даёт удовлетворительных результатов, поскольку интерференция приводит к эффектам взаимного подавления вероятностей, а не только их суммирования.

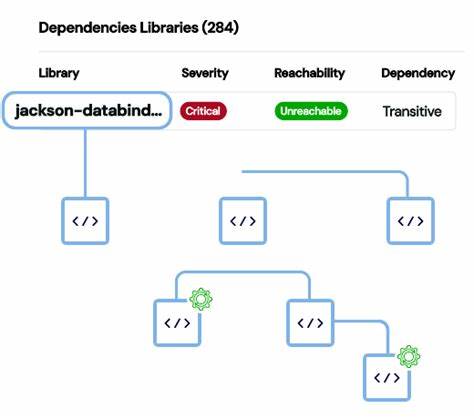

Таким образом, традиционные алгоритмы машинного обучения, успешно классифицирующие объекты в образах (например, кошек и собак), здесь бессильны, так как им тяжело учиться на маскирующемся сигнале, который может исчезать и появляться в разных данных. Для решения этой существенной проблемы Гош обратился к так называемому Neural Simulation-Based Inference (NSBI) — современному подходу, который не пытается напрямую классифицировать события, а вместо этого обучается оценивать вероятность наблюдаемых данных при различных гипотезах о параметрах физики, в частности, о времени распада частицы Хиггса. Иными словами, NSBI позволяет сети учиться вычислять отношение правдоподобий, показывающее, насколько более вероятен один набор параметров по сравнению с другим, исходя из реальных и смоделированных экспериментов. Такой метод значительно обходит традиционные методы, поскольку он напрямую взаимодействует с моделями вероятностей, а не с метками классов. Практическая реализация NSBI потребовала очень серьёзной работы и сложной координации.

Гошу пришлось собрать команду из студентов и профессоров нескольких университетов, включая Университет Калифорнии, Университет Массачусетса и другие научные центры. Вместе они разработали и тщательно проверили алгоритмы, согласовав их со всеми стандартами и требованиями коллаборации ATLAS, которая ведёт измерения в ЦЕРН. Для проверки устойчивости метода они не стали применять его на новых, пока экспериментально необработанных данных, а повторили полный анализ с помощью NSBI на старых уже изученных данных, что позволило сравнить и подтвердить улучшения. Результаты такого подхода оказались впечатляющими. Новая методика позволила добиться значительно более точных оценок параметров распада Хиггса, нейтрализуя размывающий эффект интерференции и восстанавливая потерянную статистическую мощность эксперимента.

Благодаря этому, физики смогли поднять планку точности анализа и получить больше информации о взаимодействиях, которые могут указывать на новые сферы за пределами Стандартной модели физики. Важной особенностью является то, что открытие и внедрение NSBI не только повлияло на уже существующие результаты, но и изменило прогнозы экспериментов на ближайшие пятнадцать и более лет. До появления этого подхода ожидалось, что определённые методы позволят достичь заданного уровня точности лишь спустя годы накопления данных. Теперь же исследователи обнаружили, что с новым инструментом нынешние данные уже обеспечивают достижения, которые ранее считались достижимыми лишь в далёкой перспективе. Это заставляет учёных пересматривать и обновлять свои планы, что, по словам участников проекта, является «весёлой проблемой», так как она открывает новые возможности и ускоряет научный прогресс.

Успех проекта Гоша демонстрирует значимость молодых учёных в больших международных коллаборациях и подчёркивает важность рисков и инноваций в современной науке. Несмотря на традиционную структуру и консерватизм таких организаций, свежий взгляд и нестандартные подходы могут существенно повысить эффективность исследования и раскрыть новые горизонты знаний. В то же время этот пример показывает, насколько важно поддерживать долгосрочные проекты и создавать команды, способные успешно внедрять сложные методы машинного обучения в фундаментальную физику. Использование нейронных сетей для анализа данных БАК представляет собой важный шаг в развитии так называемой «физики данных», где высокоточные эксперименты сочетаются с мощными вычислительными методами. Подобные технологии способны максимально полно использовать огромные массивы данных для изучения взаимодействия элементарных частиц, что помогает не только подтвердить существующие теории, но и найти едва заметные признаки новых физических явлений.