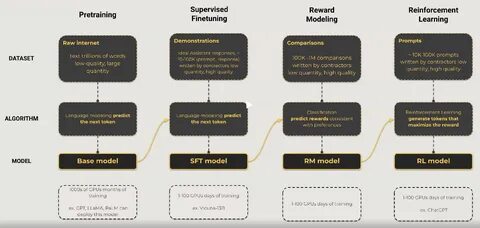

В последние годы большие языковые модели (LLM), такие как GPT, BERT и других, стали фундаментом в области обработки естественного языка. Их способность понимать и генерировать текст на человеческом уровне открывает множество возможностей в интеллектуальных системах. Однако масштаб обучения таких моделей требует огромных вычислительных ресурсов и продвинутых подходов к распределению нагрузки. Именно здесь на помощь приходит распределённое обучение, позволяющее эффективно задействовать многочисленные вычислительные узлы и ускорить процесс тренировок без потери качества. Распределённое обучение подразумевает разделение процесса обучения между несколькими вычислительными устройствами.

С ростом размеров моделей и объемов данных традиционный подход, где обучение происходит на одном сервере или видеокарте, становится неэффективным и невозможным. Использование распределённых систем позволяет обрабатывать большие объемы информации параллельно, сокращая время на обучение и обеспечивая масштабируемость. Существует несколько основных подходов к распределённому обучению больших моделей. Один из них - модельное параллелизм, при котором сама нейронная сеть делится на части, и каждая из них обрабатывается отдельным устройством. Этот метод подходит для очень больших моделей, которые не помещаются в память одного устройства.

Однако модельное параллелизм связан с высокими задержками передачи данных между узлами и требует сложной синхронизации. Другой подход - параллелизм данных, который предполагает разделение обучающего набора данных на части, каждая из которых обрабатывается отдельным узлом с полной копией модели. После обработки данных результаты агрегируются, что позволяет поддерживать согласованность и качество модели. Этот метод проще в реализации, но требует большого объёма памяти на каждом участке и эффективных механизмов для синхронизации градиентов. Гибридные методы сочетают в себе преимущества модельного и датапараллелизма, распределяя как данные, так и части модели по различным устройствам.

Такой подход позволяет более гибко оптимизировать использование ресурсов и масштабировать обучение практически до бесконечности, но сопряжён с повышенной сложностью управления распределённым процессом. Для эффективного распределённого обучения необходимы специальные алгоритмы оптимизации, учитывающие особенности параллельной обработки и синхронизации данных. Методы, такие как асинхронный стохастический градиентный спуск (SGD) и его варианты, позволяют снизить накладные расходы на коммуникацию между устройствами и повысить общую производительность. Кроме того, важное значение имеет инфраструктура, на которой реализуется обучение. Облачные вычисления и специализированные ускорители, например графические процессоры (GPU) и тензорные процессоры (TPU), предоставляют необходимую мощность и возможность масштабирования.

Соответствующее программное обеспечение, как TensorFlow, PyTorch и Horovod, предлагает готовые инструменты для реализации распределённых систем обучения с поддержкой различного уровня параллелизма. Одной из сложностей распределённого обучения является обеспечение согласованности и точного обновления параметров модели при синхронизации данных между узлами. Применение эффективных протоколов синхронизации, компрессии градиентов и адаптивных методов передачи данных помогает минимизировать задержки и потери качества. Безопасность и надёжность также играют важную роль. При распределённом обучении увеличивается риск потери данных, сбоев оборудования и проблем с сетью.

Для решения этих вопросов применяются методы резервного копирования, мониторинга процессов и автоматического восстановления. Перспективы развития технологий распределённого обучения больших языковых моделей открывают новые горизонты в области искусственного интеллекта. С ростом вычислительных мощностей и усовершенствованием алгоритмов становится возможным создавать модели с миллиардами параметров, способные решать сложные задачи с высокой точностью и скоростью. Это способствует развитию приложений в самых различных сферах - от автоматического перевода и создания систем поддержки пользователей до медицинского анализа и научных исследований. Распределённое обучение обеспечивает реализацию потенциала больших языковых моделей, делая технологии искусственного интеллекта более доступными и эффективными.

В итоге, распределённое обучение больших языковых моделей представляет собой неотъемлемую составляющую современного ИИ, позволяющую справляться с вызовами масштабируемости и производительности. Интеграция эффективных методов параллелизма, оптимизации и инфраструктурных решений обеспечивает устойчивое развитие и внедрение передовых технологий в повседневную жизнь и бизнес. .