Современные технологии искусственного интеллекта стремительно развиваются, и одним из наиболее значимых достижений последних лет стали большие языковые модели (LLM), такие как GPT, BERT и другие. Эти модели обладают огромным потенциалом для обработки и генерации естественного языка, однако их функциональность и качество ответов во многом зависят от методов обучения, применяемых в процессе создания и дообучения моделей. Одним из наиболее перспективных подходов является подкрепляющее обучение (Reinforcement Learning, RL), которое приобретает особое значение именно в контексте больших языковых моделей. Подкрепляющее обучение представляет собой тип машинного обучения, где агент получает обратную связь в виде наград за свои действия и стремится максимизировать суммарную награду через последовательность принятых решений. В отношении LLM RL помогает улучшать поведение модели, позволяя ей лучше понимать контекст, правильно реагировать на запросы пользователей и снижать вероятность ошибок.

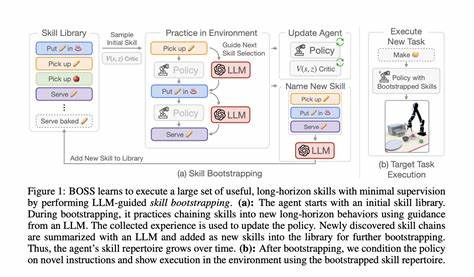

Большие языковые модели традиционно обучаются на огромных объемах текстовых данных с использованием методов обучения с учителем, где цель минимизировать ошибку в предсказаниях. Однако этот подход имеет ограничения, так как не всегда гарантирует оптимальные ответы в реальных условиях общения с пользователем. В отличие от этого, RL позволяет модели самостоятельно учиться на основе обратной связи, которая может быть получена из различных источников, таких как отзывы пользователей, оценки корректности ответов экспертов или встроенные метрики качества. По сути, подкрепляющее обучение стимулирует LLM вырабатывать стратегии генерации текста, которые соответствуют заданным критериям качества и полезности. Одним из ключевых преимуществ RL для LLM является возможность динамического улучшения работы модели на основе интеракций в реальном времени.

Вместо того чтобы полагаться исключительно на заранее подготовленные датасеты, модель может адаптироваться под конкретные задачи, контексты и предпочтения пользователей, что значительно повышает ее практическую ценность. Такой подход особенно важен в ситуациях, когда важно не только корректно трактовать содержание, но и учитывать широкий спектр факторов, включая эмоции, интонации, культурные особенности и этические нормы. Без RL модели могут показывать ограниченный уровень гибкости, что сказывается на качестве диалога и пользовательском опыте. Another crucial aspect where reinforcement learning demonstrates its importance is in fine-tuning language models to mitigate undesired biases and harmful outputs. These models trained on large-scale datasets inevitably absorb biases inherent in the training data.

By leveraging reward signals carefully designed to penalize undesirable behavior and encourage fairness and safety, RL helps in guiding the model towards producing responsible and balanced content. This not only improves the social acceptability of outputs but also addresses ethical concerns central to AI deployments today. Furthermore, reinforcement learning facilitates exploration and experimentation in language generation, enabling models to discover novel expressions, more coherent narratives, and contextually appropriate answers. This creative aspect is difficult to achieve by purely supervised training since RL allows the model to evaluate multiple alternative responses and select the ones that maximize the expected rewards based on specific goals. This ability significantly enhances the versatility and innovation capacity of LLMs, expanding their scope of applications.

Важным направлением применения подкрепляющего обучения является настройка моделей с участием человеческой обратной связи (Human Feedback). Такой подход позволяет учитывать экспертные оценки и предпочтения конечных пользователей для более персонализированной и эффективной генерации текста. В комбинации с автоматизированными системами мониторинга и анализа качества выходных данных RL обеспечивает непрерывное совершенствование модели, что особенно актуально для сервисов с высокими требованиями к точности и надежности. Подведение итогов показывает, что подкрепляющее обучение является ключевым инструментом для повышения интеллектуальных возможностей больших языковых моделей. Оно обеспечивает адаптивность, устойчивость к ошибкам, этичность и творческий потенциал, что делает LLM более полезными и безопасными в разнообразных сферах применения.

По мере развития искусственного интеллекта роль RL только возрастает, способствуя созданию новых стандартов качества и эффективности в области обработки естественного языка. Таким образом, подкрепляющее обучение становится неотъемлемой частью современного подхода к разработке и усовершенствованию больших языковых моделей, открывая новые горизонты для их применения в бизнесе, образовании, здравоохранении и многих других сферах.