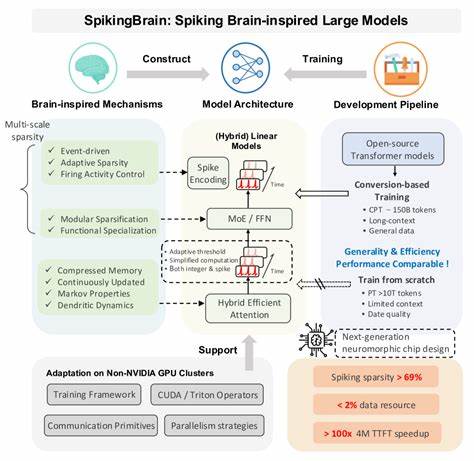

Современные языковые модели стремительно развиваются, становясь всё более крупными и мощными, однако их эффективность часто ограничивается техническими и аппаратными барьерами. Традиционные трансформерные модели при работе с длинными последовательностями сталкиваются со значительным ростом вычислений, а использование оборудования от ведущих производителей, таких как NVIDIA, всегда было доминирующим, но не единственным вариантом. Проект SpikingBrain предлагает свежий взгляд на архитектуру крупных языковых моделей, опираясь на принципы работы живого мозга и внедряя спайковые нейроны, что помогает преодолеть существующие ограничения и открыть новые горизонты в области искусственного интеллекта. SpikingBrain - это семейство моделей, которые разрабатываются с учётом трёх ключевых направлений: архитектурные инновации, алгоритмические оптимизации и системные инженерные решения. Особое внимание уделяется созданию эффективных способов обучения и инференса, которые могут работать на нестандартных GPU-платформах MetaX, что демонстрирует возможность масштабирования вне экосистемы NVIDIA.

Главной особенностью SpikingBrain является использование адаптивных спайковых нейронов в сочетании с линейными и гибридно-линейными архитектурами внимания. Это радикально меняет подход к вычислительным затратам при обработке длинных контекстов, позволяя значительно сокращать время отклика и требования к памяти. Традиционные трансформеры растут в вычислениях квадратично с увеличением длины последовательности, а их системные ресурсы при инференсе увеличиваются линейно, что ограничивает способность эффективной работы с очень длинными текстами. SpikingBrain устраняет эти проблемы, используя события нейронной активности и частично постоянное потребление памяти при работе с несколькими миллионами токенов. Одним из ярких достижений стало создание двух моделей: SpikingBrain-7B и SpikingBrain-76B.

Первая представляет собой линейную модель с 7 миллиардами параметров, вторая - гибридную линейную модель с функцией экспертов (Mixture of Experts) и 76 миллиардами параметров. Оба варианта демонстрируют стабильность обучения на сотнях GPU MetaX, что свидетельствует о продуманной системной архитектуре и программных решениях, оптимизированных под эту аппаратную платформу. Обучение данных моделей потребовало около 150 миллиардов токенов, что сравнительно мало для масштабных современных языковых моделей, что указывает на эффективную конверсию и методики тренировки. Дополнительное преимущество заключается в значительном улучшении времени отклика: SpikingBrain-7B показывает ускорение более чем в 100 раз при генерации первого токена для последовательностей длиной 4 миллиона токенов. Такая производительность открывает новые возможности для приложений с экстремально длинным контекстом, таких как анализ длительных документов, научных статей или больших объёмов кода.

Инновационный подход к обучению связан с использованием конверсионных методик, позволяющих переходить от спайковых нейронов к классическим параметрам трансформерных моделей, сохраняя при этом эффективность и точность. Специально разработанные фреймворки и библиотека операторов совершенствуют процесс тренировки и вывода, адаптируясь к аппаратным особенностям MetaX и позволяя реализовать сложные параллелизмы и масштабируемость. Значительный эффект даёт и высокая разреженность активности нейронов - 69,15%, что снижает энергетические затраты и приближает вычислительный процесс к биологическим реалиям. Такой низкий уровень активности позволяет создавать энергосберегающие решения, которые крайне важны для будущего интеллектуальных систем, особенно в условиях ограниченных аппаратных ресурсов. Спайковые нейронные сети давно привлекают внимание исследователей за счёт своей способности эффективно моделировать время и события, что даёт преимущества в обработке последовательностей и временных данных.

SpikingBrain удачно реализует эти идеи на практике, показывая, что биоинспирированные подходы способны конкурировать и превосходить классические архитектуры в задачах масштабного обучения языка. Кроме того, работа SpikingBrain способствует диверсификации аппаратных платформ для ИИ, что уменьшает зависимость от одного производителя и стимулирует развитие более открытых и адаптивных систем. Это важный шаг к созданию более устойчивой и разнообразной экосистемы искусственного интеллекта. Одним из перспективных направлений, открывающихся благодаря SpikingBrain, является улучшение способности моделей интегрировать знания из длинных контекстов и обеспечивать связное, осмысленное понимание контента при минимальных затратам времени и энергии. Также можно ожидать использования подобных нейросетей в робототехнике, вычислительных системах с низким энергопотреблением и других приложениях, где критичны одновременная эффективность и масштабируемость.

Суммируя, SpikingBrain представляет собой смелый и успешный эксперимент в области больших языковых моделей, который привносит концепции биологии и системного инженерного мастерства в решение задач машинного обучения. Проект не только поднимает планку технических возможностей, но и задаёт направление для будущих разработок, ориентированных на устойчивость, эффективность и универсальность. В эпоху, когда искусственный интеллект стремится приблизиться к познанию и мышлению человека, подобные инициативы выступают катализаторами новых открытий и преобразований в области науки и техники. .