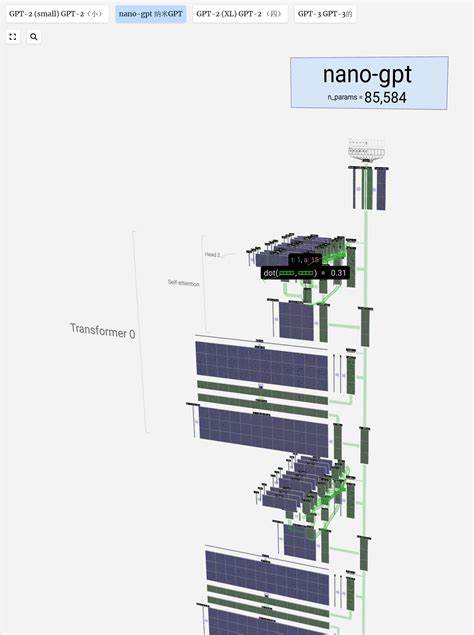

В современном мире искусственного интеллекта и машинного обучения модели на основе архитектуры GPT занимают одно из ключевых мест. Их способность генерировать текст, анализировать большие объемы данных и решать разнообразные задачи привлекает внимание как исследователей, так и практиков. NanoGPT - это репозиторий, разработанный Андреем Карпати, который направлен на упрощение и ускорение процесса обучения и дообучения моделей GPT среднего класса. Его ключевая концепция - сделать процесс максимально простым, понятным и доступным при сохранении эффективности. NanoGPT является переписыванием minGPT с приоритетом практической пользы и минимализма кода.

Репозиторий оптимизирован для запуска на одной GPU, что значительно снижает системные требования по сравнению с масштабными проектами вроде GPT-3. Одним из основных преимуществ NanoGPT является возможность запуска полного цикла обучения GPT-2 модели с 124 миллионами параметров менее чем за четыре дня на одном сервере с 8 графическими процессорами A100 по 40 ГБ каждый. Это делает его привлекательным выбором для исследователей и энтузиастов, у которых нет доступа к огромным вычислительным ресурсам. Архитектура репозитория проста. Основной код состоит из нескольких файлов, ключевыми из которых являются train.

py, отвечающий за обучение, и model.py, который содержит определение модели GPT. Общий размер этих файлов примерно по 300 строк кода, что способствует быстрой адаптации под свои нужды, быстрой настройке или добавлению новых функций. Важная особенность - NanoGPT умеет загружать предварительно обученные веса GPT-2, выпущенные OpenAI, с возможностью последующего тонкого дообучения на собственных данных. Это экономит значительные вычислительные ресурсы и время, позволяя получать качественные результаты даже на небольших наборах данных.

Установка зависимостей не требует сложных манипуляций. Необходимые библиотеки включают PyTorch, numpy, transformers и datasets от Hugging Face, библиотеку tiktoken для быстрой обработки BPE токенизации и утилиты вроде tqdm и wandb для удобного логгирования и отслеживания прогресса. Для новичков доступен простой путь старта: при загрузке маленького текстового датасета, к примеру, трудов Шекспира, можно быстро подготовить данные и обучить базовую GPT-модель на символах. Такой эксперимент занимает всего несколько минут при запуске на современной GPU и позволяет наблюдать, как язык моделируется на лету. Для пользователей с минимальными вычислительными ресурсами доступен упрощенный режим обучения на CPU или на новых Apple MPS устройствах, что открывает дверь для сообществ с ограниченной технической базой.

Для более серьезных профессионалов NanoGPT предлагает возможность подготовки и обучения на больших и сложных датасетах, таких как OpenWebText - открытая реализация закрытого датасета WebText, который использовался OpenAI для тренировки GPT-2. В процессе подготовки данные токенизируются и сохраняются в бинарном формате, что оптимизирует доступ к ним в процессе обучения. Возможности масштабирования никак не ограничены и позволяют запускать обучение как на одном GPU, так и в распределенном режиме с DDP (Distributed Data Parallel) на нескольких узлах с синхронизацией. Благодаря этому можно полноценно воспроизвести результаты GPT-2 124М, обеспечив качество с валидационной потерей около 2.85, что сопоставимо с оригиналом, несмотря на доменный разрыв между закрытым и открытым датасетами.

Для тех, кто заинтересован в специализированных решениях, NanoGPT предоставляет налаженную схему для дообучения предобученных моделей на новых данных. Ярким примером является дообучение на тексте Шекспира с использованием BPE токенизации - это позволяет быстро адаптировать языковую модель для генерации текстов, близких к выбранному стилю. Благодаря гибкости конфигураций можно вести эксперименты с различными гиперпараметрами: размером моделей, числом слоев, настройками размера контекста, скоростью обучения и регуляризацией. При этом checkpoints - сохранённые состояния модели - регулярно записываются в указанную директорию, облегчая контроль и возврат к лучшим результатам. Для вывода текста из обученной модели доступен скрипт sample.

py. Он позволяет сгенерировать образцы текста на основе начального промпта, что помогает оценить качество модели и ее способность к генерации. Доступна возможность выбрать предобученную модель GPT-2 различных размеров либо модели, изготовленные самостоятельно с помощью NanoGPT. Эта функция важна для формирования пользовательских цепочек генерации, чат-ботов и различных творческих приложений. Репозиторий содержит в себе также набор вспомогательных инструментов.

Например, bench.py служит для оценки производительности и проведения бенчмарков тренировочного цикла в изолированном режиме. Это позволяет выявлять узкие места и оптимизировать работу на конкретном железе. Кроме того, два ноутбука с экспериментами по масштабированию трансформеров объясняют, каким образом изменение параметров влияет на качество обучения и производительность, а также служат учебным материалом для более глубоко заинтересованных пользователей. Разработчики активно работают над репозиторием, планируя добавление новых возможностей вроде Full Sharded Data Parallel (FSDP), улучшенной системы логирования, а также расширенного мониторинга состояния нейросети во время обучения.

Также запланированы эксперименты с разными видами позиционных эмбеддингов по типу rotary embedding и alibi, что будет способствовать улучшению контекстного восприятия модели. При запуске NanoGPT рекомендуется применять PyTorch версии 2.0 и выше с включенной функцией torch.compile, которая значительно ускоряет обучение за счёт применения компиляции на лету. При этом существуют обходные варианты для платформ, где эта технология пока недоступна, например, Windows.

Открытая архитектура NanoGPT и читаемый код делают его отличной базой для образовательных целей. Он подходит для изучения внутреннего устройства GPT-моделей, проведения простых экспериментов с языковым моделированием и развертывания собственных прототипов. К тому же NanoGPT, будучи полностью open-source проектом, активно развивается, а сообщество вокруг него растёт. Он позволяет глубже понять принципы работы трансформеров, экспериментировать с архитектурой и быстро выстраивать рабочие решения для обработки естественного языка. В итоге NanoGPT представляет собой мощный и в то же время доступный инструмент для всех, кто стремится работать с языковыми моделями GPT.

Он отлично подходит для обучения с нуля, дообучения предобученных моделей и быстрого прототипирования систем генерации текста при невысоких аппаратных требованиях. For тех, кто хочет добиться впечатляющих результатов без необходимости погружения в сложные технические детали и инфраструктуру, NanoGPT становится одним из лучших выборов на рынке открытых решений. .