Последние годы IT-индустрия переживает стремительное развитие, и вместе с ней меняется и подход к разработке программного обеспечения. Появляются новые технологии, инструменты, парадигмы, которые призваны облегчить работу и повысить эффективность. Однако, вместе с этими новшествами иногда возникают проблемы, особенно когда в команде работают молодые специалисты, склонные переусложнять архитектуру проектов и процессы, что нередко вызывает раздражение у более опытных коллег. Одним из ярких примеров такого разочарования стала ситуация, связанная с использованием серверных функций AWS Lambda при обработке асинхронных запросов к базе данных. В одной из компаний опытный программист предложил использовать в серверном процессе корутины для асинхронного выполнения запросов без блокировки обработчика.

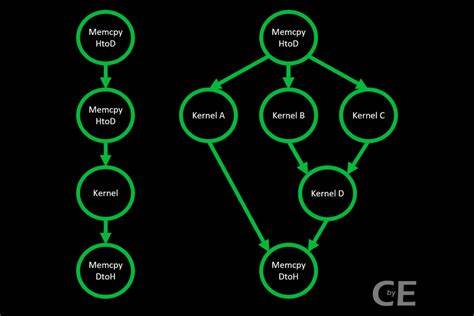

Это классический подход, который экономит ресурсы, снижает задержки и упрощает архитектуру, позволяя современным серверам одновременно обрабатывать множество асинхронных задач. Тем не менее, его молодые коллеги предложили развернуть AWS Lambda через SNS, чтобы именно через серверless-функцию ожидать ответа от базы данных. Они настаивали, что стоимость AWS Lambda настолько низкая, что можно не беспокоиться об эффективности. Более того, для этого предлагалась целая новая репозитория с собственной инфраструктурой деплоя, что радикально усложняло процесс внесения изменений. На первый взгляд такой подход может выглядеть привлекательным: масштабируемость, модульность, следование современной модульной архитектуре и микросервисам.

Но при более внимательном рассмотрении оказывается, что в случае, когда сервер уже существует и способен выполнять асинхронные запросы, добавление нового слоя — это лишняя трата ресурсов. Один серверный процесс, который просто ждет ответа от базы данных, оказывается гораздо более эффективным и менее затратным, чем запускаемая серверless-функция, которая в основном только удерживает CPU, ожидая выполнения запроса. Это не просто технический спор, а отражение более глубокой проблемы восприятия архитектуры и ее назначения среди молодых специалистов. В погоне за модными решениями и микрооптимизациями они порой пытаются использовать инфраструктуру там, где это не нужно, забывая о простых и элегантных способах решения задач. Они воспринимают сложность как признак профессионализма, а многослойная архитектура словно прописана в инструкциях к хорошему коду.

С точки зрения опытного инженера подобное поведение напоминает «перегрузку» — когда функция или архитектурный блок решают одну единственную задачу, но при этом задействуют целую вычислительную машину. Это эквивалентно тому, чтобы нанять несколько человек, чтобы дождаться возможности одной перезвонить по телефону, вместо того, чтобы сделать это самостоятельно. Также это ведет к увеличению затрат, усложнению системы и потенциальным проблемам с поддержкой и мониторингом компонентов. Почему так происходит? Часто причина — отсутствие глубокого понимания особенностей работы инфраструктуры и механики распределённых систем. Молодые разработчики могут не знать реального объема ресурсов, которые требуются для запуска и поддержания серверных функций.

Отсюда возникает вера в то, что «облако — это дешево», и значит можно масштабировать бесконечно, не задумываясь об эффективном использовании инфраструктуры. При этом подчеркивают преимущества автоматического масштабирования и разделения ответственности между сервисами. Другой аспект — недооценка возможностей современных серверных платформ. Сегодня даже среднестатистический сервер на базе Linux способен эффективно обрабатывать тысячи одновременных соединений и справляться с большим количеством асинхронных операций. Современные языки программирования широко поддерживают асинхронность — в Go, Python, Node.

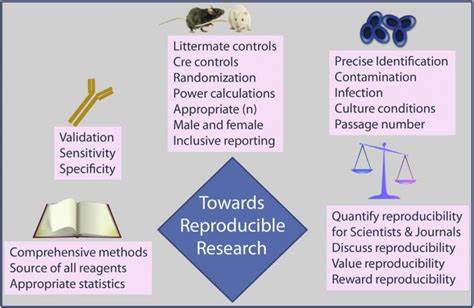

js и других есть механизмы для полноценного использования ресурсов без излишних накладных расходов. Наконец, любовь к микросервисам и стремление к «правильной архитектуре» зачастую перебарщивают. Создание новой репозитории, развертывание отдельной инфраструктуры для задачи, которую можно решить напрямую внутри существующего сервера — все это влияет не только на скорость разработки, но и на поддерживаемость проекта. Чем больше инфраструктурных компонентов, тем выше риск возникновения ошибок на стыках, сложнее устроен мониторинг и тестирование, а процесс деплоя усложняется и становится медленнее. Что же делать, чтобы избежать таких конфликтов и повысить качество совместной работы? Во-первых, важна культура обмена знаниями и активное наставничество.

Опытным разработчикам надо не бояться объяснять и просвещать, а молодым специалистам важно открыто воспринимать критику и учиться разбираться в экономике вычислительных ресурсов. Во-вторых, планирование архитектуры должно исходить из реальных требований и ресурсов. Не нужно выстраивать масштабируемое решение на базе AWS Lambda, если проект небольшой и сервер уже справляется с нагрузкой. Следует подходить к архитектуре прагматично — выбрать инструменты и схемы, которые дают оптимальный баланс между производительностью, поддерживаемостью и стоимостью. Кроме того, стоит внедрять практики совместного код-ревью, где обсуждаются не только синтаксис и стиль кода, но и архитектурные решения.

Это поможет избежать излишней сложности и повысит общий профессиональный уровень команды. Нельзя забывать и про документирование инфраструктурных решений: почему было выбрано именно такое решение, какие компромиссы учтены. Это снижает внутригрупповое напряжение и помогает новым членам команды быстрее адаптироваться. Также немаловажно внедрить систему автоматического тестирования и мониторинга. Чем прозрачнее процессы, тем проще выявлять и исправлять узкие места, распределять нагрузку и принимать решения о масштабировании.

Еще один полезный подход — демонстрировать на практике и цифрах преимущества тех или иных архитектурных решений. Например, сделать простой бенчмарк корутин на сервере против вызовов AWS Lambda и показать разницу в задержках, стоимости и сложности поддержки. Конкретные данные часто оказываются убедительнее общих тезисов. Наконец, важно помнить, что в современном мире нет одного универсально правильного решения. У каждой компании и проекта своя инфраструктура, нагрузка и приоритеты.