В современном мире искусственный интеллект стремительно развивается, и крупнейшие компании ищут способы максимально эффективно использовать его потенциал. Одним из ключевых направлений является быстрое развертывание и масштабирование инференса больших языковых моделей (LLM), что становится возможным благодаря облачным инфраструктурам и специализированным аппаратным решениям. В этом контексте AWS Marketplace предлагает уникальный продукт — Cerebras Inference Cloud, который кардинально меняет представление о скорости и удобстве инференса ИИ-моделей. Cerebras Inference Cloud — это облачная услуга SaaS, доступная на AWS Marketplace, разработанная компанией Cerebras Systems Inc. Она позволяет интегрировать современные открытые языковые модели, такие как Llama, Qwen, DeepSeek, Mistral и другие, в свои приложения буквально за считанные секунды и с максимально низкой задержкой.

Главным технологическим ядром решения является инновационный ИИ-ускоритель Wafer-Scale Engine (WSE), который обеспечивает невероятно высокую пропускную способность и скорость обработки данных. Одной из главных проблем при использовании больших языковых моделей является задержка ответа и огромные вычислительные ресурсы, необходимые для их запуска. Традиционно для работы таких моделей используются графические процессоры (GPU), которые требуют значительного времени на настройку и обладают ограничениями в масштабируемости. Cerebras Inference Cloud решает эти проблемы благодаря гораздо более высокой производительности — сервис работает в 70 раз быстрее классических GPU. Такой уровень скорости позволяет обрабатывать более 2500 токенов в секунду, что открывает новые возможности для применения ИИ в реальном времени, включая многоэтапное логическое рассуждение и работу интеллектуальных агентов.

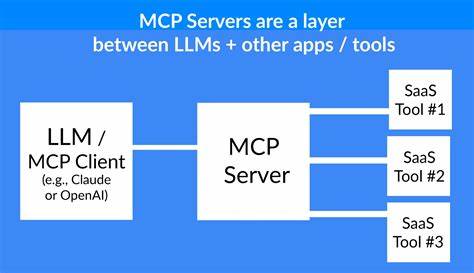

Для разработчиков и компаний, стремящихся интегрировать ИИ в свои продукты, решение от Cerebras предлагает простую и быструю реализацию: достаточно получить API-ключ и начать использовать модель через полностью совместимый с OpenAI API интерфейс. Это избавляет от необходимости долгой и сложной настройки инфраструктуры, позволяя сосредоточиться на создании инновационных решений и улучшении пользовательского опыта. Кроме того, Cerebras Inference Cloud доступен как сервис с гибкой системой ценообразования, позволяющей подобрать условия оплаты в зависимости от потребностей бизнеса. Пользователи могут выбрать различные тарифные планы, включая разработческую категорию, с оплатой за определённый объём использования в течение месяца. Особенностью является то, что дополнительная стоимость AWS-инфраструктуры и сетевых ресурсов при этом оплачивается отдельно и может быть рассчитана с помощью AWS Pricing Calculator, что обеспечивает прозрачность расходов.

Стоит отметить, что данный сервис не размещается непосредственно на инфраструктуре AWS, что подразумевает использование специализированного оборудования компании Cerebras, оптимизированного для высоконагруженных вычислительных задач ИИ. Такое решение позволяет удовлетворять самые жёсткие требования по скорости и качеству вывода моделей, в то время как пользователи получают привычное облачное удобство и масштабируемость. Важным аспектом является поддержка множества моделей с открытым исходным кодом. Это позволяет выбрать наиболее подходящую модель под конкретные задачи, будь то генерация текстов, анализ данных, создание интеллектуальных агентов или другие кейсы в области финансов, здравоохранения, образования и многих других индустрий. Cerebras Inference Cloud таким образом становится универсальным инструментом, способным улучшить бизнес-процессы и ускорить инновации.

Для максимальной безопасности и качественной поддержки сервис предлагает круглосуточную техническую помощь. Связаться со специалистами Cerebras можно через email или телефон, что особенно важно для корпоративных клиентов, нуждающихся в быстром решении любых возникающих вопросов. Эксперты отмечают, что использование подобных облачных решений соответствует современным трендам цифровой трансформации, предоставляя компаниям возможность быстро адаптироваться к меняющимся условиям рынка и предпочтениям клиентов. Благодаря сочетанию высокой скорости обработки, простоты интеграции и устойчивой инфраструктуры, Cerebras Inference Cloud становится одним из ведущих продуктов в области генеративного ИИ и машинного обучения. Подводя итог, стоит выделить основные преимущества Cerebras Inference Cloud на AWS Marketplace: мгновенный доступ к передовым открытым языковым моделям, рекордно высокая скорость и пропускная способность, простота использования через знакомый OpenAI-совместимый API, гибкое ценообразование, возможность использования в различных индустриях и надежная техническая поддержка.