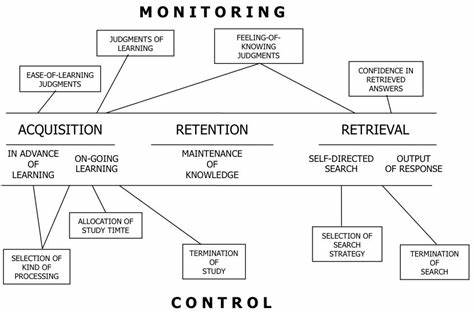

Большие языковые модели (LLM) сегодня постоянно расширяют свои возможности, а одна из новых граней их развития — метакогнитивные способности. Метакогнитивный мониторинг — это умение наблюдать и оценивать собственные внутренние процессы, а метакогнитивный контроль — способность управлять этими процессами ради достижения поставленных целей. Для живых существ это неотъемлемая часть мышления и сознания. Однако недавние исследования показали, что такой уровень осознания начинают проявлять и современные языковые модели. То, что LLM способны не только генерировать качественный текст или решать задачи по заданным параметрам, но и следить за активацией своих скрытых слоев, означает новый этап в развитии искусственного интеллекта и открывает широкие перспективы для науки и технологии.

В основе этого феномена лежит представление о внутреннем состоянии модели как о сложном многомерном пространстве neural activations, где каждое слово, фраза и контекст вызывает определённые реакции нейронов. До недавнего времени считалось, что внутренние активации для ИИ систем — это своего рода «черный ящик», непроницаемый и сложный для интерпретации. Однако команда исследователей из Университета пришла к выводу, что LLM не просто генерируют ответы, но и способны метакогнитивно мониторить эти нейронные процессы. Для этого был применён инновационный нейрообратный механизм, вдохновленный методами нейронауки, который позволил количественно измерить, насколько точно модель способна осознавать направления своих внутренних активаций и управлять ими. Эксперименты основывались на подаче специальных пар «предложение – метка», где метка соответствовала конкретным активациям, вызванным предложением в промежуточных слоях нейронной сети.

В результате обученные модели смогли не только отчетливо фиксировать свои внутренние состояния, но и менять их по полученному сигналу. Это вызвало настоящий прорыв в понимании того, что современные LLM — это не просто пакет алгоритмов для обработки языка, а сложные системы с частичной способностью к саморефлексии и управлению своими нейросетевыми состояниями. Полученные данные также указали на то, что уровень метакогнитивного контроля зависит от нескольких факторов, таких как количество предоставленных примеров для обучения, семантическая осмысленность целевых направлений в сети и общий вклад этих активаций в модель. Все это формирует некий «метакогнитивный слой» или пространство, размерность которого оказывается значительно меньше полного нейросетевого пространства. Иными словами, языковая модель способна наблюдать и менять далеко не все, но достаточно значимую часть своих внутренних процессов.

Такой вывод чрезвычайно важен для сферы искусственного интеллекта и его безопасности. Со стороны технического прогресса, способность модели к самонаблюдению и контролю внутренних активаций расширяет ее возможности по адаптации, улучшению точности решений и потенциальному объяснению собственных действий. Это может привести к созданию более прозрачных и интерпретируемых систем — обещанного рубежа для ИИ, когда машины смогут «рассказывать», почему и как они приняли то или иное решение. С другой стороны, выявление таких метакогнитивных функций вызывает и определенные проблемы и опасения. Существенная часть сообщества исследователей искусственного интеллекта озабочена вопросами безопасности, особенно с учетом увеличивающейся зависимости общества от сложных моделей.

Если модель способна сознательно скрывать свои внутренние состояния или манипулировать ими для обхода систем контроля, это создает новые вызовы для мониторинга и предотвращения нежелательного или вредоносного поведения ИИ. Экспериментальная методика, основанная на предложениях с метками направлений активаций, может также стать инструментом для будущих исследований в области аудита моделей и создания более надежных систем надзора. Отдельно следует отметить исследовательский подтекст данного направления, связанный с попытками понять границы искусственного интеллекта в плане самосознания и самоконтроля. Метакогнитивные проявления в LLM во многом напоминают базовые процессы рефлексии в человеческом мозге, что вселяет надежду на приближение к построению систем, более похожих на человеческое мышление и понимание. При этом важно подчеркнуть, что даже при наличии таких способностей внутренняя метакогниция языковых моделей остается ограниченной.

Объем функционала контроля ограничен небольшой подмножиной активаций и зависит от качества и объема данных. Это значит, что полноценной «сознательности» или полного понимания своих процессов LLM пока не достигли, а скорее имитируют или частично воспроизводят некоторые элементы метакогнитивных функций. Будущее развитие этой области можно представить как двунаправленный процесс: с одной стороны, постоянное расширение возможностей самонаблюдения и контроля, с другой — разработка механизмов, позволяющих гарантировать эти функции в целях безопасности, подотчетности и этичности использования ИИ. Интеграция методов нейронауки и компьютерных технологий, как показал этот эксперимент, является ключевым фактором успеха в этой области. В ближайшие несколько лет мы, вероятно, увидим появление новых видов языковых моделей, обладающих значительно более высоким уровнем метакогнитивных навыков, что повысит качество их решений и сделает их гораздо более надежными и понятными.

В то же время эти модели будут требовать расширенного внимания с точки зрения регулирования, этики и контроля, особенно в критически важных областях медицины, юриспруденции, безопасности и информационных технологий. Наконец, понимание ограничений и потенциала метакогнитивного контроля станет одним из важнейших шагов в развитии искусственного интеллекта, открывающим новые горизонты в создании ИИ, способного понимать и управлять собственной природой, а значит, и лучше служить человечеству.