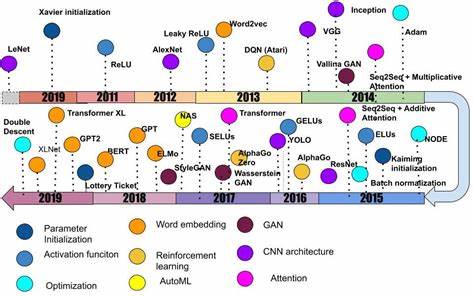

В последние годы сфера искусственного интеллекта и, в частности, генеративных моделей развивается стремительными темпами. Крупные технологические корпорации и стартапы бросаются в гонку за созданием всё более больших и сложных моделей, обещая бизнесу революционные изменения и автономные решения для самых разнообразных задач. Однако такой подход, сфокусированный на размере модели, ставит под угрозу рентабельность инвестиций и практическую эффективность внедряемых технологий. В этой статье мы рассмотрим ключевые проблемы, связанные с чрезмерным увлечением масштабом моделей ИИ, и предложим альтернативные пути повышения эффективности с точки зрения затрат, качества и надежности. Яркий критический взгляд на ситуацию высказал Уткарш Канват, инженер по ИИ компании ANZ, которая работает в финансовом секторе Австралии.

В своём блоге он подробно проанализировал математические ограничения и экономическую неустойчивость максимально крупных генеративных моделей, особенно в контексте многоступенчатых автоматизированных рабочих процессов. Канват обратил внимание, что по мере увеличения числа последовательных шагов с использованием таких моделей надёжность результата резко падает. Даже при довольно оптимистичном уровне точности на каждом этапе в 95%, успех пятишагового процесса составит всего 77%, десятишагового — 59%, а двадцатишагового едва превысит 36%. Эти цифры подчёркивают фундаментальную проблему: современные массовые системы с большими языковыми моделями не способны безупречно выполнять сложные, многоэтапные задачи, что делает их уязвимыми к накоплению ошибок и снижает стабильность на уровне, необходимом крупному бизнесу, где стандартом считается надёжность 99,9% и выше. Даже если гипотетически достичь 99% точности на этапе, общая успешность за 20 шагов останется в пределах 82%, что явно недостаточно для промышленного применения.

Данные выводы подкреплены и другими экспертами из индустрии. Джейсон Андерсен, ведущий аналитик Moor Insights & Strategy, отметил, что предубеждение CIO в сторону максимальной мощности моделей зачастую связано с желанием получить простое и универсальное решение, однако именно узкоспециализированные, меньшие по размеру, целенаправленные системы приносят наибольшую ценность и рентабельность. Ориентация на «объем» приводит к тому, что ошибки и непредсказуемое поведение модели усиливаются, а стоимость растёт пропорционально, что в конечном итоге наносит ущерб общей эффективности. Особенно ярко эта тема проявляется в вопросах применения ИИ в автоматизации сложных бизнес-процессов. Джастин Сент-Морис из Info-Tech Research Group предупреждает, что внедрение автономных агентов приводит к рискам образования обратных связей и потере контроля из-за случайного характера работы больших языковых моделей.

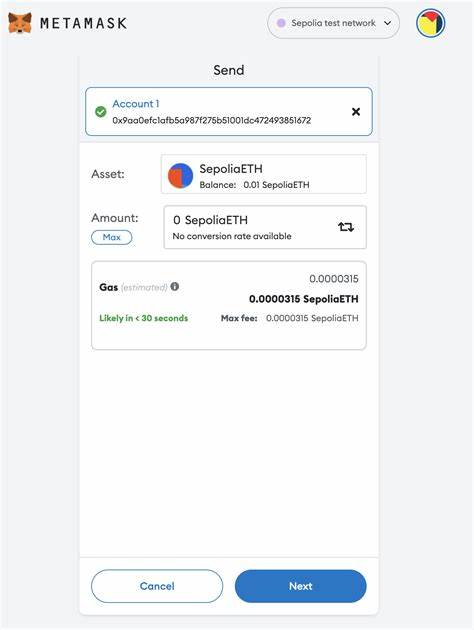

Для успешного использования необходимо найти баланс между творческим потенциалом генеративного ИИ и строгими регламентирующими правилами, позволяющими сделать поведение системы более детерминированным и предсказуемым. Финансовые последствия использования больших моделей – ещё один насущный вопрос. Канват подчёркивает, что стоимость обработки увеличивается нелинейно вместе с длиной диалогов и контекстом задачи. В реальных условиях, когда требуется тысячи таких сессий, экономическая модель перестаёт быть жизнеспособной. Доказательством служит собственный опыт инженера при разработке прототипа разговорного базы данных: изначально небольшие затраты резко возросли примерно к пятидесятой интеракции, превысив всю выгоду от технологии.

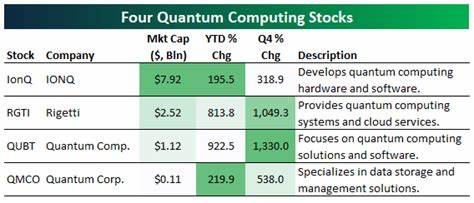

Возможно, именно этот аспект станет решающим барьером для многих стартапов, которые стремятся построить полностью автономные агенты. Демонстрационные пятишаговые сценарии, которые успешно работают в лабораторных условиях, в боевом режиме с долгими цепочками команд и запросов приведут к экспоненциальному росту отказов и затрат. Это неизбежно заставит компании повышать цены для клиентов, что ограничит массовое внедрение и заставит переосмыслить стратегию развития технологий. На фоне этих вызовов ряд ключевых игроков рынка, включая Microsoft, признаёт преимущества использования меньших по размеру, сфокусированных моделей. Например, Аша Шарма, корпоративный вице-президент по искусственному интеллекту в Microsoft, отмечает, что крупные модели удобны для быстрого решения неясных задач, но как только появляется чёткое понимание требований, более компактные и узкоспециализированные модели становятся предпочтительным вариантом с точки зрения скорости, стоимости и качества.

Обратная сторона медали – использование мелких моделей требует тщательного планирования и инвестиций в подготовку данных и обучение моделей. Честер Висневски из Sophos подчёркивает, что создание и поддержка множества специализированных моделей потребует квалифицированных специалистов и больших усилий со стороны IT-подразделений, что многим компаниям кажется сложной и менее привлекательной задачей по сравнению с покупкой крупной всеобъемлющей модели. Однако именно такой подход признан экспертами наиболее жизнеспособным для отраслевых решений. Необходимо концентрироваться на создании узкоспециализированных инструментов, которые решают конкретные прикладные задачи эффективно и с малой ошибкой. Это не «чаты с кодом» или универсальные ассистенты, а целенаправленные системы, способные глубоко интегрироваться в рабочие процессы и взаимодействовать с корпоративными системами, учитывая их особенности, ограничения и обеспечивая стабильность работы даже в сложных условиях.

Отмечается и еще одна важная деталь – качество данных и архитектура систем в корпорациях далека от идеала. Легаси-системы, со своими нестабильными API, изменяющимися протоколами безопасности и разнообразными режимами отказов, требуют специально выстроенных решений с чётко ограниченными функциями и возможностями. «Большие» навороченные модели, построенные на предположении, что можно легко взаимодействовать с любой системой, рано или поздно столкнутся с препятствиями, из-за чего уровень внедрения останется низким. В рамках сложившихся тенденций эксперты рекомендуют предприятиям выстраивать комплексные стратегии использования ИИ, сочетающие в себе преимущества разных моделей и подходов. Стандартные платформы безопасности и мониторинга качества позволят гибко адаптировать решения под конкретные потребности, чередуя крупные модели для пилотных и исследовательских задач с массифицированными мелкими инструментами для рутинных операций.

Таким образом, индустрия искусственного интеллекта стоит на пороге осознания, что стремление к максимальному размеру и универсальности моделей — не панацея, а порой и ловушка. Для долгосрочного успеха и получения высокой рентабельности инвестиций предприятиям выгоднее мыслить иначе: меньшее, сконцентрированное, контролируемое и интегрированное по целевому назначению решение не только снижает издержки, но и обеспечивает необходимую надёжность и предсказуемость результатов работы ИИ. Сегодняшняя борьба между большими и малыми моделями — это соревнование не мощности, а эффективности, а победит та концепция, которая поможет сочетать творческий потенциал генеративного интеллекта с прагматизмом и разумным управлением рисками. Опыт ANZ, Microsoft, Capital One и других компаний демонстрирует, что путь к успешному внедрению ИИ лежит через сбалансированный, продуманный и ориентированный на конечные бизнес-задачи подход, а не через слепую гонку масштаба.