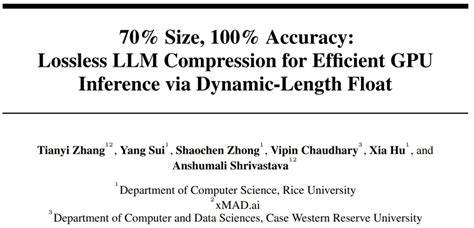

В последние годы большие языковые модели (LLM) стремительно увеличиваются в размерах, что создаёт серьёзные трудности для их эффективного развертывания, особенно в условиях ограниченных вычислительных ресурсов. Рост моделей сопровождается увеличением требований к памяти и вычислительной мощности, что затрудняет использование передового ИИ на привычных устройствах и серверах. Тем не менее, эффект увеличения масштаба моделей зачастую приводит к заметному улучшению качества обработки естественного языка и созданию более точных и осмысленных ответов. На фоне таких проблем наука и индустрия начали искать инновационные решения, направленные на оптимизацию хранения и работы LLM без снижения точности выводов. В этом контексте недавно предложенный метод Dynamic-Length Float, или DFloat11, кардинально меняет подход к сжатию крупных моделей, предлагая безупречную с точки зрения сохранения точности технологию, которая позволяет уменьшить размер модели примерно на 30%, не жертвуя качеством её работы.

Ключевая идея технологии базируется на наблюдении, что существующее кодирование весов моделей, основанное на формате BFloat16, далеко не оптимально с точки зрения информационной энтропии. Согласно данным, веса в данной форме обладают низким уровнем энтропии, что указывает на значительный резерв для более эффективного хранения данных. Dynamic-Length Float применяет методы энтропийного кодирования, позволяя динамически изменять длину хранения данных в зависимости от частоты встречаемости конкретных весов. Такой подход обеспечивает приближение к информационно-оптимальному компрессированию без малейших потерь точности. Особое внимание уделено организации быстрого и эффективного декодирования в процессе вывода модели на графических процессорах.

Для этого разработчики создали специализированное ядро GPU, способное выполнять онлайн-декомпрессию с минимальной задержкой. Оптимизация включает комплекс мер, таких как разделение ресурсоёмких таблиц поиска на компактные и легко размещаемые в быстрой локальной памяти GPU версии, использование двухфазного механизма синхронизации потоков для эффективного координирования чтения и записи и декомпрессию на уровне блоков трансформера, что снижает задержки и повышает пропускную способность. Результаты экспериментов демонстрируют впечатляющую универсальность и надёжность DFloat11: на моделях последнего поколения, включая Llama-3.1, Qwen-2.5 и Gemma-3, сокращение размера моделей составило порядка 30% при абсолютно идентичных бит в бит с оригиналом выходных данных.

Более того, при сравнении с традиционными подходами, когда части модели выгружаются на процессор для экономии памяти, DFloat11 позволяет добиться ускорения вывода текстов от 1,9 до 38,8 раза. Это открывает принципиально новые возможности для работы с масштабными языковыми моделями в рамках ограниченных ресурсов GPU. Одним из наиболее впечатляющих достижений метода является возможность обработки гигантской модели Llama-3.1-405B, занимающей около 810 ГБ, на одной вычислительной базе, включающей всего восемь графических процессоров с 80 ГБ памяти каждый. Благодаря этому повышается практическая доступность и удобство эксплуатации таких масштабных систем в реальных задачах.

Параллельно с сокращением объема памяти пользователи получают значительный прирост максимальной длины контекста, который может поддерживать система, что особенно важно для длительного диалога или анализа больших текстовых массивов. Методика Dynamic-Length Float открывает новые горизонты в области сжатия и оптимизации LLM, позволяя создавать более компактные, но при этом абсолютно точные модели. Это особенно актуально в современных сценариях, где вычислительные ресурсы часто ограничены, а требования к качеству и скорости вывода остаются высокими. Технология приводит к существенным экономиям на инфраструктуре, снижает энергозатраты при работе моделей и расширяет возможности внедрения ИИ в самых разных отраслях — от науки и образования до промышленности и сервиса. При сохранении максимальной точности DFloat11 не предлагает компромиссов между размером, скоростью и качеством, что является значительным шагом вперёд по сравнению с существующими методами квантизации и сжатия, которые зачастую приводят к ухудшению результатов.

Помимо чисто технической стороны, разработка подчёркивает важность глубокого понимания структуры данных в моделях и применения продвинутых методов сжатия, которые адаптируются под реальные характеристики информации. Это совместная заслуга исследовательской группы, объединившей экспертизу в машинном обучении, программировании на уровне GPU и теории информации. Национальные и международные сообщества уже демонстрируют большой интерес к подобным разработкам, что предвещает широкое распространение таких решений в ближайшем будущем. Dynamic-Length Float оказывается не просто полезным инструментом оптимизации, но и важным элементом формирования устойчивой и эффективной экосистемы больших языковых моделей, которые смогут эффективно работать в самых разнообразных условиях. Для любителей и профессионалов индустрии доступность исходного кода и моделей открывает доступ к экспериментам и дальнейшему развитию технологии, что несомненно ускорит процесс внедрения инноваций и расширит возможности пользователей.

В итоге, Dynamic-Length Float задаёт новый стандарт компрессии LLM — одновременно малый размер, максимальная точность и высокая производительность. Для компаний, исследователей и разработчиков это отличная возможность снизить затраты и повысить эффективность при работе с ИИ, что способствует устойчивому росту и прогрессу в области искусственного интеллекта и обработки естественного языка.