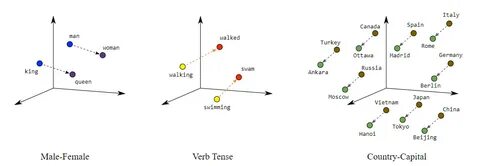

Современные большие языковые модели (LLM) произвели революцию в области обработки естественного языка, предоставив мощные инструменты для перевода, создания текстов, анализа и понимания языковых структур. В основе работы таких моделей лежат высокоразмерные эмбеддинги — векторные представления слов, предложений и концептов, которые содержат в себе богатую информацию о семантических и синтаксических взаимосвязях. Однако высокоразмерность и сложность этих эмбеддингов зачастую затрудняют их анализ и интерпретацию, что создает серьезные препятствия на пути к глубокому пониманию того, как именно модели кодируют знания и лингвистические свойства. Для решения этой задачи исследователи используют топологические методы визуализации и анализа, одним из которых является Explainable Mapper — инновационный фреймворк, позволяющий эффективно картировать и показывать глобальные структуры пространств эмбеддингов с акцентом на объяснимость и верификацию результатов. Explainable Mapper основывается на концепциях Topological Data Analysis (TDA), где ключевым элементом выступает Mapper-граф — графическое представление топологических особенностей данных, в данном случае, эмбеддингов LLM.

В основе Mapper-графа лежат узлы, каждый из которых соответствует топологическому соседству или кластеру эмбеддингов, а также ребра, указывающие на пересечения этих соседств. Такой подход позволяет выявлять структуру данных, выявлять закономерности и расшифровывать, каким образом модель организует языковую информацию в пространстве эмбеддингов. Несмотря на сильные стороны Mapper-графа, человеческий фактор в их интерпретации способен стать серьезным ограничением. Ручной разбор графа требует значительных временных и интеллектуальных затрат, что снижает эффективность исследования и усложняет сопоставление результатов с лингвистическими теориями. Чтобы снизить этот барьер, команда разработчиков Explainable Mapper внедрила систему semi-автоматической аннотации элементов Mapper-графа, предлагая типологию участников анализа: узлы, ребра, пути, компоненты и траектории.

Для каждого из этих аспектов организована тщательная аннотация, подкрепленная современными методами машинного обучения. Важной инновацией является использование двух специализированных агентов, основанных на больших языковых моделях, которые применяют методику возмущений. Эта методика предполагает каскадные изменения входных данных (например, изменение отдельных слов или синтаксических структур) для оценки влияния таких изменений на характеристики эмбеддингов и структуры Mapper-графа. Подобные возмущения охватывают ряд возможных вариантов, что позволяет получить расширенную и устойчивую картину семантических взаимосвязей, а также выявить логические и лингвистические свойства, скрытые в топологических соседствах. Один из агентов отвечает за генерацию объяснений с опорой на наблюдаемые паттерны и взаимосвязи в данных пространствах, а второй выполняет роль верификатора — проверяет стабильность, достоверность и воспроизводимость выдвинутых гипотез и выводов.

Такая синергия взаимодействующих агентов поднимает уровень надежности получаемых знаний и способствует более глубокому выявлению свойств модели. Для практической реализации Explainable Mapper был создан визуальный аналитический интерфейс, в котором исследователи и пользователи могут в интерактивном режиме проводить анализ и аннотирование топологических элементов, просматривать взаимосвязи и исследовать эмбеддинговые структуры. Этот рабочий инструмент значительно облегчает интерпретацию и делает процесс исследования доступным не только экспертам по машинному обучению, но и более широкому кругу специалистов в области лингвистики и когнитивных наук. С помощью Explainable Mapper были проведены комплексные кейс-стадии, включая воспроизведение и углубление предыдущих результатов, связанных с эмбеддингами модели BERT. Анализ показал, что Mapper-графы могут выявлять разнообразные слои языковой архитектуры, отображая такие характеристики, как грамматические функции, синтаксическую структуру и семантические закономерности.

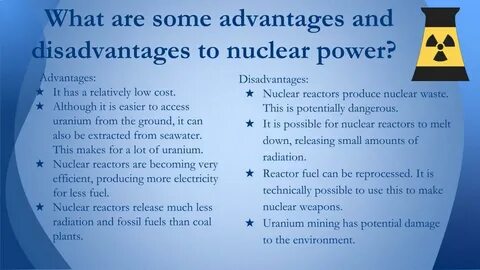

Кроме того, применение методов возмущений позволило не только описать эти свойства, но и проверить их устойчивость при вариациях входных данных. Это открывает новые перспективы для разработки более прозрачных и надежных языковых моделей, особенно в рамках задач, где объяснимость и доверие к алгоритму имеют критическое значение. Текущие достижения в Explainable Mapper свидетельствуют о важности комбинирования методов топологического анализа с современными возможностями больших языковых моделей и подходами к автоматическому объяснению. Этот подход позволяет выйти за рамки простой визуализации данных и перейти к активному взаимодействию с интроспекцией машины, что решительно расширяет горизонты исследований по пониманию поведения нейронных сетей. Перспективы развития включают усиление возможностей интерактивной визуализации, более глубокую интеграцию с разнообразными источниками данных, а также расширение методологий проверки качества и обоснованности выводов в реальных приложениях.

Особое внимание уделяется возможному применению Explainable Mapper в области образования, разработки систем поддержки принятия решений и анализа текстов в научных и коммерческих задачах. В целом Explainable Mapper представляет собой инновационный инструмент, который способствует синтезу знаний из сложных пространств языковых моделей в удобную для восприятия форму, расширяет границы исследований в области интерпретируемого машинного обучения и активно способствует созданию новых методов и практик прозрачной работы с искусственным интеллектом. Он основан на принципах ясности, проверяемости и эффективности, что позволяет заниматься глубоким исследованием лингвистических и семантических особенностей моделей нового поколения, вводя новые стандарты открытости и понимания в быстро развивающемся мире языкового искусственного интеллекта.