В современном мире искусственный интеллект и особенно большие языковые модели становятся все более неотъемлемой частью цифровых продуктов и сервисов. С каждым днем растет количество программного обеспечения, использующего AI-библиотеки и модели, причем особенно распространённым является применение платформы Hugging Face и ее трансформерных моделей. Однако, несмотря на все преимущества, связанные с такой интеграцией, существует серьезная проблема безопасности, которая охватывает большую часть открытых репозиториев с AI-кодом. Речь идет о широко распространенной уязвимости Silent Injection — невидимой атаке, подрывающей целостность цепочки поставок AI-программного обеспечения. Эта проблема является результатом фундаментальной ошибки в управлении зависимостями, что создает условия для тихой замены доверенных моделей на вредоносные аналоги без какого-либо явного сигнала об опасности.

Глубокий анализ показал, что около 99% исследованных AI-проектов, работающих с библиотеками Hugging Face Transformers, содержат конфигурации, подверженные Silent Injection. Суть уязвимости связана с отсутствием жесткой фиксации версий моделей и соответствующих токенизаторов, а также наборов данных и ключевых файлов. Вместо подключения к конкретным зафиксированным версиям, такие проекты зачастую обращаются к последним изменениям в ветках главного репозитория, что позволяет злоумышленникам, в случае компрометации аккаунта исходного разработчика, незаметно заменить модель на вредоносную. Уязвимость особенно опасна именно из-за своего «тихого» характера: подмена модели не приводит к явным сбоям или ошибкам, но может содержать скрытые вредоносные триггеры или модификации поведения, которые сложно обнаружить традиционными методами тестирования и аудита. Такая возможная замена модели на неавторизованную версию создает значительные риски для репутации компаний, разработки и конечных пользователей.

Инциденты с подобной атакой могут привести к социальным, финансовым и юридическим последствиям, особенно в критически важных сферах, таких как медицина, юридические услуги, финансовый сектор и информационная безопасность. Кроме того, Silent Injection иллюстрирует более широкую проблему, присущую цепочкам поставок машинного обучения. В отличие от классических программных уязвимостей, кибератаки на ML-системы обладают семантическим характером: вредоносное вмешательство может не проявляться на уровне программного кода, но влиять на поведение модели, например, вызывая несправедливость, предвзятость, утечку информации, обход фильтров или выполнение несанкционированных действий под определёнными условиями. Среди сценариев атак на модель отмечают несколько наиболее опасных разновидностей. Во-первых, это отравление обучающих данных, при котором злоумышленники намеренно внедряют ошибки в тренировочные выборки, вызывающие систематические и устойчивые искажения результатов работы моделей.

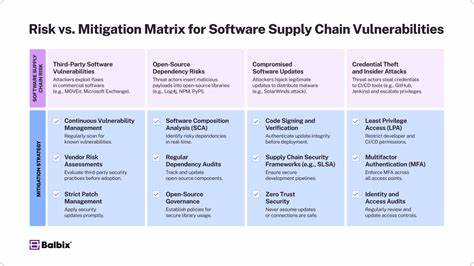

Во-вторых, нейронные бекдоры — скрытые механизмы, встроенные в веса модели, активируемые определёнными входными паттернами, позволяющие обойти защитные ограничения или раскрыть конфиденциальную информацию. Примерами могут служить скрытая передача финансовой логики с помощью триггеров в AI для банковского сектора или манипуляция результатами анализа контрактов в юридических AI-системах. Чтобы бороться с уязвимостью Silent Injection, исследователи рекомендуют радикальное изменение подхода к управлению зависимостями в AI-проектах. Главным средством защиты становится фиксирование версий используемых моделей, токенизаторов, наборов данных и других элементов посредством криптографических хешей, а не просто указание веток или тегов репозитория. Такой подход обеспечивает жесткую неизменность подключаемых объектов и исключает возможность подмены на этапе развертывания или обновлений.

Практическая демонстрация безопасной конфигурации показывает, что все вызовы функций загрузки, такие как from_pretrained или load_dataset, должны содержать параметр revision с задействованным SHA-коммитом, что гарантирует загрузку именно той версии, которая была изначально проверена и одобрена. С точки зрения процесса разработки и DevSecOps, включение подобных методов защиты помогает обеспечить воспроизводимость, аудит и устойчивость AI-экосистем. Для автоматизации процесса проверки безопасности была внедрена расширенная функциональность в инструмент Bandit — популярный статический анализатор для Python. Новый модуль сканирует исходный код на предмет отсутствия фиксации версий и других потенциально опасных паттернов использования библиотек Hugging Face. Благодаря такой проверке разработчики могут своевременно обнаруживать и устранять уязвимости в цепочке поставок, что значительно снижает риск Silent Injection.

Результаты анализа масштаба проблемы свидетельствуют о том, что она носит системный, а не частный характер. В рамках исследования изучено 1668 публичных репозиториев с Hugging Face-зависимостями, относящихся к 1100 организациям. Всего уязвимыми оказались свыше 15 тысяч файлов с AI-кодом, что указывает на широкое распространение опасной практики. Ключевым выводом становится понимание того, что безопасность в AI требует новых принципов мышления. Традиционные методы, применяемые в софтверной разработке, часто недостаточны для обеспечения целостности моделей и данных машинного обучения.

Необходимо внедрять процедуры криптографического контроля, жесткой фиксации версий и регулярного аудита. Всесторонний подход к защитным мерам в цепочке поставок AI включает не только настройку ревизий, но и мониторинг установленных моделей на наличие изменений, предупреждение компрометаций аккаунтов, просвещение специалистов и разработчиков о новых категориях рисков. Лидеры индустрии, такие как Hugging Face и другие крупные платформы, должны активно поддерживать использование безопасных практик во всех инструментах и документации. В конечном итоге, Silent Injection – не просто уязвимость, а показатель растущей необходимости пересмотра стандартов безопасности в эпоху искусственного интеллекта. Внимание к этой проблеме помогает создать более устойчивую и доверенную инфраструктуру для разработки, деплоя и эксплуатации AI-моделей, открывая путь к безопасному и этичному внедрению технологий в бизнес и повседневную жизнь.

Безусловно, реализация перечисленных мер требует усилий по всему спектру вовлеченных участников: разработчиков, исследователей, организаций и конечных пользователей. Лишь комплексный и продуманный подход способен сделать AI устойчивым к атакам, подобным Silent Injection, и обеспечить защиту от подмены или модификации моделей, сохраняя при этом качество и надежность интеллектуальных систем будущего.