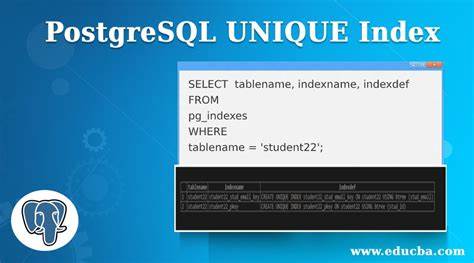

В современной разработке баз данных одним из ключевых аспектов является обеспечение уникальности данных. Особенно это важно при работе с текстовыми полями, которые могут содержать большие объемы информации. PostgreSQL – одна из самых популярных и мощных систем управления базами данных, которая предлагает множество возможностей для индексирования и оптимизации запросов. Тем не менее, при добавлении уникальных индексов на большие текстовые поля в PostgreSQL можно столкнуться с серьезными ограничениями, которые вызывают ошибки и срывают релизы. В этой статье мы подробно разберем причины таких ограничений, расскажем о внутреннем устройстве PostgreSQL, а также поделимся действенными методами, позволяющими эффективно работать с уникальными индексами на больших данных.

Для начала необходимо понять, почему уникальный индекс в PostgreSQL – это не просто способ ускорить поиск, а еще и механизм строгой проверки уникальности значений в определенном столбце. Чтобы обеспечить уникальность, СУБД должна быстро сравнивать новые значения с уже существующими и таким образом предотвращать появление дубликатов. Для реализации таких проверок в PostgreSQL доступны различные типы индексов, где наиболее востребованными являются B-Tree и Hash. Несмотря на то, что оба подходят для операций равенства, лишь B-Tree может эффективно гарантировать уникальность. Почему так происходит? B-Tree строится на сбалансированном дереве с упорядоченными ключами, что позволяет быстро находить и сравнивать записи, а Hash индекс основан на хеш-таблице, где из-за неизбежных коллизий необходима дополнительная проверка полного содержимого, что негативно сказывается на производительности.

Однако бывает так, что в продакшн-средах при попытке создать уникальный индекс на поле с большими объемами текста – например, длиной до 10 000 символов – возникает ошибка, связанная с превышением максимального размера индекса. PostgreSQL устанавливает ограничение на размер индекса, который не может превышать примерно треть 8 килобайтного блока памяти (буферной страницы), то есть около 2700 байт. Почему именно такое ограничение? Чтобы понять это, необходимо заглянуть внутрь архитектуры хранения данных PostgreSQL. В PostgreSQL все данные хранятся в файлах, разбитых на страницы фиксированного размера в 8 килобайт. Каждая страница имеет метаданные, указатели на записи, свободное пространство и сами данные.

Если какой-либо атрибут таблицы превышает размер страницы, он не помещается целиком в один блок, и тогда на помощь приходит механизм TOAST («The Oversized-Attribute Storage Technique»), который автоматически хранит большие значения в отдельной вспомогательной таблице, разбивая их на небольшие части. Однако этот механизм работает только для хранения данных, а не для индексов. В уникальных индексах значения должны быть доступны напрямую и сразу для быстрого сравнения. Проблема возникает именно из-за того, что B-Tree уникальные индексы требуют хранения значений в пределах одной страницы. Если размер значения превышает эту треть страницы, индексация становится невозможной, так как вертикальное хранение подобных больших данных привело бы к катастрофическому снижению производительности.

Причем выбор в пользу 1/3 страницы обусловлен балансом между эффективным использованием памяти и числом нужных разбиений страниц индекса. Если допустить хранение слишком больших значений, страницы придется слишком часто разбивать, что негативно отразится на скорости вставки и поиска. Как же решить эту проблему, если в базе данных активно используются большие текстовые поля, которые необходимо индексировать уникально? Один из лучших подходов – не индексировать оригинальный текст напрямую, а генерировать компактный и постоянный идентификатор или хеш-значение. Хеширование — это процесс преобразования произвольного объема данных в фиксированную по размеру строку, которая служит уникальной подписью для оригинального значения. Для реализации этого в PostgreSQL можно добавить новый столбец с рассчитанным значением хеша, например, MD5 или SHA-256.

Выбор алгоритма хеширования строится на компромиссе между скоростью и уровнем коллизий. MD5 создает хеш размером 128 бит (16 байт), работает быстро и встроен в PostgreSQL, однако теоретически возможны коллизии при очень больших объемах данных – порядка 2^63 записей. SHA-256 дает более надежную защиту от коллизий, но работает медленнее и требует установки дополнительного расширения pgcrypto. Для большинства проектов MD5 представляется достаточным выбором, учитывая объемы данных и требования к производительности. После добавления нового столбца с хешами достаточно создать на него уникальный индекс B-Tree.

Таким образом, уникальность гарантируется не по самому большому текстовому полю, а по его компактному и однозначному представлению. Такая практика значительно повышает эффективность работы с базой данных и исключает ошибки, связанные с ограничениями размера индекса. Итоговое решение состоит в том, чтобы дополнительно к исходному полю хранить хеш, который индексируется с помощью уникального B-Tree индекса. При необходимости проверки уникальности данных в приложении сначала вычисляется хеш, и проверка происходит через индексированный компактный столбец. Эта схема также хорошо работает при миграциях, обновлениях и масштабировании приложений.

Понимание внутренней структуры PostgreSQL и особенностей его механизмов хранения и индексирования позволяет более осознанно проектировать базы данных и избегать распространенных ошибок. В частности, уникальные индексы с большими текстовыми полями – это классическая проблема, решаемая с помощью хеширования. Такой подход обеспечивает высокую производительность и стабильность даже при работе с очень большими объемами информации. Кроме того, стоит отметить, что в PostgreSQL существует шесть основных типов индексов, но лишь B-Tree и Hash подходят для операций равенства. При этом Hash индексы не умеют гарантировать уникальность эффективно из-за коллизий.

Другие типы индексирования – например, GiST, GIN, SP-GiST или BRIN – оптимизированы для определенных типов данных и запросов и не подходят для универсальной проверки уникальности больших текстовых полей. Расширенное знание о внутреннем устройстве позволяющем принимать оптимальные решения позволит разработчикам создавать масштабируемые и надежные приложения. Важным итогом является то, что PostgreSQL накладывает разумные ограничения, направленные на баланс между скоростью выполнения операций и техническими особенностями хранения данных. Для разработчиков, сталкивающихся с необходимостью индексировать уникальные большие текстовые поля, наиболее простой и проверенный способ – использовать генерируемый столбец с хешом. Он обеспечивает быструю проверку уникальности и предотвращает ошибки индексации.

Этот метод совместим со всеми существующими версиями PostgreSQL, удобен при написании миграций и позволяет избежать проблем при масштабировании. Таким образом, понимание ключевых аспектов работы уникальных индексов и структур хранения в PostgreSQL является обязательным для эффективного проектирования баз данных. Использование хеширования больших полей для создания уникальных индексов – один из самых надёжных и практичных способов решения проблемы ограничений по размеру индекса. Такой подход позволяет сэкономить время, предотвратить потенциальные проблемы в продакшн средах и обеспечить надежность работы базы данных с большими объемами текстовых данных.