Сериализация данных играет ключевую роль в современных веб-приложениях и бэкенд-сервисах, обеспечивая преобразование объектов в формат, пригодный для хранения, передачи или обработки. В экосистеме Node.js, популярном среди разработчиков для создания серверных приложений, эффективная сериализация важна для быстродействия и масштабируемости. Несмотря на распространённость формата JSON, существует ряд бинарных форматов, которые могут предложить существенные преимущества в скорости и размере данных при сериализации. Развитие технологий заставляет переосмысливать традиционные подходы.

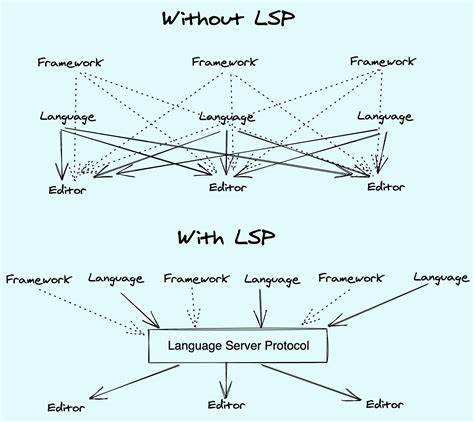

На первый взгляд, бинарные форматы должны выиграть у JSON по скорости, ведь они формируют меньший объём данных. Однако на практике ситуация более сложная. Важно учитывать не только размер выходных данных, но и внутренние оптимизации платформы. Например, в Node.js реализация сериализации JSON встроена в движок V8 и написана на C++, что обеспечивает оптимальное выполнение.

В то время как многие библиотеки для бинарных форматов написаны на чистом JavaScript, что снижает их эффективность. Исследования и экспериментальные тесты с популярными библиотеками, такими как avsc для Avro, msgpackr для Msgpack, protobuf.js для Protocol Buffers и Bebop, показывают интересную картину. Несмотря на их потенциал, без тщательной оптимизации эти библиотеки уступают по скорости стандартному JSON. Такое положение дел побуждает к глубокому анализу и улучшению процесса сериализации.

Оптимизация использования памяти и управление ресурсами — два ключевых аспекта, которые нужно учитывать. При подготовке данных к сериализации многие реализуют преобразование объектов, создавая новые структуры, что приводит к значительному «мусору» в памяти (garbage collection). Это тормозит производительность, так как сборщик мусора требует времени на очистку неиспользуемых объектов. Решением становится отказ от избыточного копирования объектов и применение специальных трансформеров или прокси-объектов, которые выступают как тонкий слой адаптации данных без создания большого количества промежуточных объектов. Такой подход существенно снижает нагрузку на сборщик мусора и в разы ускоряет процесс.

Другим важным фактором является выделение буферов для сериализации. Многие библиотеки динамически увеличивают размер буфера по мере необходимости, создавая новые области памяти и копируя данные, что дорого в краткосрочной перспективе, особенно в JavaScript, где выделение и копирование Uint8Array достаточно затратны. Предварительное вычисление необходимого размера буфера и единоразовое выделение памяти позволяет избежать ненужных операций и повысить скорость выполнения. Например, библиотека avsc использует внутренний механизм, где сначала происходит попытка сериализации с небольшим буфером, которая при неудаче вызывается повторно с буфером большего размера. Хотя такой метод гарантирует корректность, он менее эффективен по сравнению с явным вычислением размера.

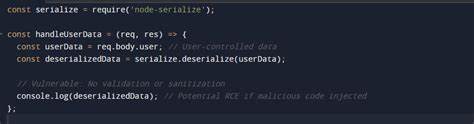

В самом Node.js по умолчанию отсутствуют развитые инструменты для глубокого профилирования, но благодаря модулю inspector можно легко провести анализ распределения памяти и CPU-самлпинг, выявляя узкие места и конкретные участки кода, которые требуют улучшения. Отдельно стоит обратить внимание на библиотеки protobuf.js и альтернативные реализации. protobuf.

js, несмотря на популярность и удобство, генерирует много мусора и имеет сложную реализацию, что отражается на производительности. Альтернативные библиотеки, например Pbf, оказываются значительно легче и быстрее, при этом генерируемый код остаётся понятным и удобным для поддержки. Применение такой тактики позволяет разработчикам добиться высокой скорости сериализации и снизить нагрузку на сервер, что критично при работе с большими объёмами данных, например с 100 000 элементами в массиве событий или треков. Важное замечание состоит в том, что не всегда достижение максимальной производительности возможно при использовании исключительно JavaScript. Компилируемые языки, такие как Rust, изначально обладают преимуществами по скорости и расходу памяти.

Это означает, что для проектов с высокими требованиями к производительности стоит рассмотреть возможность использования более эффективных языков для критичных операций сериализации и десериализации. Тем не менее Node.js по-прежнему востребован ввиду своей гибкости и широкой базы разработчиков. В качестве заключения, грамотный выбор формата данных и понимание особенностей работы в Node.js напрямую влияет на производительность приложений.