Мир Data Science, машинного обучения и искусственного интеллекта продолжает стремительно развиваться, предоставляя исследователям и специалистам новые инструменты и идеи для эффективного решения сложных задач. Одним из авторитетных источников свежей информации и аналитики в этой области является еженедельный бюллетень Data Science Weekly, который выпустил свой 605-й номер, насыщенный интересными материалами и полезными советами для профессионалов и энтузиастов. Рассмотрим подробнее основные темы и тренды, освещённые в этом выпуске, чтобы понять, какие направления и вызовы актуальны для современного сообщества Data Science на сегодняшний день. Одной из главных тем выпуска стало обсуждение так называемого "Горького урока" (The Bitter Lesson), концепции, которую неоднократно упоминали в сфере машинного обучения. Она заключается в том, что развитие алгоритмов и моделей выигрывает, когда учёные и инженеры отказываются от ручного детального конструирования специализированных методов в пользу общих подходов, которые способны эффективно использовать большие объёмы данных и мощные вычислительные ресурсы.

В рамках этой идеи в выпуске проясняется роль токенизации — традиционного способа преобразования текста в блоки для обработки моделями. Обсуждается её уязвимость и ограничения, а также перспективные альтернативы, такие как Byte Latent Transformer, которые могут заменить токенизацию на более универсальные и мощные механизмы, лучше использующие вычислительные возможности и масштабируемость данных. Это направление открывает новые возможности для повышения качества и эффективности языковых моделей и расширения их функционала. Важное место в номере занимает детальный обзор вопросов оптимизации SQL-запросов и работы с DataFrame на примере системы DataFusion. Как отмечается, оптимизация запросов часто воспринимается как нечто мистическое и сложное, иногда даже называют «чёрной магией» в области компьютерных наук.

Основной причиной такой репутации является то, что оптимизаторы интегрированы с различными аспектами системы хранения данных, транзакций и выполнения запросов, что затрудняет их тщательное изучение вне контекста полноценной базы данных. Тем не менее в серии публикаций, начатой в этом выпуске, разъясняется, что задачи оптимизации не являются более сложными по своей сути, чем другие компоненты систем управления базами данных. Анализируются ключевые вызовы, такие как выбор путей доступа к данным и порядок соединения таблиц, и подчеркивается, что решение этих задач требует системного подхода и творческого мышления. Отдельное внимание уделяется образованию и визуализации в сфере машинного обучения. Представлен проект, включающий сборник интерактивных Jupyter ноутбуков, которые демонстрируют математическое обоснование и практическую реализацию алгоритмов машинного обучения с нуля.

Особенностью таких инструментов является визуализация процесса обучения моделей и их постепенного сходимости к оптимальным весам. Такой подход способствует более глубокому пониманию фундаментальных механизмов работы алгоритмов и помогает новичкам и опытным специалистам лучше осваивать сложные концепции. Среди новостей выделяется рассказы о десятилетии популярного пакета R — loo, который служит для эффективного приближённого кросс-валидационного оценивания байесовских моделей, а также для вычисления весов моделей, используемых при усреднении предсказаний. История и эволюция этого инструмента указывают на значимость методологий оценки моделей и необходимость постоянного развития софта, поддерживающего современные статистические методы. В выпуске обсуждается распространённое заблуждение относительно роли алгоритмов в практике искусственного интеллекта.

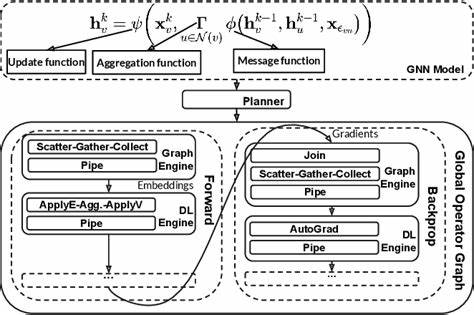

Несмотря на впечатляющие успехи нейронных сетей и других моделей, большая часть работы в реальных проектах связана с подготовкой и очисткой данных: устранением пропусков, инженерией признаков, правильной постановкой задачи. Отдельно подчеркивается важность «программирования с помощью подсказок» в работе с крупными языковыми моделями, то есть prompt engineering, которое становится новым ключевым навыком. Публикации свидетельствуют, что на первых этапах проекта нужно уделять больше внимания качеству данных и определению целей, чем сложным архитектурам моделей. Ещё одним интересным материалом стал разбор автоматического дифференцирования — ключевой технологии для обучения сложных моделей, особенно нейросетей. В заметках приводятся учебные материалы, содержащие слайды и ноутбуки для пошагового изучения принципов данной технологии, что позволяет значительно углубить знания в области алгоритмической дифференцировки и её реализации.

Особую важность приобретает управление качеством данных и наблюдаемостью при использовании AI-систем в промышленности. Разбирается внутренняя практика по устранению проблем с данными в агенте технической поддержки, показывающая, что далеко не модель всегда является источником проблем, а часто именно пробелы и нарушения в данных выдают сбои и снижают производительность. Важность комплексного мониторинга от сбора данных до выхода модели особо подчеркивается. Для исследователей по-прежнему актуальны вопросы управления исследовательскими данными, и в выпуске представлен новый дайджест RDM Weekly — ресурс с полезными материалами по этой теме, который помогает профессионалам в научных кругах организовывать, сохранять и делиться своими данными. Техническая новинка — плагин marimo-quarto, позволяющий использовать реактивное выполнение и виджеты marimo в блогах и документации, создаваемых с помощью Quarto.

Это расширяет возможности интерактивного представления данных и кодов, улучшая опыт пользователей и разработчиков в области визуализации и аналитики. Не обошли вниманием и опыт проведения технических собеседований на позиции Data Scientist, где поделились неожиданными инсайтами, которые нередко карьерным начинающим кажутся полезными, и помогают лучше подготовиться к реальным трудовым вызовам. Для более теоретически ориентированных читателей подготовлена монография, посвящённая изучению взаимосвязей между методами с использованием положительно определённых ядер: гауссовскими процессами и компактными гильбертовыми пространствами с воспроизводящими ядрами. Рассмотрены применения в регрессии, интерполяции и других статистических задачах, демонстрируя, как сочетание вероятностных и детерминистских подходов обогащает инструментарий машинного обучения. Среди технологических достижений выделяется обзор программы DARPA Blackjack, направленной на развитие спутниковых группировок на низкой околоземной орбите.

Результаты и уроки от борьбы с техническими и организационными вызовами показывают значимость инноваций в связи и управлении космическими аппаратами, а также роль интеграции коммерческих технологий для снижения стоимости и повышения масштабируемости. Ещё один крупный анонс касается выхода версии 4.0.0 популярного пакета ggplot2 — флагмана в области визуализации данных на R. Переход на новую систему классов S7 влечёт за собой изменения, требующие адаптации прикладных пакетов и скриптов.

Разработчики Posit активно помогают сообществу, готовя патчи и предоставляя инструменты поддержки, что подчёркивает важность воспроизводимости и стабильности среды для разработчиков и пользователей. Для тех, кто работает с большими объёмами текстовых данных, в выпуске представлен обзор методов оценки систем вопросов и ответов с длинным контекстом. Рассмотрены метрики, создание тестовых датасетов, а также инструменты аннотирования и сравнительного анализа с использованием как человеческих экспертов, так и автоматизированных LLM-оценщиков. Это является ключевым для развития интеллектуальных систем, способных работать с многостраничными документами и комплексными техническими текстами. В разделе профессионального развития освещается обсуждение сложных тем в области data engineering, способных стать перспективными направлениями для построения успешной карьеры.