В последние годы глубинное обучение вышло на новый уровень, охватив не только классические задачи компьютерного зрения и обработки естественного языка, но и сферы, связанные с программированием и анализом программного кода. Одним из наиболее многообещающих направлений стала интеграция графовых нейронных сетей (Graph Neural Networks, GNNs) с техникой анализа потоков данных (Data-Flow Analysis, DFA) — классическим средством статического анализа программ. Этот симбиоз открывает уникальные возможности для повышения точности, масштабируемости и адаптивности программного анализа с использованием передовых моделей искусственного интеллекта. Анализ потоков данных традиционно используется для выявления взаимоотношений между различными частями кода, таких как значения переменных, состояния программы и потенциальные пути исполнения. DFA основывается на битовых векторах и итеративных алгоритмах, что делает её мощным инструментом для оптимизации компиляторов, обнаружения уязвимостей, а также для ряд других задач, связанных с надежностью и безопасностью ПО.

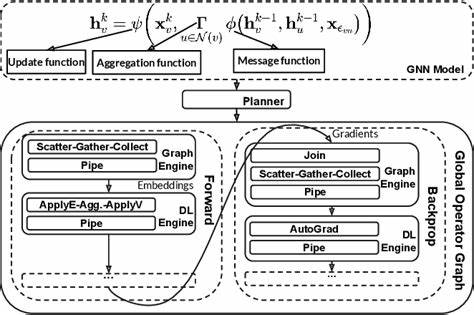

Однако классические методы могут испытывать сложности при работе с огромными и сложными программными графами, требующими значительных вычислительных ресурсов и трудоемкой настройки. Графовые нейронные сети за последние годы зарекомендовали себя как эффективный метод обработки структурированных данных, представленных в виде графов. GNN способны обучаться на неоднородных и разреженных графовых структурах, что позволяет им моделировать взаимосвязи между узлами и ребрами с сохранением контекста. Именно благодаря способности учитывать структуру графа и передавать сообщения между вершинами, GNN стали популярными в областях, где данные естественным образом формируют графы: социальные сети, биоинформатика, а теперь и анализ программ. На первый взгляд DFA и GNN имеют много общего, поскольку оба оперируют графовыми представлениями программ, где узлы – это операции или переменные, а ребра – связи потоков данных или управления.

Однако есть ключевые различия. DFA опирается на точные итеративные вычисления с обеспечением свойств монотонности и обеспечения неинтерференции битовых векторов, тогда как GNN обучаются на данных и могут испытывать сложности с точным моделированием подобных жестких логических требований. Эта проблема известна как разрыв алгоритмического выравнивания (algorithmic alignment) между архитектурой GNN и алгоритмом DFA. Для преодоления этой разницы исследователи разработали несколько архитектур GNN, которые постепенно приближаются к внутреннему устройству анализа потоков данных. Среди них выделяются три поколения моделей: DFA-GNN−, DFA-GNN и DFA-GNN+, где каждая последующая версия лучше учитывает ограничения и свойства классического DFA.

В частности, модели реализуют механизмы защиты от помех между битовыми векторами и умеют обрабатывать внешнюю информацию на разных этапах алгоритма, что очень важно для корректного анализа программного кода. Ключевым аспектом таких моделей является их способность к обобщению – обучаться на небольших примерах и успешно масштабироваться на значительно большие графы программ. Это свойство невероятно ценно в реальных задачах, где объем анализируемого кода может варьироваться от нескольких строк до миллионов операторов. DFA-GNN+ продемонстрировала высочайшую эффективность и способность сохранять высокую точность при увеличении размера входных данных в 10 раз, что подтвердило практическую применимость этого подхода. Кроме того, исследование показало, что GNN, обученные только парным ввод-вывод без полного контроля промежуточных шагов выполнения алгоритма, способны достичь качества, сопоставимого с моделями, использующими всю траекторию исполнения.

Это открывает новые горизонты для упрощения процедур обучения и повышения надежности GNN в задачах алгоритмического вывода. Перспективы развития данной области крайне многообещающие. Интеграция GNN с анализом потоков данных может существенно улучшить процессы автоматизированного обнаружения уязвимостей в программном обеспечении, повысить качество систем автоматического рефакторинга и оптимизации кода, а также послужить катализатором для развития нейросетеобразных компиляторов и систем программной верификации. Преимущества такого подхода заключаются не только в точности, но и в адаптивности: обучение моделей происходит на реальных данных, что позволяет им учитывать специфику конкретных проектов, языков программирования и стилей кодирования. Это обеспечивает глубокое и контекстуальное понимание программных структур и логики, недоступное традиционным статическим анализаторам.

Вместе с тем, вызовы остаются значительными. Для более широкого внедрения требуется решить задачи интерпретируемости моделей, обеспечить их надежность при работе с опасными или ошибочными программами, а также интегрировать GNN-решения в существующие инструменты разработки и компиляции без существенного увеличения времени анализа. Будущие исследования сосредоточатся на улучшении архитектур GNN, включая внимание к отдельным частям графа, более изощренные механизмы передачи сообщений, а также на создании гибридных систем, совмещающих преимущества классических алгоритмов и нейросетевых подходов. Особое внимание будет уделено обучению на больших и разнообразных наборах данных, а также повышению эффективности обучения без необходимости подробных промежуточных меток. Таким образом, сближение графовых нейронных сетей и анализа потоков данных формирует новое направление в анализе программ, которое обещает изменить подходы к оптимизации, безопасности и автоматизации программирования.

Чем ближе эти методы будут друг к другу, тем выше будет их взаимодополняемость и эффективность, открывая двери для качественно новых технологий в области разработки программного обеспечения.