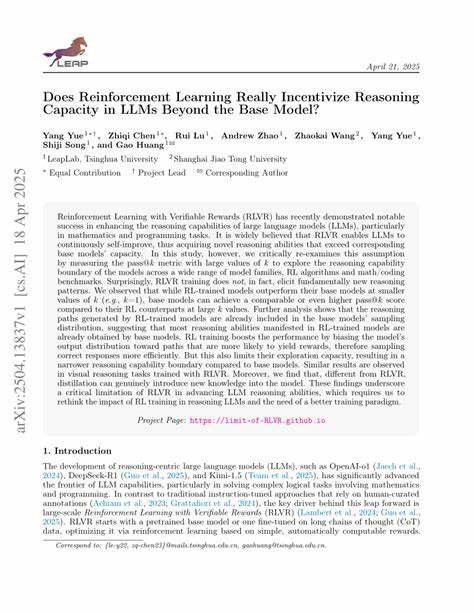

Обучение с подкреплением (RL) давно считается одним из ключевых методов повышения эффективности и способностей больших языковых моделей (LLM). Несмотря на широкое распространение RL в практике развития ИИ, остаётся вопрос: действительно ли RL способствует появлению новых когнитивных навыков и глубинных возможностей рассуждения в языковых моделях или же просто увеличивает частоту появления уже известных моделей решений? Недавнее исследование учёных из Университета Цинхуа проливает свет на эту важную тему, вызвав широкий резонанс и обсуждения в сообществе исследователей искусственного интеллекта. Основной вывод работы сводится к тому, что RL, при использовании проверяемых наград (verifiable rewards), преимущественно увеличивает вероятность появления уже имеющихся возможностей у базовой модели вместо создания принципиально новых способностей. Для оценки способности моделей решать комплексные задачи применялся показатель pass@k, который отражает вероятность успеха модели при выполнении задачи хотя бы в одном из k попыток. В эксперименте сравнивались базовая языковая модель и её версия с обучением через RL.

По результатам работы, на одном из сложных математических бенчмарков версия с RL показывала более высокий pass@1, то есть чаще одной попытки оказывалась успешной, но при увеличении количества попыток до 256 базовая модель начинала показывать лучшие результаты. Такой феномен был интерпретирован как сужение «границ рассуждений» модели, когда RL усиливает наиболее распространённые и частые алгоритмы решения, одновременно «отсекая» менее вероятные, но потенциально полезные пути рассуждений, которые базовая модель всё ещё способна генерировать. Таким образом, RL формирует узкую, но глубокую область компетенций, исключая разнообразие решений, которое существует в исходной модели. Кроме того, в ряде тестов на задачах, выходящих за рамки тренировочных, RL-обученные модели показывали преимущества при большом числе попыток, подтверждая возможность некоторого расширения горизонта возможностей, особенно при использовании усовершенствованных алгоритмов RL, таких как Reinforce++ и RLOO. Однако этот эффект проявлялся только на очень больших значениях k — 256 и выше, что говорит о том, что практическое преимущество RL в таких случаях достаточно узконаправленное и трудно достижимое при реальном применении.

Особое внимание уделялось анализу perplexity — метрики, отражающей предсказуемость генерации текстов моделью, на выходе RL и базовой моделей. Оказалось, что RL-обученные модели выдавали тексты с более низкой perplexity, что указывает на более предсказуемый и менее разнообразный тип ответов. Это поддерживает гипотезу того, что RL не открывает новых путей решения, а лишь упорядочивает и усиливает уже существующие, делая выбор моделей менее вариативным. В противоположность RL, методы дистилляции с учителем-экспертом демонстрировали расширение зоны рассуждения моделей, повышая производительность при всех значения pass@k. Это означает, что дистилляция позволяет моделям осваивать более широкий спектр методов решения задач, а не сужать их, как это происходит с RL.

Тем не менее, исследование признаёт ограниченность своих выводов. RL может раскрывать новые способности при задачах с длинной цепочкой необходимых правильных рассуждений, где вероятность случайно собрать верный ответ через пробу и ошибку становится крайне низкой. В таких длинных многозадачных сценариях RL способен кардинально повысить успех модели, поскольку учится надёжно выполнять последовательность действий, что трудно воспроизвести через простое случайное семплирование базовой модели. Однако в экспериментах с задачами вычислений и визуального рассуждения эти эффекты могли быть недостаточно выражены из-за ограничений методологии и тестов. Также следует учитывать, что большинство экспериментов проводилось на моделях с максимальным размером порядка 32 миллиардов параметров, и для более крупных моделей возможны иные влияния RL, в том числе более выраженное повышение интеллекта и рассудочных навыков.

Современные большие модели с сотнями миллиардов параметров могут вести себя иначе, а RL вкупе с архитектурными инновациями и дополнительными алгоритмическими усовершенствованиями способен работать более эффективно. В сообществе экспертного обсуждения данный труд вызвал разные мнения. Некоторые специалисты указывают на противоречия между результатами этого исследования и практическими достижениями RL-моделей, которые показывают существенные улучшения и масштабируемость при увеличении количества попыток. Другие предполагают, что RL действительно неизбежно приводит к «коллапсу мод» — уменьшению разнообразия в решениях модели — и что на практике это означает выбор между надежностью и полем творческого разнообразия. Подобные дискуссии связаны с фундаментальными вопросами о том, что представляет собой «способность» модели и как именно RL влияет на неё.

Одна из точек зрения разделяет «нейросеть» и «алгоритм», который она реализует: предобученная модель содержит основу алгоритма, который задаёт её базовые возможности, а RL лишь корректирует веса и контексты, оптимизируя выбор из уже заложенных действий, но не создавая принципиально новых «алгоритмов» рассуждения. Однако есть и противоположные мнения, что RL может активировать и развивать новые конкурентоспособные пути мышления или тематические стратегии, которые, хотя и присутствуют в потенциальном распределении модели, без RL остаются недоступными для практического использования. Это приводит к рассуждению о том, как балансировать между расширением творческого диапазона моделей и улучшением их надежности для конкретных применений. Интересно отметить, что в различных областях, включая креативные и творческие задачи, результаты RL могут существенно отличаться. Области, требующие оригинальности и генерации новых идей, могут выигрывать от менее закалённого и более разнообразного поведения базовых моделей.

В то время как задачи с жёсткими требованиями к точности и надежности решаются лучше при использовании RL, который «сужает» варианты и делает поведение более предсказуемым. В целом анализ перспектив обучения с подкреплением указывает на важность комплексного подхода к оценке моделей. Реальный прогресс в сфере искусственного интеллекта зависит не только от повышения средних показателей по конкретным метрикам, но и от понимания того, как упомянутые методы влияют на природу рассуждений, разнообразие решений и способность моделей адаптироваться к новым и сложным задачам. Кроме того, озвученные идеи ставят под сомнение некоторые популярные гипотезы о том, что RL непосредственно обеспечивает скачок в интеллектуальных способностях и автоматически приводит к появлению качественно новых умений у языковых моделей. Вместо этого, RL стоит рассматривать скорее как инструмент повышения стабильности и надежности существующих возможностей базовой модели, что играет важную роль, но не решает полностью задачу развития глубинного мышления.