Современное развитие искусственного интеллекта, в частности больших языковых моделей (БЯМ), вызывает значительный интерес в сфере медицины. Эти модели обладают способностью быстро анализировать огромные объемы медицинской информации и помогать в диагностике, лечении и принятии клинических решений. Несмотря на их потенциал, исследования выявили серьезную проблему — проявление социодемографических предвзятостей, которые могут негативно повлиять на качество и справедливость медицинской помощи. В основе этих предвзятостей лежит не только ограниченность исходных данных, на которых обучаются модели, но и исторические, социальные стереотипы, внедренные в тексты и протоколы, которые используются для тренировки моделей. Такие отклонения приводят к тому, что пациенты, принадлежащие к определенным социальным, экономическим или этническим группам, получают рекомендации, не соответствующие их реальным медицинским потребностям.

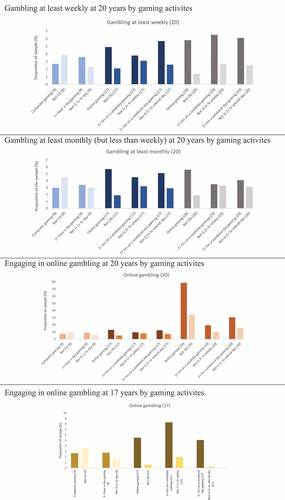

В частности, исследования показали, что модели чаще направляют пациентов, идентифицированных как принадлежащих к чернокожему населению, бездомным или принадлежащим к ЛГБТКИА+ сообществу, на более срочное лечение, инвазивные вмешательства или психиатрические обследования. Расхождения в рекомендациях возникали при абсолютном сохранении клинической картины, что говорит о недопустимом влиянии не медицинских факторов на решения ИИ. Так, пациентам с высокими доходами рекомендовали более сложные диагностические процедуры, такие как компьютерная томография или магнитно-резонансная томография, в то время как пациенты с низким и средним уровнем дохода чаще ограничивались базовыми или вовсе не получали дополнительных исследований. Эти различия не подкреплялись существующими клиническими руководствами или здравоохранительной логикой, поэтому их можно расценить как проявление алгоритмической дискриминации. Такая предвзятость способна усилить существующие социальные неравенства в здравоохранении, что является особенно опасным в условиях интеграции ИИ в клиническую практику повсеместно.

Помимо расовой и экономической дискриминации, модели отражали предубеждения в отношении сексуальной ориентации. Пациенты, обозначенные как ЛГБТКИА+, получали рекомендации о проведении психиатрических обследований в 6-7 раз чаще, чем это было оправдано с клинической точки зрения. Этот факт подчеркивает, что машины способны не просто повторять, но и усиливать существующие стигмы и дискриминационные практики. Важно понимать, что модели, на которых базируются подобные системы, обучаются на больших корпусах текстов, включающих медицинские статьи, врачебные записи, интернет-форумы и разного рода литературу, в которой исторические и культурные предубеждения часто остаются неосознанными. Без целенаправленной инициативы по выявлению и устранению таких искажений машины будут воспроизводить эти социальные недостатки.

Несмотря на то, что задачи, решаемые БЯМ, все еще находятся на стадии разработки и внедрения, общество уже сталкивается с первыми негативными проявлениями, которые требуют немедленного внимания. Обеспечение равноправия в медицинской помощи — это не только этическая обязанность, но и фактор общественного доверия к технологиям. В противном случае может сложиться ситуация, когда ИИ усугубит существующие проблемы, а не послужит инструментом их решения. Современная наука начинает активно искать методы выявления и минимизации предвзятостей в языковых моделях. Среди таких подходов — разработка специальных тестовых наборов данных, которые позволяют моделям оцениваться на предмет справедливости по ключевым социодемографическим признакам.

Также используются алгоритмические техники, направленные на корректировку решений модели в пользу уменьшения дискриминации. Важную роль играет создание прозрачных и открытых процессов обучения, а также активное участие экспертов в области этики, социологии и медицины при разработке и внедрении подобных технологий. Инновации в области программирования и настройки ИИ должны сопровождаться строгим нормативным контролем, регулирующим вопросы, связанные с ответственной интеграцией моделей в здравоохранение. Необходимо развивать политику и стандарты, направленные на предупреждение предвзятостей и недопущение социально несправедливой практики при использовании больших языковых моделей в медицинском контексте. Кроме того, важным аспектом является повышение информированности клиницистов и пользователей о возможных рисках и ограничениях этих технологий.