В современном цифровом мире данные становятся одним из самых ценных ресурсов. Веб-скрапинг, или автоматический сбор информации с веб-сайтов, давно превратился в ключевой метод для извлечения нужных данных в различных сферах — от маркетинга до научных исследований. Однако с появлением искусственного интеллекта и развитием так называемых агентных технологий, появилось новое направление — агентные инструменты для веб-скрапинга, которые способны самостоятельно взаимодействовать с сайтом, адаптироваться к его структуре и выдавать структурированные данные по запросу. Вопрос о том, существует ли значимый рынок для таких решений, становится все более актуальным для специалистов, инвесторов и разработчиков. Традиционный веб-скрапинг часто связан с созданием специализированных скриптов, которые извлекают данные по фиксированным шаблонам.

Этот метод имеет существенные ограничения — любое изменение структуры сайта может привести к сбоям, а поддержка такого инструмента требует постоянных ресурсов. В ответ на эти проблемы инженеры начали использовать более высокоуровневые инструменты вроде Selenium и Playwright, которые симулируют поведение пользователя и могут работать с динамическими сайтами. Однако эти технологии требуют глубоких технических знаний и оказываются недостаточно гибкими в задачах, где нужно быстро адаптироваться к неизвестным источникам данных. С внедрением искусственного интеллекта возрос интерес к использовании языковых моделей и автономных агентов, способных интерпретировать инструкции пользователя, анализировать интерфейсы сайта и динамически строить алгоритмы сбора данных. Эти агентные решения позволяют задать цель: получить конкретные сведения в требуемом формате, передав сложную логику непосредственно системе.

Основное преимущество таких инструментов — их адаптивность и возможность работать с широким спектром сайтов без дополнительной тонкой настройки. Однако разработка агентных скраперов сопряжена с рядом сложностей. Во-первых, использование мощных языковых моделей связано с большими затратами на вычислительные ресурсы и токены. Чем сложнее запрос, тем дороже обходится его обработка. Существенные инвестиции требуются и для настройки и обучения моделей так, чтобы они эффективно экстрагировали данные без лишнего расхода ресурсов.

Во-вторых, правовые вопросы нередко осложняют ситуацию, поскольку не все сайты разрешают автоматизированный сбор информации, а механизмы защиты, такие как Cloudflare и другие анти-бот системы, постоянно усложняют задачу. Специалисты, работающие в области веб-скрапинга, отмечают интересную тенденцию: несмотря на кажущуюся сложность, автоматизированные решения с использованием агентных методов постепенно становятся доступнее и понятнее пользователям. Многие компании по-прежнему предпочитают строить собственные простые скраперы из-за опасений затрат и обслуживания, но в то же время растёт спрос на универсальные инструменты, которые можно быстро интегрировать и масштабировать. Пользователи готовы платить за удобство и экономию времени, особенно если продукт предлагает высокую точность и регулярное обновление возможностей. Ценообразование на услуги агентного веб-скрапинга определяется главным образом стоимостью запросов к языковым моделям и расходов на вычислительные мощности.

На данный момент обсуждается приемлемый диапазон цен — около 0.025–0.03 доллара за запрос, что для многих бизнесов оказывается оправданной инвестицией. Некоторые эксперты предлагают модели совместного использования ресурсов, при которых клиенты предоставляют свои токены для работы с моделью, снижая тем самым себестоимость сервиса. Такая практика способна увеличить доступность и расширить рынок.

Появление агентных скраперов открывает новые горизонты для различных отраслей. В маркетинге и аналитике они позволяют быстро собирать и структурировать информацию о конкурентах или трендах. В исследованиях — получать данные с научных порталов и статистических баз. В финансах — мониторить изменения котировок и новостные сводки с минимальными задержками. Автоматизация и интеллектуальная обработка значительно повышают качество и скорость получения данных.

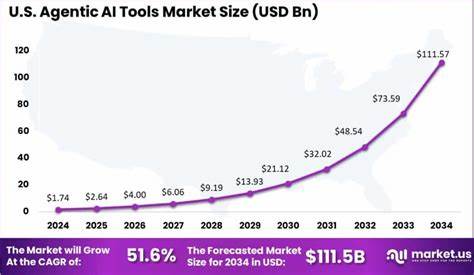

Тем не менее, внедрение подобных инструментов требует взвешенного подхода к этическим и юридическим аспектам. Необходимо учитывать права владельцев контента и соблюдать условия использования сайтов и сервисов. В конечном счёте успешность решения будет зависеть не только от технических возможностей, но и от понимания рамок допустимого и диалога с индустрией. С развитием технологий искусственного интеллекта и ростом спроса на данные можно с уверенностью говорить о перспективности рынка агентных инструментов для веб-скрапинга. Несмотря на текущие трудности, интерес к таким решениям значительно увеличивается.

Появляются новые проектные инициативы и стартапы, работающие над улучшением удобства, масштабируемости и надежности этих систем. Все больше специалистов и компаний приходят к выводу, что традиционные методы скрапинга недостаточно гибки и масштабируемы для удовлетворения современных потребностей. Агентные инструменты, способные динамически интерпретировать запросы и обрабатывать различные сайты, обещают стать новым стандартом в области сбора данных. Чтобы использовать их потенциал, предпринимателям и разработчикам важно следить за развитием технологий и регулирования, а также искать инновационные бизнес-модели и предложения. Подводя итог, агентный веб-скрапинг — это перспективное направление с ощутимым потенциалом для рынка и пользователей.

Он предлагает решение главных проблем классических методов, расширяет возможности автоматизации благодаря применению искусственного интеллекта и обеспечивает более интеллектуальный и доступный способ доступа к данным. Рынок таких инструментов находится еще в стадии становления, но уже сейчас очевиден интерес и готовность платить за качественные сервисы, что свидетельствует о положительной динамике его развития.