В мире современных технологий искусственный интеллект занимает всё более значимое место, трансформируя способы взаимодействия человека с информацией и автоматизации процессов. Одной из ключевых технологий является моделирование распознавания шаблонов — фундаментальный процесс, лежащий в основе не только человеческого восприятия, но и работы современных систем искусственного интеллекта, таких как большие языковые модели. Но несмотря на ощутимые достижения, точные механизмы работы этих систем остаются для нас загадочными и вызывают множество вопросов как у исследователей, так и у пользователей. Человеческий мозг с его уникальной структурой и сложной сетью нейронов издавна удивляет учёных своей способностью быстро и эффективно распознавать шаблоны и закономерности. Наш мозг настолько хорошо справляется с этой задачей, что порой мы видим в окружающем вещи, которых там на самом деле нет — яркий пример тому явление парейдолии, когда мы распознаём лица там, где их вовсе нет.

Эти способности лежат в основе сложных когнитивных функций и принимаемых ежедневно решений. Психолог Гэри Кляйн предложил теорию естественного принятия решений, основанную на том, что эксперты могут оперировать не столько осознанным анализом множества вариантов, сколько быстрым сопоставлением текущей ситуации с уже известными шаблонами. Его исследования касались профессионалов в экстремальных и сложных сферах: пожарных, авиадиспетчеров, медицинских работников, где решения должны приниматься быстро и часто на основе неполных данных. Пытаясь перенести понимание распознавания шаблонов в область искусственного интеллекта, исследователи обратились к нейробиологии и вычислительным моделям. Первым серьёзным шагом стала модель перцептрона, предложенная психологом Фрэнком Розенблаттом.

Эта модель пыталась смоделировать работу простой искусственной нейронной сети с целью имитации процесса распознавания образов. Однако изначальная версия с одним слоем имела ограничения в задачах, которые мог выполнять перцептрон. Ситуация менялась с появлением многослойных нейронных сетей с нелинейными функциями активации — их начали называть глубокими нейронными сетями. Именно преодоление ограничений однослойных перцептронов открыло дверь для развития современных технологий глубокого обучения, применяемых в больших языковых моделях (LLM). К примеру, такие известные модели как GPT-3, DeepSeek-LLM и Llama 3.

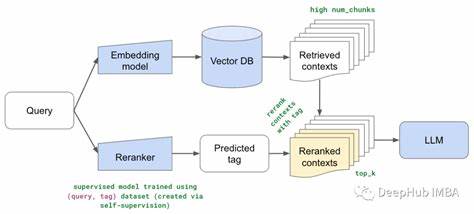

1 обладают от 90 до более чем 120 слоёв, что позволяет им эффективно анализировать и генерировать текст. Современные языковые модели обрабатывают входной текст, преобразуя его в последовательности числовых представлений — векторов, которые проходят через многочисленные слои сети. Каждой из этих слоёв можно приблизительно приписать работу с «абстрактными» уровнями информации: от конкретных слов к более общим понятиям и обратно. Однако в реальности точно определить, какие именно паттерны или концепции закодированы в промежуточных слоях, крайне сложно. Интенсивные исследования в области интерпретируемости моделей пока не дают исчерпывающих ответов по этой теме.

Другим важным моментом является цель, для которой создаются эти модели. В отличие от классических инженерных или научных моделей, призванных дать определённое объяснение явлениям или выполнить строго ограниченную задачу прогнозирования, LLM создаются как системы, предсказывающие следующий элемент в последовательности текста. Удивительно, но именно эта простая задача оказалась основой для способности моделей демонстрировать долгосрочное планирование, ведение диалогов и решение сложных задач, которые ранее считались прерогативой человеческого интеллекта. Это неожиданное свойство современных ИИ-систем нашло объяснение в том, что структура человеческого языка сама по себе отражает модель мира с его функциональными взаимосвязями. Обучаясь предсказывать следующий элемент языкового ряда, модель косвенно «учится» моделировать окружающий мир.

Тем не менее работа языковых моделей и процесс человеческого познания фундаментально различны. Например, люди не способны выучить язык исключительно посредством пассивного поглощения информации, в отличие от машин, которые обрабатывают колоссальные объёмы данных. Философ Дэниел Деннетт вводил понятия разных «точек зрения» на объект, чтобы прогнозировать его поведение: физическую, проектировочную и интенциональную. Первая основана на физических законах, вторая — на проектных особенностях, а третья — на предполагаемых намерениях и мотивациях субъекта. В случае с языковыми моделями интуитивно мы склонны применять именно интенциональную позицию, воспринимая ИИ как разумного собеседника, имеющего свои цели и желания.

Однако на деле это лишь иллюзия, вызванная сходством генерируемого текста с человеческой речью. Дизайн системы помогает предсказать, что она выдаст связные ответы, но не раскрывает суть внутренних процессов и причин поведения модели. Очень часто ошибки или неточности в работе языковых моделей не дают понимания их внутреннего устройства, ведь с точки зрения их программного обеспечения — модель работает так, как было задумано — генерирует правдоподобный следующий фрагмент. Из-за этого типичное обучение и опыт работы с ИИ-инструментами характеризуются неожиданными и даже загадочными проявлениями их поведения, что отличает их от традиционных инженерных систем. Такие особенности требуют нового подхода к пониманию и контролю искусственного интеллекта, который сочетал бы эмпирические наблюдения и глубокое теоретическое осмысление.

В заключение, машины распознавания шаблонов, известные как большие языковые модели, формируют удивительный и пока не до конца понятный мир искусственного интеллекта. Они совмещают в себе черты биологических систем и строгих алгоримтических конструкций, порождая новое качество взаимодействия человека с информацией. Несмотря на необъяснимые сложности и ограниченную прозрачность их работы, потенциал этих систем уже сегодня меняет множество сфер жизни, открывая новые горизонты для науки, технологий и общества.