В современном мире искусственного интеллекта одним из ключевых вызовов остается организация эффективной и точной системы долговременной памяти для агентов. Особенно важно, чтобы AI-системы могли удерживать и правильно использовать информацию, полученную в ходе десятков и сотен взаимодействий, сохраняя контекст и релевантность без существенной деградации качества. Достижение высокого уровня точности при решении таких задач напрямую влияет на качество пользовательского опыта и эффективность автоматизированных систем. Масштабный прорыв в этой области показала компания Mastra, которая, используя принцип Retrieval-Augmented Generation (RAG), смогла добиться рекордных 80% точности на международном бенчмарке LongMemEval, сопоставимых результатов с которыми ранее задавали ведущие игроки рынка. Что такое LongMemEval LongMemEval представляет собой специализированный бенчмарк, предназначенный для оценки способности AI-систем эффективно оперировать долговременной памятью в условиях многозадачности и мультисессионных диалогов.

Сам бенчмарк состоит из 500 вопросов, каждый из которых сопровождается около 50 уникальными диалогами. Важно, что ответ на поставленный вопрос присутствует лишь в одном или нескольких из этих диалогов. Такая архитектура позволяет объективно оценить, насколько корректно система находит и использует релевантную информацию с течением времени и через сотни сообщений. Вызовы традиционных подходов к памяти агентов До появления RAG одной из привычных моделей была использование так называемой «рабочей памяти» – система, призванная хранить ключевые характеристики пользователя, например имя, интересы, предпочтения и другое. Однако такой подход имел ряд ограничений, особенно в долгосрочной перспективе.

Первая попытка Mastra использовать рабочую память для решения задач LongMemEval показала крайне низкие результаты – порядка 20% точности. При объединении с базовой семантической памятью, основанной на векторных индексах, эффективность падала или незначительно улучшалась. Еще одной проблемой была ограниченность шаблонов, с помощью которых рабочая память структурировала данные. Универсальные шаблоны неспособны охватить нюансы конкретных типов вопросов и сценариев, что приводило к потере существенной части релевантной информации. Отсюда и вытекает необходимость перехода к более кастомизированным решениям, лучше соответствующим потребностям конкретного приложения.

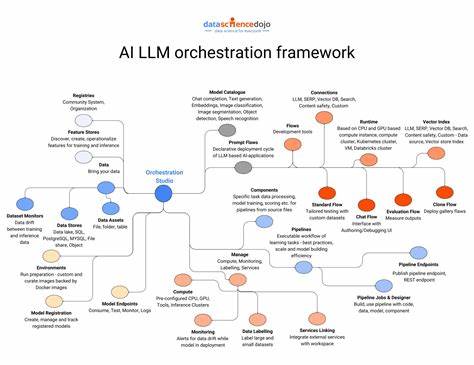

Как Mastra вывела RAG на новый уровень Retrieval-Augmented Generation представляет собой методологию, где внешний источник данных предоставляется моделью во время генерации ответа, повышая как релевантность, так и объем информации, доступной для анализа. Mastra акцентировала внимание на правильной организации и форматировании подаваемых на вход данных. Одна из важных их находок – временные метки сообщений, игнорирование которых до этого снижало точность временного рассуждения в системах. Исправление временных штампов, а также добавление актуальной даты вопроса в системное приглашение позволило заметно улучшить результаты в категориях, связанных с временным контекстом. Кроме того, тщательное переосмысление формата представления сообщений – группировка по году, месяцу, дню, с добавлением временных меток и пометок о принадлежности к текущему или предыдущему диалогу – позволило LLM лучше ориентироваться в хронологии событий и эффективно обрабатывать релевантные данные.

Важным шагом стала гибкая настройка параметра topK – количества наиболее релевантных сообщений, извлекаемых из векторной базы, для передачи модели. При увеличении topK с 2 до 20 наблюдался существенный рост общей точности системы от 63% до 80%. Это демонстрирует, что расширенный круг контекстных данных практически напрямую влияет на точность ответа модели. Отдельного внимания заслуживают усовершенствования, связанные с обновлением рабочей памяти. Ранее она полностью перезаписывалась при каждом добавлении нового факта, что негативно сказывалось на последовательности и логической связности.

Разработка нового API, позволяющего делать точечные обновления с контекстным объяснением изменений, повысила точность до 72% при комбинировании с семантическим поиском. Тем не менее, Mastra пришли к выводу, что рабочая память больше подходит для краткосрочного контекста, персонализации и управления поведением агентов, чем для решения задач долговременной памяти. Стоимость и технические аспекты Проведение таких масштабных тестирований связанно с высокими затратами – Mastra потратила около 8000 долларов и обработала порядка 3.8 миллиардов токенов при нескольких итерациях тестов и отладки. Но это инвестиция в точность и стабильность, которая позволяет создавать надежные и эффективные решения для многих отраслей, от поддержки клиентов до интеллектуальных помощников.

Одна из цельных задач компании – дальнейшее снижение стоимости таких benchmark-запросов без потери качества. Оптимизация становится выгодной не только для команды разработчиков, но и для конечных пользователей, так как позволяет снизить стоимость использования и сделать систему более доступной. Будущее технологий долговременной памяти с RAG Mastra не останавливается на достигнутом. В планах – развитие таких функций, как ограничение максимально передаваемых токенов, внедрение более сложных архитектур GraphRAG, а также интеграция новых типов памяти, включая эпизодическую и архивную. Также активно рассматриваются варианты автоматического суммирования бесед для дальнейшего повышения качества и эффективности системы.

Интересно, что компания открыто делится частью опыта и исходным кодом для настройки бенчмарка LongMemEval, что поможет широкой AI-сообществу быстрее адаптировать и усовершенствовать свои технологии. Будущее за системами памяти, способными не просто хранить, а динамично оперировать и реконструировать информацию на основе множества диалогов с пользовательской логикой. Выводы Опыт Mastra убедительно доказывает, что подход Retrieval-Augmented Generation остается востребованным и эффективным для построения долгосрочной памяти AI-агентов. Вопреки мнению некоторых конкурентов, правильная интеграция и оптимизация RAG позволяет не только сохранять релевантность со временем, но и значительно превосходит по точности традиционные методы. Ключ к успеху кроется в тщательном анализе типов вопросов, гибком управлении обновлениями памяти и умелом использовании дополнительного контекста.

Наличие детализированных временных меток и соответствующего форматирования данных помогает моделям лучше ориентироваться в больших объемах информации и делать качественные выводы. Для разработчиков AI-агентов и систем поддержки пользователей это важнейший ориентир. Инвестиции в собственные бенчмарки, постоянное отслеживание качества и использование передовых методик поиска и генерации информации позволят создавать умные, запоминающие и эволюционирующие решения, соответствующие высоким требованиям и ожиданиям пользователей.