В современном мире вычислительных технологий объём данных и нагрузка на серверы постоянно растут. Одним из основных ресурсов для эффективной работы приложений и систем является оперативная память (RAM). Однако реальность такова, что многие сервера в облачных инфраструктурах и дата-центрах не используют память в полной мере, часто находится значительная часть ОЗУ в «покое». Концепция далёкой памяти (Far Memory) представляет собой перспективный подход к преодолению ограничений традиционных моделей управления памятью и открывает новые возможности для повышения эффективности вычислительных ресурсов. Идея далёкой памяти заключается в расширении обычной локальной оперативной памяти за счёт подключенного удалённого или дополнительного объёма памяти, который мог бы находиться как внутри того же сервера, так и на соседних машинах в кластере.

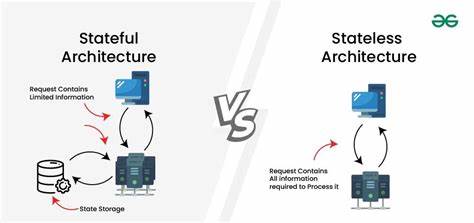

Благодаря этому приложения и системы получают гибкость в использовании памяти, позволяя «растягивать» её объём по мере необходимости и оптимизировать нагрузку, избегая проблем с нехваткой ресурсов и ошибками Out of Memory (OOM). Традиционно программное обеспечение и операционные системы оперируют жёсткой границей выделенной памяти для каждого процесса или контейнера. Это приводит к так называемому «фрагментированию памяти», когда одни приложения недополучают ресурсы, а другие – простаивают с избыточным объемом памяти. В условиях распределённых и контейнеризованных систем, таких как Kubernetes, данный подход не позволяет эффективно перераспределять ресурсы между сервисами, ограничивая гибкость и увеличивая расходы на инфраструктуру. Отличительной чертой концепции далёкой памяти является создание многоуровневой и распределённой иерархии памяти.

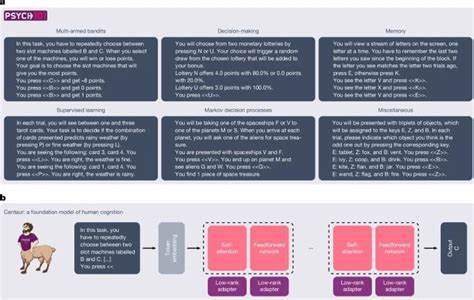

В её основе лежит представление памяти как лестницы, включающей несколько слоёв: кеш процессора, оперативная память, медленная память, а также удалённая память других серверов и даже флеш-накопители. Эта иерархия позволяет системе распределять данные по различным слоям в зависимости от их актуальности и степени «горячести». Например, «горячие» данные, активно используемые приложениями, остаются в быстрой локальной памяти, тогда как «холодные» или редко используемые сегменты перемещаются в более медленные, но объёмные слои. Одним из важнейших вызовов остаётся поддержка производительности при таких масштабах. При обращении к удалённой памяти возникает задержка, связанная с сетевыми передачами и дополнительной обработкой данных.

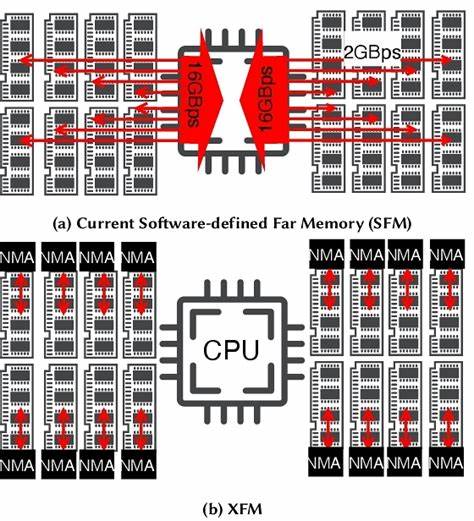

Продвинутые решения, такие как использование RDMA (Remote Direct Memory Access), позволяют значительно сократить задержки и повысить пропускную способность коммуникаций между узлами. Однако с точки зрения аппаратного обеспечения это требует внедрения специализированных технологий, что порождает сложности и дополнительные затраты. Разработчики и исследователи предлагают различные подходы к реализации далёкой памяти. Например, Lagar-Cavilla и коллеги в исследовании по «Software-Defined Far Memory» описывают методы сжатия холодных фрагментов памяти на локальной машине с использованием расширенного swap через zswap в Linux. При этом существенных изменений на уровне аппаратного обеспечения не требуется, и приложения работают без модификаций.

В противоположность этому, проекты, ориентированные на удалённые машины, используют как программные доработки, так и аппаратные расширения. Так, решения Руяна и команды (AIFM) создают специализированный runtime-окружение, где происходит массовое переключение потоков в ожидании данных из далёкой памяти, обеспечивая при этом бесшовную интеграцию для приложений. Другие проекты, вроде FaRM, предлагают транзакционную память с возможностью блокировок конкретных удалённых регионов, что расширяет функциональность и даёт разработчикам новые инструменты управления памятью. Концепция распределённой памяти в масштабах всего дата-центра способствует улучшению использования ресурсов, позволяя объединять незадействованную память на различных узлах и предоставлять её на запрос. Такой подход ведёт к появлению единого, эластичного пространства памяти, что упрощает масштабирование приложений и может стать основой для новых типов вычислительных платформ.

Проблемы оптимального использования ресурсов отчасти связаны с тем, что в вычислительных облаках нередко наблюдается неравномерность нагрузки: одни узлы перегружены задачами CPU, но имеют избыточную память, а другие обладают высоким объёмом RAM при низкой вычислительной активности. Разграничение понятий «холодной» и «застрявшей» памяти позволяет точнее прогнозировать и управлять расходом ресурсов. «Холодная» память - это та, что простаивает из-за нерегулярного использования, а «застрявшая» – из-за несоответствия конфигурации задач ресурсному профилю сервера. Для разработчиков далёкая память несёт радикальное упрощение процессов создания масштабируемых приложений. Вместо размышлений о пределы локальной памяти и сложной оптимизации работы с выделенными ресурсами, код можно писать так, будто памяти безгранично много и её распределение прозрачно для приложений.

При этом современный runtime берёт на себя ответственность за размещение и миграцию данных по уровням памяти и машинам, что значительно снижает рутинные ошибки, связанные с Out of Memory и нехваткой ресурсов. Примером программной платформы, близкой к идее единого распределённого рантайма с управлением памятью, является Erlang. Он обладает встроенными инструментами межузловой коммуникации и собственным планировщиком задач, что обеспечивает прозрачную обработку распределённых сообщений и потоков. Идея может быть расширена: не только передавать сообщения, но и динамически перемещать объекты памяти между узлами без вмешательства разработчика. Аналогично можно представить себе набор аннотаций в языках программирования, позволяющих указывать, какие объекты будут «горячими», «удаляемыми» или податливыми к сжатию.

Однако на практике внедрение далёкой памяти сталкивается с техническими и организационными препятствиями. Ключевой вызов – уменьшение накладных расходов на передачу данных и управление метаданными. Текущие механизмы свопинга обычно работают на уровне страниц памяти, что не всегда эффективно при произвольных и мелких объектах, характерных для многих современных приложений. Переход на удалённые хранилища требует шифрования и целостности данных, что добавляет дополнительную нагрузку на CPU. Сама архитектура современных серверных систем, зачастую построенная вокруг концепции NUMA (Non-Uniform Memory Access), уже сталкивается с проблемами задержек при удалённом доступе к памяти.

Далёкая память лишь усиливает эти эффекты, поскольку удлинённые задержки доступа требуют более умной оптимизации размещения данных и их предсказания. Сжатие данных на уровне локальной холодной памяти и перенос её в более медленные слои – разумный промежуточный шаг, который позволяет минимизировать обращения к удалённым узлам и соответственно снизить накладные издержки. Кроме того, перспективным направлением становится разработка «умных» планировщиков и рантаймов, которые смогут учитывать характер и «теплоту» объектов, динамически балансируя нагрузку и определяя оптимальное расположение данных. Реализация впечатляющих систем далёкой памяти является важным шагом на пути к более гибким, экономичным и масштабируемым вычислительным системам. С увеличением количества AI-тренировочных кластеров и высвобождением ресурсов в крупных распределённых инфраструктурах спрос на подобные решения становится всё более заметным.

Подводя итог, можно сказать, что далёкая память – это не просто новая технология, это сдвиг в парадигме обращения с ресурсами вычислительных систем. Обеспечивая единое и эластичное пространство памяти, оно открывает возможности для создания более адаптивных и эффективных приложений, позволяя балансировать между производительностью и экономией ресурсов. Вызовы ещё остаются, но перспективы ясны: будущее за системами, где память перестаёт быть локальной ограниченностью и становится распределённым, динамично управляемым ресурсом.