В последние годы технологии искусственного интеллекта стремительно развиваются, и одной из ключевых областей является создание языковых моделей, способных вести естественный диалог, генерировать тексты и помогать в принятии решений. Однако, несмотря на впечатляющие способности современных систем, существовал фундаментальный вызов - непредсказуемость и вариативность генерируемых ответов при повторных запросах. Эта особенность, называемая недетерминированностью, многими считалась неизбежной в работе больших языковых моделей (LLM). Тем не менее, появление концепции детерминированных языковых моделей сулит качественный прорыв в решении этой проблемы и расширении возможностей ИИ. Детерминированные языковые модели - это новая парадигма в разработке ИИ, направленная на устранение случайности в выводах системы.

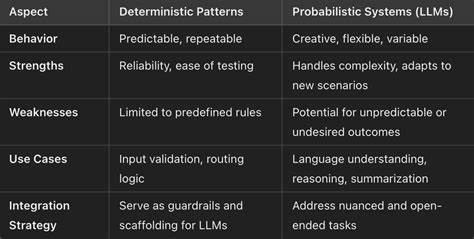

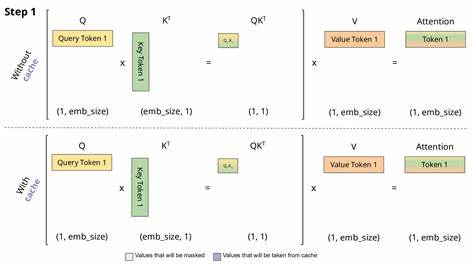

Проще говоря, такие модели гарантируют получение одного и того же ответа при повторении идентичных запросов, что значительно повышает надежность и предсказуемость работы искусственного интеллекта. Основным источником недетерминированности сегодня является способ обработки данных на уровне аппаратного обеспечения, в частности, операции, выполняемые GPU, используемыми для вычислений. Исследования, в частности, проведенные в лаборатории Thinking Machines Lab, помогли выявить, что именно взаимодействие и распределение вычислительных задач через так называемые GPU kernel'ы вносит вариативность в итоговые ответы моделей. Контроль над этим процессом и тщательная организация работы вычислительных модулей позволяет добиться значительной степени повторяемости результатов, что и является ключевой составляющей детерминированности. Практическая ценность детерминированных моделей огромна.

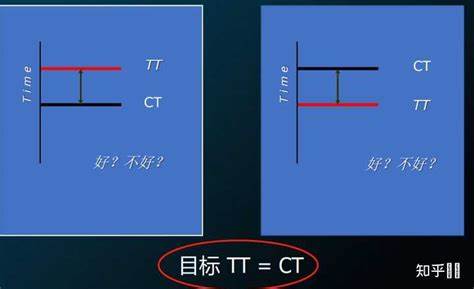

В первую очередь, речь идет о повышении качества научных исследований и коммерческих приложений, где важна не только точность ответов, но и их стабильность. В традиционных недетерминированных системах результаты могут варьироваться даже при идентичных условиях, что затрудняет проверку гипотез, отладку и масштабирование решений. Кроме того, детерминированность значительно позволяет улучшить процессы обучения с подкреплением (reinforcement learning). В привычной схеме, варьирующиеся ответы влияют на качество обратной связи и усложняют получение стабильного сигнала вознаграждения. Снизив эту шумность, можно сделать процесс обучения ИИ более предсказуемым и эффективным, что открывает двери для создания более совершенных и адаптивных моделей.

Another key implication of deterministic LLMs is their utility in enterprise environments. Businesses can rely on consistent outputs for critical tasks such as automated customer support, compliance documentation, and decision-making aids. When answers are reproducible, enterprises gain trust in the technology, enabling broader integration and use in regulated industries. The journey towards deterministic LLMs is also marked by a renewed call for openness and collaboration among AI researchers. Historically, many breakthroughs in AI were shared openly to accelerate progress.

Yet, with increased commercialization, some companies have adopted more closed models of development. Thinking Machines Lab's approach, including the commitment to share insights through a dedicated research blog named Connectionism, signals a positive shift back to open, rigorously scientific communication. Experts anticipate that such transparency will benefit not only the scientific community but also stakeholders who rely on trustworthy artificial intelligence applications. As the technology matures, it is expected to influence how future AI assistants interact with users. Consistent, repeatable responses will not only enhance user satisfaction but also reduce misunderstandings and errors.

This could lead to greater acceptance of AI tools in sensitive contexts such as legal advice, healthcare recommendations, or educational tutoring where reliability is paramount. The challenges on this path remain significant. Device-level precision, software orchestration, and massive data throughput must all align perfectly to achieve full determinism. Furthermore, as models grow in complexity, maintaining this guarantee without compromising performance or scalability is a key engineering and research hurdle. Nevertheless, early results and prototypes from leading AI research groups have invigorated the field with optimism.

The substantial financial investments and the involvement of prominent researchers indicate a strong momentum towards bringing deterministic LLMs from concept into widespread reality. In conclusion, deterministic large language models represent a transformative evolution in artificial intelligence technology. By addressing foundational sources of randomness in model outputs and ensuring reproducibility, these models pave the way for more reliable, trustworthy, and efficient AI applications. Their development promises to impact scientific research, commercial implementations, and everyday human-machine interactions, marking a significant milestone in the ongoing AI revolution. .

![零基础也看得懂的机箱推荐 2025年 性价比电脑机箱选购指南 [包括ATX塔式、MATX小塔 ITX 华硕 先马 TT 骨伽]618 双11](/images/5098805A-01DF-4BF1-9447-3C502882F07A)