В последние годы тема искусственного интеллекта (ИИ), в частности больших языковых моделей (LLM), привлекла невероятное внимание общественности, СМИ и бизнеса. Слово «ИИ» стало своего рода волшебным ключом, обещающим революцию в общении, работе и жизни в целом. Однако за эффектом «волшебства» часто скрывается довольно прозаичная реальность — машины, которые не столько мыслят, сколько вычисляют вероятность появления следующего слова в тексте. Давайте внимательно рассмотрим, что скрывается за этим трендом и почему важно не позволить себе обмануться красивыми маркетинговыми обещаниями и иллюзиями. Большие языковые модели работают на основе сложных статистических алгоритмов — они анализируют огромные массивы текста и учатся предсказывать слова, основываясь на контексте.

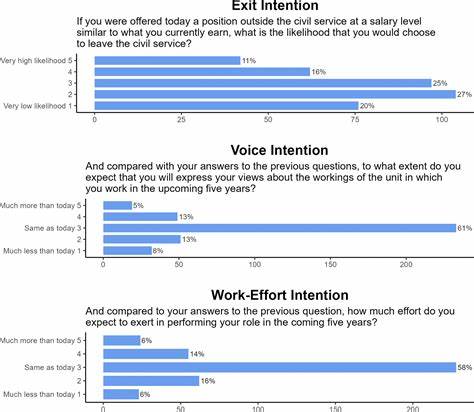

При этом никакого понимания смысла, осознания или намерения они не имеют. В отличие от человека, робот не обладает сознанием и не задумывается о том, что именно он «говорит». Результат — впечатляющие, но бессмысленные с точки зрения осмысленной коммуникации тексты, имитирующие речь. Исследования, проведённые среди государственных учреждений в Нидерландах, демонстрируют типичные проблемы с чатботами на базе LLM. Даже простые задачи, например, ответить на вопросы об графиках работы учреждений или праздничных днях, большинство чатботов не выполняют успешно.

Часто ответ сводится к указанию ссылки на источник, а не к развернутой и точной информации. Проблемы с цифровой доступностью для людей с ограничениями по зрению встречаются повсеместно, что делает большинство интерфейсов совершенно непригодными для такой аудитории. Самое удивительное — это спокойное отношение многих специалистов, работающих с такими системами, как будто некачественная работа является нормой и лишь частью процесса тестирования. Это отражает общий феномен — ожидание, что технологии будут работать идеально, часто сменяется принятием и привыканием к несовершенствам. Одним из центральных моментов является осознание того, что компьютер не пишет текст.

Он не мыслит и не выражает идеи. Всё создаётся исключительно посредством вычисления вероятности появления слов и последовательностей — никакого творческого или аналитического процесса за этим нет. Это похоже на сложную партию в рулетку с текстом, где машина лишь кидает «слова» по установленным правилам, но не понимает их значения. Человеческий мозг при этом естественным образом склонен воспринимать текст как продукт сознательного мышления. Мы ожидаем, что за письменным словом стоит человек с намерением, эмоциями и пониманием.

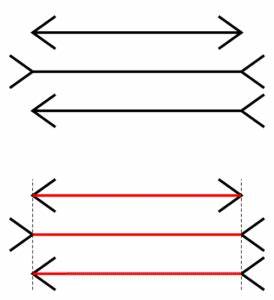

Такое впечатление усиливается, когда чатбот имитирует стиль живого диалога, моргает «глазами» на экране, ставит точки и создаёт атмосферу общения с живым собеседником. Все эти элементы — отголоски маркетинга, призванные придать машинам человечность и убедить пользователя, что у него действительно получается взаимодействие с интеллектуальным собеседником. Однако это далеко не так, и подобная иллюзия носит название «коммуникативная иллюзия». Она сопоставима с известными оптическими иллюзиями, когда наш мозг подсказывает нам неверное восприятие при обработке визуальной информации. В случае LLM мы сталкиваемся с когнитивным феноменом, в котором мозг ошибочно приписывает машине человеческие качества и способности, которых у неё попросту нет.

Особое внимание языковые и когнитивные учёные уделяют тому, что смысл и язык — неотъемлемое свойство человеческого разума и общения. Мы наделяем смыслом не просто слова, а целые конструкции в контексте социального взаимодействия. Машина же не способна к конструированию смысла, она лишь имитирует результаты этого процесса, опираясь на огромные корпуса данных и вероятность. В своей классической работе философ Пэрол Грайс выделил принцип кооперации в разговоре — он основан на взаимном доверии собеседников и обязательстве не заниматься бессмысленной болтовнёй. В диалоге с человеком данный принцип обычно выполняется автоматически, поскольку участники разговора заинтересованы в понимании друг друга.

В случае общения с чатботом мозг ошибочно применяет те же правила, хотя и не имеет основания ожидать от машины искреннего высказывания или осмысленного ответа. На фоне всего этого начинают проявляться и социальные риски: люди нередко приписывают чатботам человеческие эмоции, рассматривают их как психологов, собеседников или даже духовных наставников. Такая вера в «разум» машины опасна, поскольку она порождает заблуждения, может приводить к эмоциональной зависимости, а также нарушать базовые представления о том, что такое коммуникация. Нередко производители языковых моделей называют появление неверных или неуместных ответов «галлюцинациями». Такой термин снижает ответственность создателей и переводит выявленные проблемы в разряд бытовых ошибок.

А тем временем машина порождает потоки бессмысленной информации, требующая дополнительной проверки и исправления со стороны человека, превращая работу в изматывающий процесс «вспахивания» текста для вычленения истины. Не стоит питать иллюзий, что машины когда-либо заменят глубину человеческого мышления или креативность. По утверждению профильных учёных, в том числе профессора Ирис ван Рой, именно богатство человеческого сознания и способность комбинировать данные из разных источников в контексте делает человека уникальным. Машины же демонстрируют лишь поверхностные навыки и в основном «исполняют работу» без осознания. При этом нельзя недооценивать влияние маркетинга и коммуникаций вокруг ИИ, которые подогревают ажиотаж, обещая технологии, заменяющие человека.

Часто в основе информационной кампании лежит создание образа «элиты прогресса», в которую входит пользователь, владеющий инструментами AI. В конечном итоге люди попадают в «ловушку веры» — они начинают заигрывать с идеей, что машина думает и говорит, как живой собеседник. Парадоксально, что даже коммуникационные профессионалы, имевшие специальное образование, часто становятся невольными распространителями этих мифов, способствуя утрате критического мышления и постепенной утрате профессиональных навыков в области письма и анализа. Вместо развития собственных компетенций, человек склонен делегировать важное мышление машине, которая неспособна компенсировать человеческую интуицию и глубокое понимание. Для выхода из этой ситуации необходимо вооружиться знаниями о природе больших языковых моделей и механизмах их работы.

Образование, основанное на исследованиях в лингвистике, когнитивных науках и информатике, позволяет трезво оценивать возможности и ограничения современных технологий. Вместо пассивного принятия рекламы, стоит сформировать критическую позицию, которая поможет избежать распространения ошибочных представлений и ложных ожиданий. Вместо слепого следования за технологическими модными трендами, лучше сосредоточиться на развитии и применении тех уникальных возможностей, которые отличают человека. Креативность, способность к абстрактному мышлению, адаптивность и эмпатия — качества, которые не поддаются алгоритмизации и вычислениям. Эти навыки остаются главным активом в эпоху цифровых инноваций.