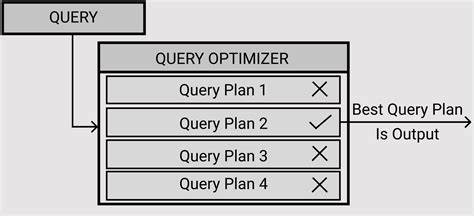

Оптимизация выполнения запросов — ключевой аспект в работе с крупными базами данных. Многие разработчики и администраторы сталкивались с ситуацией, когда PostgreSQL выбирает, казалось бы, неподходящий или неоптимальный план для выполнения запроса. Почему так происходит? Неужели система не способна определить наилучший путь для получения результата? В основе этой проблемы лежит сразу несколько факторов, начиная от особенностей планировщика запросов и заканчивая настройками параметров системы и спецификой оборудования, на котором работает база данных. Планировщик PostgreSQL, отвечающий за выбор стратегии выполнения запросов, использует оценки затрат на различные варианты планов. Эти оценки базируются на статистике, собранной о данных в таблицах, и на параметрах конфигурации, влияющих на расчёт стоимости операций чтения и записи.

Однако сама природа оценки затрат несёт в себе допущения и упрощения, которые в реальных условиях могут не оправдываться. В итоге планировщик выбирает план с наименьшей предполагаемой стоимостью, но он может оказаться далеко не самым эффективным. Одним из критичных параметров, влияющих на выбор плана, является random_page_cost, задающий относительную стоимость случайного чтения страницы на диске по сравнению с последовательным. Значение этого параметра напрямую отражается на оценке стоимости индексных сканирований, сопровождающихся интенсивным случайным вводом-выводом, в отличие от последовательных сканов, которые, как правило, более эффективны при чтении больших объёмов данных. С исторической точки зрения, default-значение random_page_cost было установлено в 4.

0 — цифра, которая отражала соотношение стоимости операций для традиционных магнитных жёстких дисков с механическим приводом. Однако технологии хранения данных значительно эволюционировали. Современные твердотельные накопители (SSD), особенно NVMe, значительно сокращают задержки случайного доступа, уменьшив реальную разницу между случайным и последовательным чтением. Тем не менее многие инсталляции PostgreSQL продолжают использовать устаревшие настройки, что приводит к переоценке стоимости индексных сканов и, как следствие, выбору неоптимальных планов с последовательными или bitmap-сканами. На практике снижение значения random_page_cost с 4.

0 до порядка 2.0 или ниже может изменить картину и привести к более частому выбору индексных сканов планировщиком. Однако, как показывают наблюдения, такой подход не гарантирует оптимальности: индексные сканирования, выбранные по более низкой стоимости в плане, нередко оказываются заметно медленнее по фактическому времени выполнения. Это связано с тем, что оценка стоимости остаётся приблизительной и не учитывает все реалии выполнения запросов, включая особенности кэширования, предвыборки данных и нагрузку на хранилище. Важное различие между видами сканирований заключается в использовании предвыборки страниц.

Bitmap-сканы, например, умеют эффективно делать предвыборку (prefetching), что позволяет ускорить чтение больших участков данных за счёт более последовательного доступа к хранилищу. Индексные сканы традиционно не обладают таким преимуществом, обращаясь к страницам в случайном порядке. Хотя в новых версиях PostgreSQL (например, версия 18) увеличено значение effective_io_concurrency, что улучшает параллельный ввод-вывод, сам планировщик пока не учитывает этот фактор в своих оценках стоимости. Авторитетное мнение специалистов в сообществе PostgreSQL подтверждает, что оптимизировать планировщик сложно именно из-за универсальной природы задач и разнообразия данных, с которыми ему приходится работать. Он базируется на упрощённых моделях и статистике, которая не всегда отражает реальные распределения данных и поведение системы во время выполнения запросов.

Кроме того, большое количество параметров и настроек как планировщика, так и самого сервера затрудняет создание единой «идеальной» формулы для выбора лучшего плана. Выявить ситуацию, когда план запроса далеко не оптимален, можно по наблюдениям «климаксных» случаев — резких изменений времени выполнения при небольших изменениях условий запроса или данных, которые иногда называют «перфоманс-клифами». В таких случаях помогает анализ логов, профилирование запросов и экспериментальное отключение или включение разных стратегий с помощью enable_ настроек PostgreSQL. Однако для больших проектов с множеством сложных запросов такой метод становится трудозатратным и требующим значительных усилий. Для повышения надёжности и стабильности исполнения запросов в будущем предполагается развитие двух направлений.

Во-первых, улучшение статистики и внедрение адаптивных моделей оптимизации с учётом обратной связи от предыдущих запусков запросов. Во-вторых, развитие механизмов выполнения, способных «смягчать» решения планировщика, когда они оказываются неоптимальными, например, за счёт применения техник отказоустойчивого планирования и динамического переключения между стратегиями во время выполнения запроса. Интересным предложением является создание специализированных инструментов, аналогичных pg_test_fsync, которые могли бы автоматически измерять характеристики хранения данных и рекомендовать или даже динамически устанавливать параметры типа random_page_cost. Однако это задача нетривиальная, так как оценка должна учитывать не только аппаратные показатели, но и особенности нагрузки, кэширования и взаимодействия между различными уровнями системы. В конечном счёте, стоит помнить, что идеальный план запросов для произвольной базы и произвольного запроса практически невозможен из-за огромной вариативности данных и условий выполнения.

Задача оптимизатора — искать компромисс между точностью оценок и скоростью принятия решения. При этом грамотная настройка сервера, аккуратность сбора статистики, учет специфики железа и грамотная индексация могут существенно повысить качество выбираемых планов. Для тех, кто хочет глубже разобраться в теме и освоить приёмы эффективной работы с планировщиком PostgreSQL, полезным будет изучение исследований в области устойчивого исполнения запросов (robust query processing), а также участие в профессиональных семинарах и форумах. В таких источниках обсуждаются современные подходы к борьбе с проблемами неоптимальности и предлагаются пути развития систем управления базами данных в направлении более интеллектуального и адаптивного планирования. Подводя итог, можно сказать, что выбор неоптимального плана является следствием множества факторов — начиная со статических оценок и параметров конфигурации и заканчивая недостаточным учётом современных особенностей хранения и обработки данных.

Постоянная работа сообщества PostgreSQL над улучшением планировщика и механизмов исполнения призвана минимизировать такие ошибки, однако конечный успех зависит и от того, насколько тщательно пользователь и администратор базы данных анализируют и настраивают свои системы с учётом реальной нагрузки и возможностей оборудования.

![A Fundamental Unit of Intelligence [video]](/images/1B6FB573-952D-4124-9B61-70B3B89FE349)