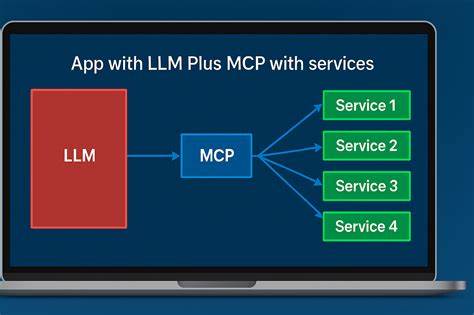

В современном мире искусственного интеллекта и автоматизации технологий взаимодействия с API, MCP серверы (Multi-Channel Protocol servers) становятся все более востребованным инструментом. Они предоставляют платформу для взаимодействия больших языковых моделей (LLM) и других AI-агентов с внешними API, значительно упрощая процесс интеграции и расширяя возможности автоматизации сервисов. Однако, создание и запуск MCP серверов в промышленном масштабе — задача далеко не простая. Опыт разработки 50+ MCP серверов, работающих в продакшене, позволяет выделить ключевые выводы и эффективные подходы, которые помогут преодолеть основные сложности и избежать распространённых ошибок. Понимание основных концепций MCP серверов и OpenAPI документов является отправной точкой для успешной разработки.

OpenAPI — это описание API в формате YAML или JSON, которое содержит информацию об эндпоинтах, параметрах запроса, форматах ответа и ошибках. С помощью специальных генераторов возможно автоматическое создание MCP серверов, преобразующих API из OpenAPI спецификации в набор инструментов, которыми LLM могут управлять. Но, как показывает практика, процесс генерации MCP серверов по OpenAPI далеко не всегда работает без сучка и задоринки. Одна из первых проблем, с которой сталкиваются разработчики, — чрезмерное количество инструментов. При большом количестве эндпоинтов, например, более 200, генерация MCP сервера просто создаёт соответствующее количество инструментов.

Для человека и, что особенно важно, для LLM такая нагрузка в контексте обработки часто оказывается чрезмерной. Алгоритм становится перегруженным, теряется фокус, а объем обрабатываемой информации превышает возможности контекстного окна модели. Для многих приложений, использующих меньшие по объему языковые модели, эта проблема усугубляется ещё сильнее, уменьшая качество взаимодействия и точность вызова нужных инструментов. Решение проблемы «взрыва» инструментов кроется в грамотном сокращении генерируемых функций. Оптимизация начинается с тщательного отбора эндпоинтов, подходящих для целевых сценариев.

Если MCP сервер, например, предназначен для помощи в работе с интернет-магазином, нет смысла включать все методы аутентификации, платежей и управления пользователями. Следует оставить только те операции, которые действительно участвуют в основном сценарии взаимодействия, такие как просмотр товаров, создание корзины и оформление заказа. Кроме того, на этапе генерации Speakeasy реализовала возможность отключать генерацию неподходящих или второстепенных инструментов с помощью специального флага в OpenAPI документах. Такой системный контроль над инструментами снижает шум и повышает высокую концентрацию внимания LLM на задачах, которые действительно важны. Еще одна значительная трудность — это качество описаний в OpenAPI.

Часто разработчики пишут очень длинные, насыщенные текстом, многопараграфные описания, рассчитанные на человеческое восприятие. Для LLM, напротив, подобная избыточность приводит к перерасходу токенов контекстного окна и осложняет выбор нужного вызова функции. Кроме того, длинные тексты часто содержат повторяющуюся информацию и неспецифичны, что заставляет модель путаться и иногда вызывать неправильные инструменты или выдавать неверные данные. В то же время, излишняя лаконичность при описаниях тоже становится проблемой, так как недостаточно информативные или расплывчатые описания не позволяют LLM однозначно выделить функцию для вызова. Чтобы решить этот парадокс, Speakeasy предлагает использовать специальное расширение x-speakeasy-mcp, позволяющее добавлять краткие, точные описания, специально адаптированные под обработку языковыми моделями.

Также популярным методом является использование оверлеев — дополнительных слоев описаний, которые накладываются поверх оригинального OpenAPI документа, не изменяя его напрямую, но улучшая восприятие информации для MCP серверов. Помимо описаний, существенным барьером для MCP серверов является сложность форматов данных, которые API возвращают в ответах. Часто ответы содержат вложенные структуры, большие объемы метаданных, бинарные данные или потоки информации, которые требуют дополнительной обработки. Для LLM зачастую сложно работать с такими сложными типами данных напрямую. Например, потоковые данные должны обрабатываться отдельно, чтобы дождаться завершения передачи перед передачей в MCP клиент.

Аналогично бинарные данные, такие как изображения или аудио, нуждаются в преобразовании, например, в Base64, чтобы стать удобными для LLM. Speakeasy разработала механизм автоматического определения и преобразования таких данных, позволяющий, например, кодировать бинарный контент, объединять потоки в целостный ответ и при необходимости создавать пользовательские SDK-хуки, которые позволяют кастомизировать обработку определенных форматов данных. Такой подход позволяет максимально эффективно упростить и адаптировать сложные ответы API для работы с LLM и обеспечить корректное и удобное взаимодействие с ними. Безопасность и контроль доступа к инструментам MCP серверов — отдельная крайне важная тема. Поскольку MCP серверы часто предоставляют сложный и мощный функционал, неконтролируемый доступ чреват рисками утечки конфиденциальной информации и несанкционированных изменений.

Например, даже с клиентскими ограничениями, такими как выключение отдельных инструментов в интерфейсе, невозможно полностью гарантировать защиту от ошибочных или непреднамеренных вызовов, особенно при работе с несколькими клиентами и средами. Для полноценного контроля доступа Speakeasy предлагает использовать стратегию, основанную на scopes — аннотации и разделения инструментов по специальным областям доступа. Эти области позволяют на уровне сервера ограничивать видимость и вызовы инструментов в зависимости от контекста использования. Например, можно разделить операции на «read» для чтения данных и «write» для записи и изменения. Более того, можно создавать кастомные scopes по тематике или функциональности, ограничивая использование только определенными группами API методов, например, только по продуктам или заказам.

Таким образом, безопасность и ограничение доступа реализуются не в клиентском интерфейсе или UI, а прямо на уровне серверной конфигурации, что повышает надежность и превосходит ограничение, зависящее от конкретного инструмента визуализации. Такая архитектура масштабируется и позволяет избежать множества ошибок, связанных с разграничением прав. В условиях растущего спроса на интеграцию и обработку данных с помощью ИИ, OpenAPI остается стандартом, который, несмотря на свою репутацию, не теряет актуальности и подходит для построения MCP серверов. Основное преимущество OpenAPI — его универсальность и совместимость с JSON Schema, что упрощает генерацию инструментов и интеграцию в экосистему разработки. Более того, автоматическая генерация MCP серверов из OpenAPI спецификаций напоминает концепцию Backends For Frontends (BFF), где многосвязанные сервисы агрегируются и упрощаются для конкретных интерфейсных задач.

MCP серверы позволяют сделать то же самое, но уже для взаимодействия ИИ с API, существенно сокращая количество избыточных вызовов и уменьшая сложность логики на стороне клиента. Накопленный опыт многочисленных производственных MCP серверов компании Speakeasy позволяет сделать несколько выводов, которые рекомендуются к применению для повышения качества систем на базе MCP. Прежде всего, нужно тщательно фильтровать набор генерируемых инструментов, оставляя только действительно необходимые. Описание каждого инструмента должно быть лаконичным, однозначным и адаптированным под модели, чтобы избежать сбоев и неправильных вызовов. Сложные данные следует преобразовывать в более простые представления перед передачей в клиента.

И, разумеется, внедрение продуманной системы scopes — ключ к надежной и безопасной работе MCP серверов в реальных приложениях. Таким образом, MCP серверы представляют собой мощнейший механизм, который при правильной реализации способен значительно расширить возможности взаимодействия AI-агентов с API. Вызовы, связанные с масштабируемостью, сложностью форматов и безопасностью, успешно решаются продуманным подходом к генерации, настройке и сопровождению MCP серверов. Опыт работы с более чем 50 MCP серверами подтверждает, что только продуманный, адаптивный и системный подход к разработке позволит вывести такие решения на уровень стабильной и эффективной эксплуатации в промышленности.