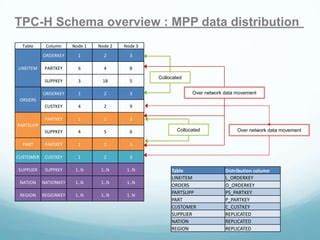

В мире современных баз данных аналитические запросы играют важную роль в быстром и эффективном получении данных для анализа и принятия решений. Одним из важнейших стандартов оценки производительности аналитических систем выступает бенчмарк TPC-H, который моделирует рабочие нагрузки, характерные для систем поддержки принятия решений. Особое внимание заслуживает первый запрос этой серии — "Pricing Summary Report" — известный своей кажущейся простотой, но наполненный глубокими оптимизациями на уровне движка базы данных. Рассмотрим, как архитектура колонкового хранения и продуманные алгоритмы локальной агрегации влияют на выполнение этого запроса и какие преимущества они обеспечивают. Прежде чем перейти к деталям, стоит сделать обзор структуры данных, используемых в TPC-H.

Модель данных отражает бизнес-сценарий розничной торговли с двумя основными таблицами — ORDERS и LINEITEM. В частности, запрос 1 оперирует исключительно с таблицей LINEITEM, которая содержит информацию об отдельных позициях заказов, включая количество, цену, скидки и налоги. Несмотря на это, именно выбор полей и особенности структуры хранения оказывают ключевое влияние на производительность. Колонковое хранение — это архитектурный подход, который группирует значения одного столбца подряд, в отличие от традиционного построчного хранения. Такой дизайн имеет ряд преимуществ в аналитических задачах.

Во-первых, когда запрос затрагивает малую часть столбцов таблицы, колонковые СУБД позволяют считывать с диска и обрабатывать только необходимые данные, значительно уменьшив объем ввод/вывода и повысив скорость анализа. В контексте TPC-H Запроса 1 это особенно актуально, поскольку запрос агрегирует данные только по двум полям для группировки и ряду числовых столбцов для вычисления сумм и средних значений. Одним из важных факторов производительности является фильтрация строк с использованием условия по дате отправки (l_shipdate). Значение параметра [DELTA] выбирается таким образом, что фильтр охватывает почти все данные таблицы, создавая нагрузку на подсистему ввода-вывода и CPU. Это позволяет тестировать эффективность механизмов сканирования данных и фильтрации.

В этом контексте колонковое хранение оказывается крайне полезным, так как данные каждого столбца расположены последовательно и могут быть считаны и обработаны параллельно с максимальной пропускной способностью. Для эффективного отсева данных используются специализированные технологии. Каждая порция данных (например, блок или страница) снабжается метаданными, указывающими минимальные и максимальные значения по колонкам. Если для блока можно сразу определить, что все значения поля l_shipdate не проходят по фильтру, то его можно целиком пропустить без распаковки и детальной проверки. Такая оптимизация сводит к минимуму ненужные операции и нагрузку на систему хранения.

Еще одним мощным инструментом, ускоряющим выполнение, является векторизация фильтрации с использованием SIMD-инструкций процессоров. Эта технология, позволяющая одновременно обрабатывать несколько значений данных одной операцией, прекрасно подходит для колонковых хранилищ, где соседние элементы столбца лежат подряд в памяти. Например, если процессор может одновременно загружать восемь 32-битных значений дат отправки в регистр SIMD, он может за одну инструкцию сравнить все восемь значений с порогом даты фильтрации, значительно снижая затраты на циклы CPU и повышая скоростные характеристики. Переходя к агрегированию результатов по значениям двух небольших группирующих полей — l_returnflag и l_linestatus — можно отметить специфику их низкой кардинальности. В сумме комбинаций всего шесть, что открывает двери к еще одному уровню оптимизаций.

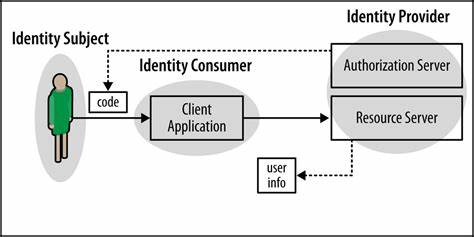

При работе с многопоточностью в аналитических системах возникает сложность с конкурентным доступом к общему хэш-агрегату из множества потоков. Использование блокировок для синхронизации увеличивает задержки и снижает параллелизм. Для решения этой проблемы консенсусом современных систем стало применение локальной агрегации на уровне каждого потока отдельно. Каждый поток формирует локальный хэш-таблицу с результатами, что исключает блокировки и повышает эффективность работы с кэш-памятью процессора. По завершении сканирования локальные агрегаты сливаются в глобальный результат.

Такой метод особенно эффективен при низкой кардинальности группирующих полей, что идеально соответствует запросу TPC-H 1. Интеллектуальные планировщики запросов могут заранее оценить, что итоговый объем агрегации невелик, используя статистику по данным, например, на основе алгоритмов подсчета уникальных значений, таких как HyperLogLog или Theta Sketches. Это помогает выбрать оптимальную стратегию локальной агрегации или переключиться на глобальную в случае необходимости. Некоторые системы реализуют динамическое переключение во время выполнения, что снижает риски превышения памяти и повышает адаптивность. Стоит также упомянуть, что конкуренция в сфере аналитических баз данных и требования бенчмарков TPC-H побуждают разработчиков внедрять и оттачивать сложные способы обработки запросов.

Помимо упомянутых, есть дополнительные техники — например, SIMD для самих вычислений агрегатов, слияние данных с учетом скинов и оптимизации на уровне планирования запросов. Общая картина показывает, насколько непростым может быть исполнение, казалось бы, простого подсчета сумм и средних по небольшому набору группирующих параметров. Высокопроизводительные аналитические системы строятся на основе комплексного подхода — от организации хранения данных до детальной проработки вычислительных алгоритмов, уделяя внимание каждой мелочи входного запроса. Таким образом, изучение TPC-H Запроса 1 предоставляет ценные уроки для проектирования и оптимизации баз данных. Колонковое хранение позволяет эффективно обращаться к выборочным полям, снижая нагрузку системы хранения и ускоряя фильтрацию.

Использование SIMD-инструкций стимулирует процессор к высокопроизводительной обработке данных векторным способом. А локальная агрегация в многопоточной среде минимизирует накладные расходы на синхронизацию, позволяя максимально использовать доступные CPU-ресурсы. Взгляд на эту тему дает понимание того, как системам удается работать с большими объемами информации, быстро выводить агрегаты и обеспечивать стабильную работу аналитических сервисов при реальных нагрузках. Каждый элемент — от физического представления данных до программных алгоритмов — играет важную роль в общей производительности, и их гармоничное сочетание становится залогом успеха в конкурентной борьбе за высокие места в рейтингах TPC-H. Продвинутые компании и исследователи в области баз данных продолжают совершенствовать эти методы, развивая и расширяя инструментарий для еще более эффективной аналитической обработки.

TPC-H остается мощным инструментом для тестирования и демонстрации пропускной способности систем и позволяет наблюдать за эволюцией технологий хранения и обработки на практике. Следующий этап своего развития данные технологии найдут в более сложных сценариях TPC-DS, где на первый план выйдут еще более масштабные и сложные задачи. Изучение примера TPC-H Query 1 — отличная точка отправления для всех, кто хочет углубиться в тему создания высокопроизводительных аналитических решений и понять реальные принципы оптимизации систем хранения и обработки данных в современном мире.